增长式卷积神经网络及其在人脸检测中的应用

第21卷第8期

系统仿真学报?V ol. 21 No. 8 2009年4月Journal of System Simulation Apr., 2009 增长式卷积神经网络及其在人脸检测中的应用

顾佳玲,彭宏京

(南京工业大学信息科学与工程学院, 南京 210009)

摘要:卷积神经网络擅于提取具有类别分辨能力的隐式特征,在人脸检测等领域获得巨大成功。

然而典型的卷积神经网络的固定结构又使得网络规模初始设定只能是经验性的,难以实现后继的再

学习。鉴于此,提出一种结构可变的卷积神经网络的构造方法:从每层只有单个卷积核的简单网

络结构开始训练,逐渐为各网络层增加新的卷积神经元并修改新增连接权重,当训练结果达到预

期目标时训练结束。在人脸检测的实验中,不同网络规模下的识别结果表明基于结构增长生成的

网络可以在精确度和网络规模之间取得一个非常好的折衷。此外,在追加新的学习样本时,分类

器在保持原有学习结果基础上,只需调整少量新增神经元的权值,就能明显提高检测率。

关键词:卷积神经网络;机器学习;人脸检测;神经网络;模式分类

中图分类号:TP391 文献标识码:A 文章编号:1004-731X (2009) 08-2441-05

Incremental Convolution Neural Network

and Its Application in Face Detection

GU Jia-ling, PENG Hong-jing

(The College of Information Science and Engineering, Nanjing University of Technology, Nanjing 210009, China) Abstract: Convolution neural networks have the capability of extracting hidden discriminating features, so that they successfully have been applied in the fields of face detection, etc. Due to their fixed architecture, the scale of neural networks usually depends on the designer’s experience and prevents them from learning further. A novel approach of constructing CNN with varying architecture was proposed. Training neural networks started off with the simplest architecture with single neuron each layer, then adding new neural cells in every layer and modifying their corresponding weights continuously, until training target was reached.In the face detection experiments, various results with different network scales were given.

These results illustrate that the CNN can get a good tradeoff between the detection rate and the architecture size.Moreover, if appending new complementing samples, the detection rate can be improved significantly, only adjusting a few adding neurons’ weights while keeping previous weights unchanging.

Key words: convolution networks; machine learning; face detection; neural networks; pattern classification

引言

人脸检测是指在输入图像中确定所有人脸(如果存在)位置的过程。它在图像检索、视觉监视和新一代人机界面等领域都有着巨大的应用价值,一直是模式识别和人工智能等领域的重要研究课题。人脸检测虽然属于二值分类问题,但由于人脸的特殊性,比如外貌、表情、肤色的不同,或者有眼镜、胡须等附属物,以及光照、遮挡等影响使得在复杂环境下检测检测人脸蕴涵巨大挑战。

通常将人脸检测方法分为:(1)、基于几何特征的方法。利用人类面部器官在几何上体现的特征在图像中定位人脸,由于对人脸面部器官制定精确恰当的判定准则非常困难,因此该方法在实际中应用并不广泛;(2)、基于肤色模型的方法。在彩色图像中,利用肤色信息可以定位出图像中皮肤所在位置,但是算法的准确度极度依赖于色度空间的选择,又容易受到光照的影响,只适合简单背景下的人脸检测;(3)、基于统计理论的人脸检测方法。这一类方法着眼于寻找大量人脸

收稿日期:2007-08-26 修回日期:2007-11-25

作者简介:顾佳玲(1982-), 女, 江苏省, 硕士生, 研究方向为模式识别与图象处理;彭宏京 (1965-), 男, 江西省, 博士, 副教授, 研究方向为模式识别与计算机视觉、数据挖掘。和非脸样本在统计特性上的差异,再使用各自的特征构建分类器,是目前的主流方法[1]。如Moghaddam等[2]发展了传统PCA方法,在计算主成分空间的基础上引入了正交补空间。Rowley等[3]将人脸区域划分为多个矩形子区域,每个区域对应一个神经网络隐含单元,再对神经网络在多个分级上的输出进行判决。梁等[4]使用模板匹配先进行候选区域的粗选,然后采用SVM分类器进行分类。Viola[5]

等提出基于积分图像特征AdaBoost方法使用层叠分类器检测灰度静态图像中的人脸。近些年,无须改变输入图像的拓扑结构,可以直接作用于二维图像的卷积神经网络在人脸识别中的应用也日渐受到关注。

Jose Hiroki Saito[6]通过选择最优的的阈值调节卷积神经网络的性能。Christophe 等[7]在2002年采用一个包含三层卷积神经网络CNN结构检测人脸,在前两层中,每层包含一个卷积层和下采样层,第三层是一个用于分类识别的MLP 层。在2004年,Christophe 等 [8]在保留了原先的网络结构的基础上,对训练过程中收集样本的算法进行进一步改进。在多数情况下,这个结构庞大的卷积神经网络的检测结果明显优于别的检测算法,如Rowley[3]的神经网络方法和Viola[5]的Adaboost方法。但是整个网络的检测速度比Adaboost方

2009年4月 系

统 仿 真 学 报 Apr., 2009

法慢了近四倍!此外,结构固定的卷积网络也不适合后期样本的补充学习,它往往需要推翻之前的学习成果,重新建立新的权值,浪费了前期的学习。

针对以上两个问题,本文提出了一个基于结构增长的学习方法用于生成和训练网络。与当前用于检测算法的卷积网络[7][8]相比,它有两大改进之处。第一,其结构根据训练要求的提高不断增长,随着网络的每一次的增长,它的检测速度可能小幅下降,但检测率却大幅提高,最终可以使网络处于一个兼顾速度与准确度的平衡结构。第二,基于结构增长的网络,对于后期新增加的样本的学习,不采用全部重新学习的方式,而是增加一些新的神经元用于对新样本的学习,这样的学习方法便于保留前期的学习结果。

1 卷积神经网络

主流的分类方式几乎都是基于统计特征的[1],这就意味着在进行分辨前必须提取某些特征。然而,显式的特征提取并不容易,在一些应用问题中也并非总是可靠的。卷积神经网络,它避免了显式的特征取样,隐式地从训练数据中进行学习。这使得卷积神经网络明显有别于其他基于神经网络的分类器,通过结构重组和减少权值将特征提取功能融合进多层感知器。它可以直接处理灰度图片,能够直接用于处理基于图像的分类[7-8]。

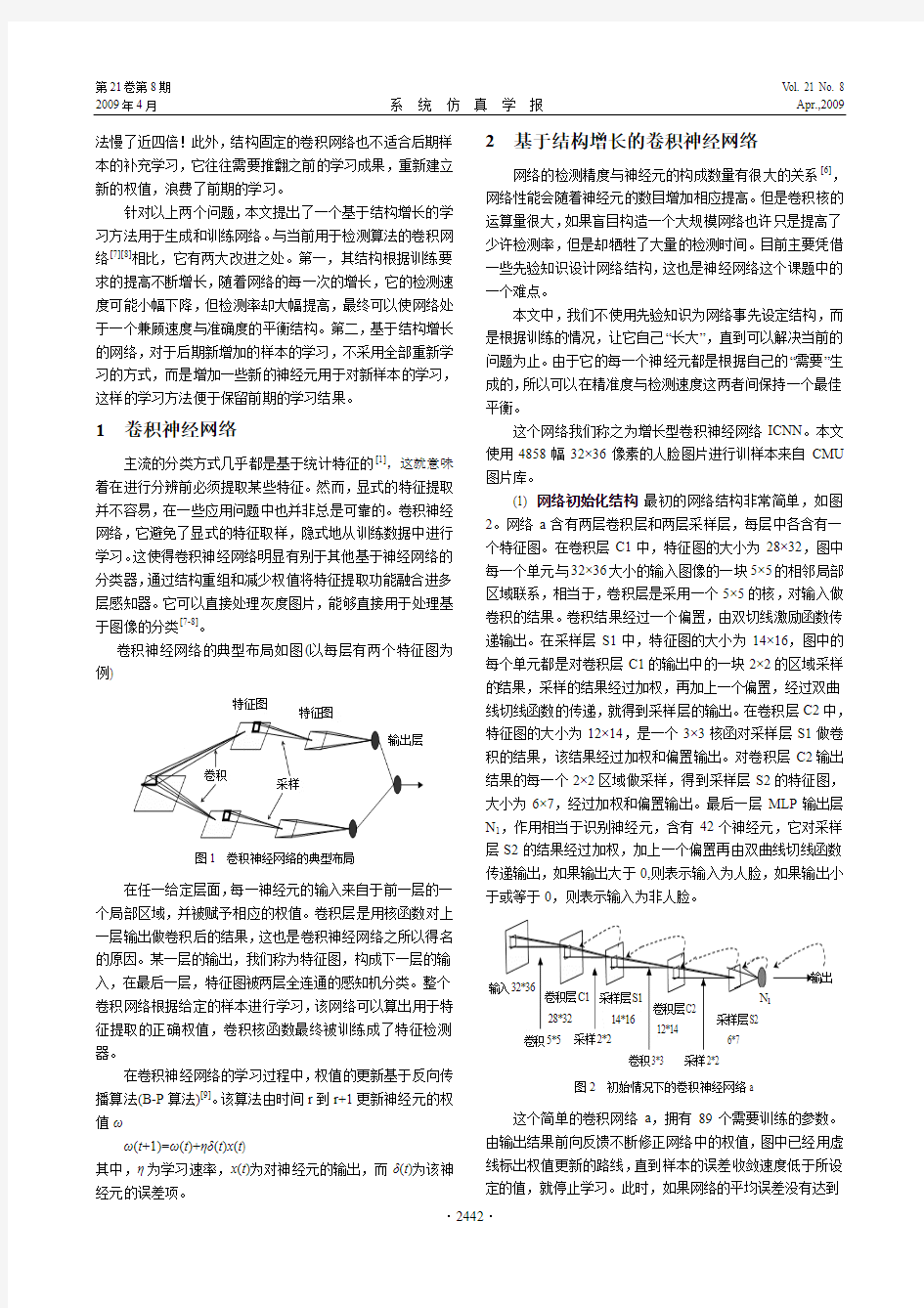

卷积神经网络的典型布局如图(以每层有两个特征图为例)

图1 卷积神经网络的典型布局

在任一给定层面,每一神经元的输入来自于前一层的一个局部区域,并被赋予相应的权值。卷积层是用核函数对上一层输出做卷积后的结果,这也是卷积神经网络之所以得名的原因。某一层的输出,我们称为特征图,构成下一层的输入,在最后一层,特征图被两层全连通的感知机分类。整个卷积网络根据给定的样本进行学习,该网络可以算出用于特征提取的正确权值,卷积核函数最终被训练成了特征检测器。

在卷积神经网络的学习过程中,权值的更新基于反向传播算法(B-P 算法)[9]。该算法由时间r 到r+1更新神经元的权值ω

ω(t +1)=ω(t )+ηδ(t )x (t )

其中,η为学习速率,x (t )为对神经元的输出,而δ(t )为该神经元的误差项。 2 基于结构增长的卷积神经网络

网络的检测精度与神经元的构成数量有很大的关系[6],网络性能会随着神经元的数目增加相应提高。但是卷积核的运算量很大,如果盲目构造一个大规模网络也许只是提高了少许检测率,但是却牺牲了大量的检测时间。目前主要凭借一些先验知识设计网络结构,这也是神经网络这个课题中的一个难点。

本文中,我们不使用先验知识为网络事先设定结构,而是根据训练的情况,让它自己“长大”,直到可以解决当前的问题为止。由于它的每一个神经元都是根据自己的“需要”生成的,所以可以在精准度与检测速度这两者间保持一个最佳平衡。

这个网络我们称之为增长型卷积神经网络ICNN 。本文使用4858幅32×36像素的人脸图片进行训样本来自CMU 图片库。

(1) 网络初始化结构 最初的网络结构非常简单,如图2。网络a 含有两层卷积层和两层采样层,每层中各含有一个特征图。在卷积层C1中,特征图的大小为28×32,图中每一个单元与32×36大小的输入图像的一块5×5的相邻局部区域联系,相当于,卷积层是采用一个5×5的核,对输入做卷积的结果。卷积结果经过一个偏置,由双切线激励函数传递输出。在采样层S1中,特征图的大小为14×16,图中的每个单元都是对卷积层C1的输出中的一块2×2的区域采样的结果,采样的结果经过加权,再加上一个偏置,经过双曲

线切线函数的传递,就得到采样层的输出。在卷积层C2中,特征图的大小为12×14,是一个3×3核函对采样层S1做卷积的结果,该结果经过加权和偏置输出。对卷积层C2输出结果的每一个2×2区域做采样,得到采样层S2的特征图,大小为6×7,经过加权和偏置输出。最后一层MLP 输出层

N 1,作用相当于识别神经元,含有42个神经元,它对采样层S2的结果经过加权,加上一个偏置再由双曲线切线函数传递输出,如果输出大于0,则表示输入为人脸,如果输出小于或等于0,则表示输入为非人脸。

图2 初始情况下的卷积神经网络a

这个简单的卷积网络a ,拥有89个需要训练的参数。由输出结果前向反馈不断修正网络中的权值,图中已经用虚线标出权值更新的路线,直到样本的误差收敛速度低于所设定的值,就停止学习。此时,如果网络的平均误差没有达到

特征图

特征图

输出层

采样

卷积

输入32*36

卷积层C128*32

14*16

采样层S1卷积层C2 12*14

采样层S2 6*7

N 1

输出

采样2*2

卷积3*3 采样2*2

卷积5*5

2009年4月 顾佳玲,等:增长式卷积神经网络及其在人脸检测中的应用 Apr., 2009

期望要求,那么训练过程进入第一轮的增长。

(2) 第一次增长 我们开始对网络a 进行第一轮的增长,为网络的卷积层和采样层各添加一张特征图,感知器层N 1 的神经元也增加到了84个,此时N 1已经不再是输出层,网络增加了一个感知器层N 2做为输出层,该层含有两个神经元,与N 1层的输出做全连接,对N 1的输出经过加权和偏置,由激励函数传递输出。将N 2层的初始权值设为[0.5 0.5],阈值设为0。增长后的网络结构如图3所示,称为网络b 。观 察这个网络,卷积层,采样层和第一层感知器层N 1都没有全连接,总体看来,这个网络由两条前向分支①和②组成,最后在输出层实现全连通。两条支路都拥有和网络a 同样的权值,分支①就是训练成熟的网络a ,相当于在分支①的基础上增加了一条支路②。这样的网络几乎保留了网络a 的全部学习结果。在运用B-P 算法进行学习时,我们的权值修改路线始终只沿着新增加的神经元反向传递,图4中用虚线标出了权值的修改路线,在对网络b 进行学习的整个过程中,支路①相当于网络a 已经训练成熟的知识,将它的结果保留下来,不做修正。

图3 网络a 经过第一轮的增长得到卷积神经网络b

整个网络b ,拥有181个参数,其中需要训练的参数有92个。网络不断地修正一条支路的权值,直到整个网络的总体误差收敛速度低于所设定的值,就停止学习。此时,如果网络的平均误差仍然没有达到期望要求,那么训练过程进入下一轮,也就是第二轮的增长。

(3) 第二次增长 继续增长,网络的层数不再增加,在网络b 的基础上增加了分支③,由采样层S1中所含有的两张特征图融合,构成卷积层C2的第三张特征图。对特征图进行融合可以增加特征的多样性,此时卷积层C2和采样层S2中的特征图都增加到三幅,N 1层的神经元数也增至126个,如图4,称其为网络c 。对新增加的神经元初始化,在新一轮的学习中,我们的学习路线始终只通过输出层以及分支③,图中用虚线表示。保留分支①和②的权值不变,它们相当于已经网络之前已经训练成熟的部分,不再对其进行学习。

整个网络 c ,拥有240个参数,其中需要训练的参数有62个。网络不断的修正支路③的权值,直到整个网络的总体误差收敛速度低于所设定的值,就停止学习。此时,如果网络的平均误差仍然没有达到期望要求,那么训练过程继续。

图4 网络b 经过第二轮的增长得到卷积神经网络c

下面给出整个网络结构的增长算法:

J(ω)=训练样本平均误差,θ=事先设定的样本平均误差的阈值, J(ω)=▽训练样本误差收敛速度,θ=▽事先设定的误差收敛速度的阈值

NS = S1层的特征图的数目,NC = C2层的特征图的数目 if J(ω)> θ //整个网络的训练目标还没有达到,训练继续 if J(ω)> ▽▽θ// 不需要增加新的神经元,只需训练 以指定路线用成批方法训练网络

else //此时需要增加新的神经元,分别在两种情况下的添加方法各不一样

if NC = C+NS

以整个网络的输入层为起点增加一条支路 else

以S1层为起点,增加一条新的支路,将S1层中任意两张还没有互相融合的特征图融合,做为新加入的支路的起点

else

训练结束,网络训练成熟

3 结构增长式网络的后期学习

神经网络的学习并不是一劳永逸的,因为不可能一次收集完所有的样本类型,相对人脸样本,非人脸的样本更难收集。我们可以把自然界中人脸之外的全部世界称为“非人脸”,由于“非人脸”样本的多样性,所以许多人脸分类器的虚警率都很高[6]。而网络的后期学习就可以较好地解决非人脸样本收集不足的问题。

与人类的学习过程类似,神经网络的学习也需要后期复习、巩固,加强。所以,在设计网络时也应考虑到使其便于后期学习。后期学习与在线学习类似,都相当于是一个补充性的学习。结构固定的网络在每一次训练之后都会修改全部的权值,如果后期样本与前期训练样本有较大差异,比如光线强度明显不同,那么后期学习中若是只学习新添加的样本,极可能导致卷积网络分类器虽然学会了新的东西,却丢失了原有的训练“记忆”

而本文设计的网络的第二大优势就在于此,它为后期新样本增加了新的神经元来进行后期学习,学习过程只修改新增加的神经元的权值,对原本已经训练成熟的神经元不再做学习,这就相当于保留了前期的训练结果,并且又学习了新的知识。

① 采样层S1

卷积层C2 卷积5*5

采样2*2

6*7

卷积层C1 卷积层C2 采样2*2

28*32

输入32*36

卷积3*3

12*14

14*16N 1

N 2

输出

②

输入32*36

采样层S2 卷积层C2 采样层S1

14*1612*14 6*7

N 1

采样2*2

卷积3*3

采样2*2

卷积层C1卷积5*528*32

N 2①

② ③

⑦

2009年4月 系

统 仿 真 学 报 Apr., 2009

单支路ICNN 94.12% 0.0602 2支路ICNN 96.03% 0.121 3支路ICNN 96.482% 0.138 4支路ICNN 97.39% 0.1982 5支路ICNN 97.58% 0.2164 6支路ICNN 97.79% 0.2346 7支路ICNN 97.85% 0.2949 8支路ICNN 97.89% 0.3131 9支路ICNN 97.94% 0.3313 10支路ICNN 98.01% 0.3495 11支路ICNN 98.06% 0.4103 Carcia 等[8 ] 98.05% 0.375

首先使用5858幅后期训练样本对Carcia 的网络进行训练。由于不能改变结构,也不能增加神经元,因此只能对整个网络重新训练,训练结束后识别率上升到98.67%,提高了0.62%。

然而本文的增长式网络却能方便地进行后期学习,首先如图5所示为网络增加新的神经元和线索,再使用5858幅后期训练样本对新增的神经元进行训练,训练结束后增长识别率也上升到了98.28%,提高了0.6%,使用我们的方法只学习了少量神经元,仍然取得了较好的学习效果,而且网络的学习时间只需要Carcia 方法的六分之一,并不需要重新调整所有神经元的权值就可以继续学习新样本,显示了本文的增

在后期训练中我们新增了一千幅图片,人脸和非人脸样本各五百,为了弥补前期训练样本的不足,此次特地选择了比较复杂的非人脸背景。

经过前期4858幅样本的学习,当网络结构成型时,共含有六条分支,现在根据增长算法为新增样本加入新的神经元,如图5,其中分支⑦是新加入的神经元,使用一千幅新增样本对新增加的神经元进行训练,图中已经用虚线标出了权值修改的路线。由于后期的训练样本不再使用原先成批学习的样本,所以为了防止后期学习造成过拟合,这里并不是简单的以训练集的平均误差做为训练是否终止的标志,而是使用交叉验证技术,采用一个独立的验证集,当在一个独立的验证集上的误差达到最小时,就停止训练。

图5 卷积网络分类器在进行后期训练

4 实验结果

Carcia 等[8]的神经网络是一个经典的卷积网络模型,为了与本文提出的增量学习式的网络在两方面进行性能比较,本文首先采用4858幅样本对两者进行前期的成批训练,一方面是比较经过前期训练的网络的检测速度与精确度性能,第二方面是关于两个网络对于新增样本的后期学习的效果比较。

4.1 前期训练结果比较

首先使用10000张与训练图片同样大小的识别图片对前期效果进行测试。

当网络生长到11分支时,它在检测图片库的识别率已经超过了Carcia 的方法,但是此时网络的规模也已过大,耗费时间大于Carcia ,这样的结果肯定了这样一个事实,网络的识别率是和规模成正比的,如果希望识别率更高,可以继续增大网络规模。使用这种结构增长式网络最主要的目的,就是在识别率和识别速度这两个要素之间取得一个平衡, 综合两个因素,决定放弃最后加入的几个分支,网络最终将分支维持在六条。虽然6分支的ICNN 的识别率比Carcia 略低,但是所耗费的识别时间却只有后者的63%。这里存在争议,7分支的网络识别率更高些,而速度也不算太慢,但是与6分支的网络相比,它的识别率只提高了0.06%,但是识别速度却降低了25%,所以综合考虑我们决定选择6分支的卷积神经网络。

再使用一些来源于网络的图片为两者的检测率做一下比较,经过后期训练之后,ICNN 的人脸检测率为91.8%,虚警数为213。Carcia 等的检测率为92.5%,虚警数为187。但是前者的复杂度远小于后者,只有后者的63%。

4.2 后期训练结果比较

前期训练的检测结果表明网络在复杂背景下的虚警较高,于是如第4节所描述的,增加一千幅新的样本进行后期学习。

之前我们已经使用了Cmu 图片库中的10000幅图片做了初步的识别,称为测试图片库,识别结果如表1,其中错检221幅,主要的错检对象是一些倾斜角度较大,光线不良的图片。因此,我们另外收集了1000幅人脸非人脸样本,其中有针对性的选择了一些倾斜角度较大,光线不佳的图片,再加上原先用于训练的4858幅样本,总共5858幅图片做为我们的后期训练样本。同时,另外再从Cmu 图片库中选择8000幅图片做为验证图片集。

表1 前期训练结果比较

检测率

每张图片检 测时间(秒)

2009年4月 顾佳玲,等:增长式卷积神经网络及其在人脸检测中的应用 Apr., 2009

长式卷积网络与传统网络相比的优势。

再重新使用先前的来源于网络的图片为两者的检测率做一下比较,证实经过后期训练,检测率也有一定提高,由

原先的91.8%上升到92.3%,虚警数由213下降到158。本文方法检测人脸的部分结果如图6

所示。

图6 ICNN 所检测的部分图片结果

5 结论

本文主要阐述一种构造卷积网络的思想,它利用增量的方式从最简单的网络开始增长,生成一个检测速度很快而网络规模却相对较小的的卷积网络。在文中,我们在决定网络最终如何定型时,将检测速度放在了比较重要的位置,适合于对检测速度要求较高的网络,比如类似于工业上的自动分类;但是对于某些对检测率要求高的情况下,如果以速度作为代价,理论上它的精确率可以逼近任意值,最终的实验结果中,主要的漏检目标为脸部过分偏斜和光照不均匀的人面,在Carcia [8]

的实验中,他采用了大量偏移角度在20至60 度范围内或是光线不良的人脸图片作为训练对象,总的训练图片库超过五万张,最后在网络图片中的检测结果,检测率为95.3%,虚警为104。但是在使用同一样本库训练的大前提,与文献[8]的检测结果对比中,本文的理论仍然有较明显的优点。

参考文献:

[1] 孙宁. 人脸检测综述[J]. 电路与系统学报, 2006, 11(6): 104-108. [2]

B Moghaddam, A Pentland. Probabilistic visual learning for object

representation [J]. IEEE Trans Pattern Analysis and Machine Intelligence (S0162-8828), 1997, 19(7): 696-710.

[3]

H Rowley, S Baluja, T Kanade. Neural Network-Based Face Detection [J]. IEEE Trans Pattern Analysis and Machine Intelligence (S0162-8828), 1998, 20(1): 23-38.

[4] 梁路宏, 艾海舟, 肖习攀. 基于模板匹配与支持向量机的人脸检测[J]. 计算机学报, 2002, 25(1): 22-29.

[5]

Paul Viola. Rapid Object Detection using a Boosted Cascade of Simple Features [C]// IEEE Conference on Computer Vision and Patter Recognition (S0162-8828), 2001. USA: IEEE, 2001.

[6] Jose Hiroki Saito, et al . Using CMU PIE Human Face Database to a Convolutional Neural Network-Neocognitron [R]// European Symposium on Artificial Neural Networks Bruges, Belgium: ESANN, 2005,(4): 27-29.

[7]

C Carcia, M Delakis. A Neural Architecture for Fast and Robust Face Detection, Proceeding [R]// 16th th International Conference on Pattern Recognition. Canada: ICPR, 2002, (2): 44-47.

[8] C Carcia, M Delakis. Convolutional Face Finder: A Neural

Architecture for Fast and Robust Face Detection [J]. IEEE Trans. Patterns Analysis and Machine Intelligence (S0162-8828), 2004, 26(11): 1408-1421. [9]

白润才 李建刚 郭旭颖. 基于图形用户界面的BP 神经网络建模与仿真[J]. 系统仿真学报, 2005, 17(11): 2825-2827.

基于深度卷积神经网络的图像分类

SHANGHAI JIAO TONG UNIVERSITY 论文题目:基于卷积神经网络的自然图像分类技术研究 姓名: 高小宁 专业:控制科学与工程

基于卷积神经网络的自然图像分类技术研究 摘要:卷积神经网络已在图像分类领域取得了很好的效果,但其网络结构及参数的选择对图像分类的效果和效率有较大的影响。为改善卷积网络的图像分类性能,本文对卷积神经网络模型进行了详细的理论分析,并通过大量的对比实验,得出了影响卷积网络性能的因素。结合理论分析及对比实验,本文设计了一个卷积层数为8层的深度卷积网络,并结合Batch Normalization、dropout等方法,在CIFAR-10数据集上取得了%的分类精度,有效地提高了卷积神经网络的分类效果。 关键词:卷积神经网络,图像分类,Batch Normalization,Dropout Research on Natural Image Classification Based on Convolution Neural Network Abstract: Convolution neural network has achieved very good results in image classification, but its network structure and the choice of parameters have a greater impact on image classification efficiency and efficiency. In order to improve the image classification performance of the convolution network, a convolutional neural network model is analyzed in detail, and a large number of contrastive experiments are conducted to get the factors that influence the performance of the convolution network. Combining the theory analysis and contrast experiment, a convolution layer depth convolution network with 8 layers is designed. Combined with Batch Normalization and dropout, % classification accuracy is achieved on CIFAR-10 dataset. Which improves the classification effect of convolution neural network. Key Words: Convolution neural network(CNN), image classification, Batch Normalization, Dropout

基于深度卷积神经网络的人脸识别研究

基于深度卷积神经网络的人脸识别研究 深度卷积神经网络主要应用包括语音识别、图像处理、自然语言处理等。本文就当前大环境下研究了卷积神经网络模型在静态环境下人脸识别领域的应用。卷积神经网络模型需要设计一个可行的网络模型,将大量的人脸训练数据集加载到网络模型中,然后进行自动训练,这样就可以得到很好的识别率。把训练好的模型保存下来,那么这个模型就是一个端到端的人脸特征提取器。该方法虽然操作简单,但是需要根据训练数据集设计合理的网络结构,而且最难的关键点是超参数的调整和优化算法的设计。因此本文结合残差网络和融合网络构建了两个与计算资源和数据资源相匹配的网络模型,并通过反复调整超参数和调试优化器使其在训练集上能够收敛,最终还取得较好的识别率。 本文的主要研宄内容和创新点如下: 1.介绍了卷积神经网络的基础理论知识。先从传统人工神经网络的模型结构、前向和反向传播算法进行了详细的分析;然后过渡到卷积神经网络的相关理论,对其重要组成部分如卷积层、激励层、池化层和全连接层进行了具体的阐述;最后对卷积神经网络训练时的一些注意事项进行了说明。 人工神经元是构成人工神经网络的基本计算单元,单个神经元的模型结构如下图所示。

其中,b X W b x w Z T+ = + =∑1 1 1 ) ( ) ( , z f x h h w = x x x x x e e e e z z f e z z f - - - + - = = + = = ) tanh( ) ( 1 1 ) ( ) (σ 卷积神经网路的基本结构

简单的池化过程: 2.对深度学习框架TensorFlow的系统架构和编程模型作了一些说明,并对人脸数据进行预处理,包括人脸检测、数据增强、图像标准化和人脸中心损失。

卷积神经网络CNN原理、改进及应用

一、简介 卷积神经网络(Convolutional Neural Networks,简称CNN)是近年发展起来,并引起广泛重视的一种高效的识别方法。 1962年,Hubel和Wiesel在研究猫脑皮层中用于局部敏感和方向选择的神经元时发现其独特的局部互连网络结构可以有效地降低反馈神经网络的复杂性,继而提出了卷积神经网络[1](Convolutional Neural Networks-简称CNN)7863。现在,CNN已经成为众多科学领域的研究热点之一,特别是在模式分类领域,由于该网络避免了对图像的复杂前期预处理,可以直接输入原始图像,因而得到了更为广泛的应用。 Fukushima在1980年基于神经元间的局部连通性和图像的层次组织转换,为解决模式识别问题,提出的新识别机(Neocognitron)是卷积神经网络的第一个实现网络[2]。他指出,当在不同位置应用具有相同参数的神经元作为前一层的patches时,能够实现平移不变性1296。随着1986年BP算法以及T-C问题[3](即权值共享和池化)9508的提出,LeCun和其合作者遵循这一想法,使用误差梯度(the error gradient)设计和训练卷积神经网络,在一些模式识别任务中获得了最先进的性能[4][5]。在1998年,他们建立了一个多层人工神经网络,被称为LeNet-5[5],用于手写数字分类,这是第一个正式的卷积神经网络模型3579。类似于一般的神经网络,LeNet-5有多层,利用BP算法来训练参数。它可以获得原始图像的有效表示,使得直接从原始像素(几乎不经过预处理)中识别视觉模式成为可能。然而,由于当时大型训练数据和计算能力的缺乏,使得LeNet-5在面对更复杂的问题时,如大规模图像和视频分类,不能表现出良好的性能。 因此,在接下来近十年的时间里,卷积神经网络的相关研究趋于停滞,原因有两个:一是研究人员意识到多层神经网络在进行BP训练时的计算量极其之大,当时的硬件计算能力完全不可能实现;二是包括SVM在内的浅层机器学习算法也渐渐开始暂露头脚。直到2006年,Hinton终于一鸣惊人,在《科学》上发表文章,使得CNN再度觉醒,并取得长足发展。随后,更多的科研工作者对该网络进行了改进。其中,值得注意的是Krizhevsky等人提出的一个经典的CNN架构,相对于图像分类任务之前的方法,在性能方面表现出了显著的改善2674。他们方法的整体架构,即AlexNet[9](也叫ImageNet),与LeNet-5相似,但具有更深的结构。它包括8个学习层(5个卷积与池化层和3个全连接层),前边的几层划分到2个GPU上,(和ImageNet是同一个)并且它在卷积层使用ReLU作为非线性激活函数,在全连接层使用Dropout减少过拟合。该深度网络在ImageNet 大赛上夺冠,进一步掀起了CNN学习热潮。 一般地,CNN包括两种基本的计算,其一为特征提取,每个神经元的输入与前一层的局部接受域相连,并提取该局部的特征。一旦该局部特征被提取后,它与其它特征间的位置关系也随之确定下来;其二是特征映射,网络的每个计算层由多个特征映射组成,每个特征映射是一个平面,平面上所有神经元的权值相等。特征映射结构采用影响函数核小的sigmoid函数作为卷积网络的激活函数,使得特征映射具有位移不变性。此外,由于一个映射面上的神经元共享权值,因而减少了网络自由参数的个数。这两种操作形成了CNN的卷积层。此外,卷积神经网络中的每一个卷积层都紧跟着一个用来求局部平均与二次提取的计算层,即池化层,这种特有的两次特征提取结构减小了特征分辨率。

(完整版)卷积神经网络CNN原理、改进及应用

卷积神经网络(CNN) 一、简介 卷积神经网络(Convolutional Neural Networks,简称CNN)是近年发展起来,并引起广泛重视的一种高效的识别方法。 1962年,Hubel和Wiesel在研究猫脑皮层中用于局部敏感和方向选择的神经元时发现其独特的局部互连网络结构可以有效地降低反馈神经网络的复杂性,继而提出了卷积神经网络[1](Convolutional Neural Networks-简称CNN)7863。现在,CNN已经成为众多科学领域的研究热点之一,特别是在模式分类领域,由于该网络避免了对图像的复杂前期预处理,可以直接输入原始图像,因而得到了更为广泛的应用。 Fukushima在1980年基于神经元间的局部连通性和图像的层次组织转换,为解决模式识别问题,提出的新识别机(Neocognitron)是卷积神经网络的第一个实现网络[2]。他指出,当在不同位置应用具有相同参数的神经元作为前一层的patches时,能够实现平移不变性1296。随着1986年BP算法以及T-C问题[3](即权值共享和池化)9508的提出,LeCun和其合作者遵循这一想法,使用误差梯度(the error gradient)设计和训练卷积神经网络,在一些模式识别任务中获得了最先进的性能[4][5]。在1998年,他们建立了一个多层人工神经网络,被称为LeNet-5[5],用于手写数字分类,这是第一个正式的卷积神经网

络模型3579。类似于一般的神经网络,LeNet-5有多层,利用BP算法来训练参数。它可以获得原始图像的有效表示,使得直接从原始像素(几乎不经过预处理)中识别视觉模式成为可能。然而,由于当时大型训练数据和计算能力的缺乏,使得LeNet-5在面对更复杂的问题时,如大规模图像和视频分类,不能表现出良好的性能。 因此,在接下来近十年的时间里,卷积神经网络的相关研究趋于停滞,原因有两个:一是研究人员意识到多层神经网络在进行BP训练时的计算量极其之大,当时的硬件计算能力完全不可能实现;二是包括SVM在内的浅层机器学习算法也渐渐开始暂露头脚。直到2006年,Hinton终于一鸣惊人,在《科学》上发表文章,使得CNN再度觉醒,并取得长足发展。随后,更多的科研工作者对该网络进行了改进。其中,值得注意的是Krizhevsky等人提出的一个经典的CNN架构,相对于图像分类任务之前的方法,在性能方面表现出了显著的改善2674。他们方法的整体架构,即AlexNet[9](也叫ImageNet),与LeNet-5相似,但具有更深的结构。它包括8个学习层(5个卷积与池化层和3个全连接层),前边的几层划分到2个GPU上,(和ImageNet 是同一个)并且它在卷积层使用ReLU作为非线性激活函数,在全连接层使用Dropout减少过拟合。该深度网络在ImageNet大赛上夺冠,进一步掀起了CNN学习热潮。 一般地,CNN包括两种基本的计算,其一为特征提取,每个神经元的输入与前一层的局部接受域相连,并提取该局部的特征。一旦该

基于深度卷积神经网络的图像分类

Equation Chapter 1 Section 1 令狐采学 SHANGHAI JIAO TONG UNIVERSITY 论文题目:基于卷积神经网络的自然图像分类技术研究 姓名: 高小宁 专业:控制科学与工程

基于卷积神经网络的自然图像分类技术研究 摘要:卷积神经网络已在图像分类领域取得了很好的效果,但其网络结构及参数的选择对图像分类的效果和效率有较年夜的影响。为改良卷积网络的图像分类性能,本文对卷积神经网络模型进行了详细的理论阐发,并通过年夜量的比较实验,得出了影响卷积网络性能的因素。结合理论阐发及比较实验,本文设计了一个卷积层数为8层的深度卷积网络,并结合Batch Normalization、dropout等办法,在CIFAR10数据集上取得了88.1%的分类精度,有效地提高了卷积神经网络的分类效果。 关键词:卷积神经网络,图像分类,Batch Normalization,Dropout Research on Natural Image Classification Based on Convolution Neural Network Abstract: Convolution neural network has achieved very good results in image classification, but its network structure and the choice of parameters have a greater impact on image classification efficiency and efficiency. In order to improve the image classification performance of the convolution network, a convolutional neural network model is analyzed in detail, and a large number of contrastive experiments are conducted to get the factors that influence the performance of the convolution network. Combining the theory analysis and contrast experiment, a convolution layer depth convolution network with 8 layers is designed. Combined with Batch Normalization and dropout, 88.1% classification accuracy is achieved on CIFAR10 dataset. Which improves the classification effect of convolution neural network. Key Words:Convolution neural network(CNN), image classification, Batch Normalization,Dropout 目录 基于卷积神经网络的自然图像分类技术研究- 1 - 1引言-2- 2卷积神经网络的模型阐发-3- 2.1网络基本拓扑结构- 3 - 2.2卷积和池化- 4 - 2.3激活函数- 5 - 2.4 Softmax分类器与价格函数- 6 - 2.5学习算法- 7 - 2.6 Dropout- 9 - 2.7 Batch Normalization- 10 - 3模型设计与实验阐发-10- 3.1 CIFAR10数据集- 10 - 3.2 模型设计- 11 -

基于卷积神经网络的人脸识别

《计算机系统项目综合实践》课程报告报告题目:基于卷积神经网络的人脸识别 组长:班级:*学号:*姓名:* 在本项实践中的贡献百分比: 40 % 组员1:班级: * 学号: * 姓名:* 在本项实践中的贡献百分比: 35 % 组员2:班级: * 学号:* 姓名:* 在本项实践中的贡献百分比: 25 % 日期: 2019/12/18

一、课程实践目标和内容概述:(各组员对本部分内容撰写的贡献比例,组长:组员1:组员2 = 20% : 20% : 60%) 1. 打算设计和实现一个什么样的计算机综合系统?该系统有什么功能?为什么选择该系统作为实践内容? 基于卷积神经网络的人脸识别。 通过10个人的420张192*168大小单一色彩图片对系统进行训练,从而使系统能够识别这十个人,在通过220张人脸的图片进行识别,统计识别精度,通过调整参数不断使测试精度达到最优,获得使测试精度达到最大的参数集合。 人脸识别应用在生活中十分广泛,卷积神经网络用于人脸识别是一种基于特征的方法,区别于传统的人工特征提取和针对特征的高性能分类器设计,它的优点是通过逐层卷积降维进行特征提取,然后经过多层非线性映射,使网络可以从未经特殊处理的训练样本中,自动学习形成适应该识别任务的特征提取器和分类器,该方法降低了对训练样本的要求,而且网络的层数越多,学习到的特征更具有全局性。因此,我们小组打算将该系统作为实践内容。 2. 运用什么程序设计语言或开发工具实现系统?为什么采用这种开发语言或工具? 运用MATLAB实现。 MATLAB具有封装的卷积神经网络,我们只需要对其设置层数和参数即可。而且MATLAB将数值分析、矩阵计算、科学数据可视化以及非线性动态系统的建模和仿真等诸多强大功能集成在一个易于使用的视窗环境中,

基于深度卷积神经网络的目标检测

第35卷 第8期 福 建 电 脑 Vol. 35 No.8 2019年8月 Journal of Fujian Computer Aug. 2019 ——————————————— 程胜月,男,1995生,硕士研究生,研究方向为深度学习。E-mail:2968365693@https://www.sodocs.net/doc/215288266.html, 。张德贤,男,1961生,博士,研究方向为模式识别、人工智能信息处理。 基于深度卷积神经网络的目标检测 程胜月 张德贤 (河南工业大学信息科学与工程学院 郑州 450001) 摘 要 目标检测是计算机视觉领域中最基本、最具挑战性的课题之一,由于传统检测方法已经不能满足其在精度和速度上需求,深度学习利用其对图像特征强大地分析处理能力,逐渐成为目标检测的主流方向。本文首先对主流卷积神经网络框架进行简述,其次对目标检测中的几种重要的方法具体分析,最后对未来可能的发展方向进行讨论。 关键词 目标检测;卷积神经网络;RCNN ;YOLO ;SSD 中图法分类号 TP183 DOI:10.16707/https://www.sodocs.net/doc/215288266.html,ki.fjpc.2019.08.009 Target Detection Based on Deep Convolutional Neural Networks CHENG Shengyue, ZHANG Dexian (School of Information Science and Engineering, Henan University of Technology, Zhengzhou,China, 450001) 1引言 目标检测作为计算机视觉的基本问题之一,是 许多其他计算机视觉任务的基础,如实例分割、图像处理、对象跟踪等[1]。目前,目标检测已广泛应用于无人驾驶、安防监管、视频分析等领域。 传统目标检测方法包含预处理、窗口滑动、特征提取、特征选择、特征分类、后处理等步骤。而卷积神经网络本身具有特征提取、特征选择和特征分类的功能,所以在现在计算能力充足的情况下得到充分发展。 2主流深度卷积网络的发展 1998年Yann LeCun 提出的LeNet-5网络是首次成功应用于数字识别问题的卷积神经网络。但是由于当时计算能力不足,未能受到重视。直到2012年AlexNet 在ImageNet 图像分类任务竞赛中获得冠军,目标检测才迎来深度卷积神经网络的时代。 2.1 AlexNet AlexNet 由5个卷积层和3个全连接层组成,使用数据增广和Dropout 防止过拟合,并且提出了 局部响应归一化来提高模型的泛化能力。 2.2 VGGNet VGGNet 获得了2014年ILSVRC 比赛的亚军和目标定位的冠军。到目前为止,VGGNet 依然被广泛使用来提取图像的特征。VGGNet 主要是证明了增加网络的深度可以提高最终的性能。 2.3 GoogleNet GoogleNet 分析得出增加网络的深度和宽度可以提升性能,但同时不可避免的增加参数,造成过拟合和计算量过大。因此提出Inception 结构将稀疏矩阵聚类成相对稠密的子空间矩阵提高计算性能。 2.2 ResNet ResNet 指出随着卷积神经网络深度的增加,却出现梯度消失现象造成准确率的下降。ResNet 通过恒等映射解决深层网络梯度消失问题,大幅度提升深度卷积网络的性能。 3目标检测算法 手工设计特征的目标检测方法在2010年左右

基于深度卷积神经网络的人脸识别研究定稿版

基于深度卷积神经网络的人脸识别研究 HUA system office room 【HUA16H-TTMS2A-HUAS8Q8-HUAH1688】

基于深度卷积神经网络的人脸识别研究 深度卷积神经网络主要应用包括语音识别、图像处理、自然语言处理等。本文就当前大环境下研究了卷积神经网络模型在静态环境下人脸识别领域的应用。卷积神经网络模型需要设计一个可行的网络模型,将大量的人脸训练数据集加载到网络模型中,然后进行自动训练,这样就可以得到很好的识别率。把训练好的模型保存下来,那么这个模型就是一个端到端的人脸特征提取器。该方法虽然操作简单,但是需要根据训练数据集设计合理的网络结构,而且最难的关键点是超参数的调整和优化算法的设计。因此本文结合残差网络和融合网络构建了两个与计算资源和数据资源相匹配的网络模型,并通过反复调整超参数和调试优化器使其在训练集上能够收敛,最终还取得较好的识别率。 本文的主要研宄内容和创新点如下: 1.介绍了卷积神经网络的基础理论知识。先从传统人工神经网络的模型结构、前向和反向传播算法进行了详细的分析;然后过渡到卷积神经网络的相关理论,对其重要组成部分如卷积层、激励层、池化层和全连接层进行了具体的阐述;最后对卷积神经网络训练时的一些注意事项进行了说明。 人工神经元是构成人工神经网络的基本计算单元,单个神经元的模型结构如下图所示。 其中, b X W b x w Z T+ = + =∑1 1 1 ) ( ) ( , z f x h h w = 卷积神经网路的基本结构简单的池化过程:

2.对深度学习框架TensorFlow的系统架构和编程模型作了一些说明,并对人脸数据进行预处理,包括人脸检测、数据增强、图像标准化和人脸中心损失。 TensorFlow的系统架构如下图所示 TensorFlow的编程模式 系统本地模式和分布式模式示意图 3.提出了基于改进的MyVGGNet和MySqueezeNet网络的人脸识别。首先分析了模型VGGNet-16和SqueezeNe的网络结构及相关参数,然后本文提出将原VGGNet-16和SqueezeNe的网络结构和参数进行优化,并在每个卷积层和激励层之间添加批归一化层,在VGGNet-16网络末尾用1个1 * 1的卷积层代替三个全连接层,还增加全局平均池化层,得到新的MyVGGNet和MySqueezeNet模型,最后在LFW数据集上分别获得9 4.3%和9 5.1%的准确率。 VGGNet-16 网络结构框图 MyVGGNet 网络框图 MyVGGNet网络训练时LFW测试集的准确率走势图 MyVGGNet网络在LFW上的ROC曲线图 4.提出了基于二叉树型融合网络BTreeFuseNet_v1和BTreeFuseNet_v2的人脸识别。首先对深度神经网络的优化问题和融合原理作了分析;然后结合残差学习,融入分支并行、融合和级联三种结构,采用ReLU函数、BN层、Dropout层、哈维尔方法和截断高斯函数初始化方法、Adam优化器等技巧,构建了两个层次深度为22和19的网络模型

卷积神经网络

卷积神经网络 摘要:卷积神经网络是近年来广泛应用于模式识别、图像处理等领域的一种高效识别算法,它具有结构简单、训练参数少和适应性强等特点。本文从卷积神经网络的发展历史开始,详细阐述了卷积神经网络的网络结构、神经元模型和训练算法。在此基础上以卷积神经网络在人脸检测和形状识别方面的应用为例,简单介绍了卷积神经网络在工程上的应用,并给出了设计思路和网络结构。 关键字:模型;结构;训练算法;人脸检测;形状识别 0 引言 卷积神经网络是人工神经网络的一种已成为当前语音分析和图像识别领域的研究热点,它的权值共享网络结构使之更类似于生物神经网络,降低了网络模型的复杂度,减少了权值的数量。该优点在网络的输入是多维图像时表现的更为明显,使图像可以直接作为网络的输入,避免了传统识别算法中复杂的特征提取和数据重建过程。卷积网络是为识别二维形状而特殊设计的一个多层感知器,这种网络结构对平移、比例缩放、倾斜或者共他形式的变形具有高度不变性。 1 卷积神经网络的发展历史 1962年Hubel和Wiesel通过对猫视觉皮层细胞的研究,提出了感受野(receptive field)的概念,1984年日本学者Fukushima基于感受野概念提出的神经认知机(neocognitron)可以看作是卷积神经网络的第一个实现网络,也是感受野概念在人工神经网络领域的首次应用。神经认知机将一个视觉模式分解成许多子模式(特征),然后进入分层递阶式相连的特征平面进行处理,它试图将视觉系统模型化,使其能够在即使物体有位移或轻微变形的时候,也能完成识别。神经认知机能够利用位移恒定能力从激励模式中学习,并且可识别这些模式的变化形,在其后的应用研究中,Fukushima将神经认知机主要用于手写数字的识别。随后,国内外的研究人员提出多种卷积神经网络形式,在邮政编码识别和人脸识别方面得到了大规模的应用。 通常神经认知机包含两类神经元,即承担特征抽取的S-元和抗变形的C-元。S-元中涉及两个重要参数,即感受野与阈值参数,前者确定输入连接的数目,后者则控制对特征子模式的反应程度。许多学者一直致力于提高神经认知机的性能的研究:在传统的神经认知机中,每个S-元的感光区中由C-元带来的视觉模糊量呈正态分布。如果感光区的边缘所产生的模糊效果要比中央来得大,S-元将会接受这种非正态模糊所导致的更大的变形容忍性。我们希望得到的是,训练模式与变形刺激模式在感受野的边缘与其中心所产生的效果之间的差异变得越来越大。为了有效地形成这种非正态模糊,Fukushima提出了带双C-元层的改进型神经认知机。 Trotin 等人提出了动态构造神经认知机并自动降低闭值的方法[1],初始态的神经认知机各层的神经元数目设为零,然后会对于给定的应用找到合适的网络规模。在构造网络过程中,利用一个反馈信号来预测降低阈值的效果,再基于这种预测来调节阈值。他们指出这种自动阈值调节后的识别率与手工设置阈值的识别率相若,然而,上述反馈信号的具体机制并未给出,并且在他们后来的研究中承认这种自动阈值调节是很困难的【8】。 Hildebrandt将神经认知机看作是一种线性相关分类器,也通过修改阈值以使神经认知机成为最优的分类器。Lovell应用Hildebrandt的训练方法却没有成功。对此,Hildebrandt 解释的是,该方法只能应用于输出层,而不能应用于网络的每一层。事实上,Hildebrandt 没有考虑信息在网络传播中会逐层丢失。 Van Ooyen和Niehuis为提高神经认知机的区别能力引入了一个新的参数。事实上,该参数作为一种抑制信号,抑制了神经元对重复激励特征的激励。多数神经网络在权值中记忆训练信息。根据Hebb学习规则,某种特征训练的次数越多,在以后的识别过程中就越容易

卷积神经网络全面解析之算法实现

卷积神经网络全面解析之算法实现 前言 从理解卷积神经到实现它,前后花了一个月时间,现在也还有一些地方没有理解透彻,CNN还是有一定难度的,不是看哪个的博客和一两篇论文就明白了,主要还是靠自己去专研,阅读推荐列表在末尾的参考文献。目前实现的CNN在MINIT数据集上效果还不错,但是还有一些bug,因为最近比较忙,先把之前做的总结一下,以后再继续优化。 卷积神经网络CNN是Deep Learning的一个重要算法,在很多应用上表现出卓越的效果,[1]中对比多重算法在文档字符识别的效果,结论是CNN优于其他所有的算法。CNN 在手写体识别取得最好的效果,[2]将CNN应用在基于人脸的性别识别,效果也非常不错。前段时间我用BP神经网络对手机拍照图片的数字进行识别,效果还算不错,接近98%,但在汉字识别上表现不佳,于是想试试卷积神经网络。 1、CNN的整体网络结构 卷积神经网络是在BP神经网络的改进,与BP类似,都采用了前向传播计算输出值,反向传播调整权重和偏置;CNN与标准的BP最大的不同是:CNN中相邻层之间的神经单元并不是全连接,而是部分连接,也就是某个神经单元的感知区域来自于上层的部分神经单元,而不是像BP那样与所有的神经单元相连接。CNN的有三个重要的思想架构: ?局部区域感知 ?权重共享 ?空间或时间上的采样 局部区域感知能够发现数据的一些局部特征,比如图片上的一个角,一段弧,这些基本特征是构成动物视觉的基础[3];而BP中,所有的像素点是一堆混乱的点,相互之间的关系没有被挖掘。 CNN中每一层的由多个map组成,每个map由多个神经单元组成,同一个map的所有神经单元共用一个卷积核(即权重),卷积核往往代表一个特征,比如某个卷积和代表一段弧,那么把这个卷积核在整个图片上滚一下,卷积值较大的区域就很有可能是一段弧。注意卷积核其实就是权重,我们并不需要单独去计算一个卷积,而是一个固定大小的权重矩阵去图像上匹配时,这个操作与卷积类似,因此我们称为卷积神经网络,实际上,BP也可以看做一种特殊的卷积神经网络,只是这个卷积核就是某层的所有权重,即感知区域是整个图像。权重共享策略减少了需要训练的参数,使得训练出来的模型的泛华能力更强。 采样的目的主要是混淆特征的具体位置,因为某个特征找出来后,它的具体位置已经不重要了,我们只需要这个特征与其他的相对位置,比如一个“8”,当我们得到了上面一个"o"时,我们不需要知道它在图像的具体位置,只需要知道它下面又是一个“o”我们就可以知道是一个'8'了,因为图片中"8"在图片中偏左或者偏右都不影响我们认识它,这种混淆具体位置的策略能对变形和扭曲的图片进行识别。 CNN的这三个特点是其对输入数据在空间(主要针对图像数据)上和时间(主要针对时间序列数据,参考TDNN)上的扭曲有很强的鲁棒性。CNN一般采用卷积层与采样层交

卷积神经网络CNN代码解析-matlab

卷积神经网络CNN代码解析 deepLearnToolbox-master是一个深度学习matlab包,里面含有很多机器学习算法,如卷积神经网络CNN,深度信念网络DBN,自动编码AutoEncoder(堆栈SAE,卷积CAE)的作者是Rasmus Berg Palm (rasmusbergpalm@https://www.sodocs.net/doc/215288266.html,) 代码下载:https://https://www.sodocs.net/doc/215288266.html,/rasmusbergpalm/DeepLearnToolbox 这里我们介绍deepLearnToolbox-master中的CNN部分。 DeepLearnToolbox-master中CNN内的函数: 调用关系为: 该模型使用了mnist的数字mnist_uint8.mat作为训练样本,作为cnn的一个使用样例, 每个样本特征为一个28*28=的向量。

网络结构为: 让我们来看看各个函数: 一、Test_example_CNN: (2) 三、cnntrain.m (5) 四、cnnff.m (6) 五、cnnbp.m (7) 五、cnnapplygrads.m (10) 六、cnntest.m (11) 一、Test_example_CNN: Test_example_CNN: 1设置CNN的基本参数规格,如卷积、降采样层的数量,卷积核的大小、降采样的降幅 2 cnnsetup函数初始化卷积核、偏置等 3 cnntrain函数训练cnn,把训练数据分成batch,然后调用 3.1 cnnff 完成训练的前向过程,

3.2 cnnbp计算并传递神经网络的error,并计算梯度(权重的修改量) 3.3 cnnapplygrads 把计算出来的梯度加到原始模型上去 4 cnntest 函数,测试当前模型的准确率 该模型采用的数据为mnist_uint8.mat, 含有70000个手写数字样本其中60000作为训练样本,10000作为测试样本。把数据转成相应的格式,并归一化。 设置网络结构及训练参数 初始化网络,对数据进行批训练,验证模型准确率 绘制均方误差曲线 二、Cnnsetup.m 该函数你用于初始化CNN的参数。 设置各层的mapsize大小, 初始化卷积层的卷积核、bias 尾部单层感知机的参数设置 * bias统一设置为0

深度学习-卷积神经网络应用

手写数字识别实验报告 实验目的 利用python和深度学习框架搭建手写数字识别的神经网络,并进行相关的仿真实验,尽可能的提高识别的准确度。 实验环境 python3.6、Pytorch1.4.0、torchvision、MNIST数据库。 环境介绍 Python Python是一个高层次的结合了解释性、编译性、互动性和面向对象的脚本语言。Python的设计具有很强的可读性,相比其他语言经常使用英文关键字,其他语言的一些标点符号,它具有比其他语言更有特色语法结构。Python具有简单易学、明确优雅、开发速度快等特点,在人工智能、数据分析、云计算、网络爬虫等方面有着广泛的应用。 Pytorch Pytorch是torch的python版本,是由Facebook开源的神经网络框架,专门针对GPU 加速的深度神经网络(DNN)编程。Torch是一个经典的对多维矩阵数据进行操作的张量(tensor)库,在机器学习和其他数学密集型应用有广泛应用。与TensorFlow的静态计算图不同,Pytorch的计算图是动态的,可以根据计算需要实时改变计算图。Pytorch的设计追求最少的封装,尽量避免重复造轮子。Pytorch的源码只有TensorFlow的十分之一左右,更少的抽象、更直观的设计使得Pytorch的源码十分易于阅读。同时Pytorch的灵活性不以速度为代价,在许多评测中,Pytorch的速度表现胜过TensorFlow和Keras等框架。Pytorch提供了完整的文档,循序渐进的指南。 MNIST数据库 MNIST是一个入门级的计算机视觉数据集,它包括6万张28x28的训练样本,1万张测试样本,可以说是CV里的“Hello Word”。它也包含每一张图片对应的标签,告诉我们这个是数字几。比如,图1的标签分别是5,0,4,1。

卷积神经网络

卷积神经网络Newly compiled on November 23, 2020

卷积神经网络 摘要:卷积神经网络是近年来广泛应用于模式识别、图像处理等领域的一种高效识别算法,它具有结构简单、训练参数少和适应性强等特点。本文从卷积神经网络的发展历史开始,详细阐述了卷积神经网络的网络结构、神经元模型和训练算法。在此基础上以卷积神经网络在人脸检测和形状识别方面的应用为例,简单介绍了卷积神经网络在工程上的应用,并给出了设计思路和网络结构。 关键字:模型;结构;训练算法;人脸检测;形状识别 0 引言 卷积神经网络是人工神经网络的一种已成为当前语音分析和图像识别领域的研究热点,它的权值共享网络结构使之更类似于生物神经网络,降低了网络模型的复杂度,减少了权值的数量。该优点在网络的输入是多维图像时表现的更为明显,使图像可以直接作为网络的输入,避免了传统识别算法中复杂的特征提取和数据重建过程。卷积网络是为识别二维形状而特殊设计的一个多层感知器,这种网络结构对平移、比例缩放、倾斜或者共他形式的变形具有高度不变性。 1 卷积神经网络的发展历史 1962年Hubel和Wiesel通过对猫视觉皮层细胞的研究,提出了感受野(receptive field)的概念,1984年日本学者Fukushima基于感受野概念提出的神经认知机(neocognitron)可以看作是卷积神经网络的第一个实现网络,也是感受野概念在人工神经网络领域的首次应用。神经认知机将一个视觉模式分解成许多子模式(特征),然后进入分层递阶式相连的特征平面进行处理,它试图将视觉系统模型化,使其能够在即使物体有位移或轻微变形的时候,也能完成识别。神经认知机能够利用位移恒定能力从激励模式中学习,并且可识别这些模式的变化形,在其后的应用研究中,Fukushima将神经认知机主要用于手写数字的识别。随后,国内外的研究人员提出多种卷积神经网络形式,在邮政编码识别和人脸识别方面得到了大规模的应用。

人工智能原理-基于Python语言和TensorFlow-卷积神经网络

人工智能原理: 基于Python语言和TensorFlow 张明 副教授

第六章:卷积神经网络 1.卷积神经网络 2.卷积神经网络的模型架构 3.卷积运算 4.卷积常见层 5.TensorFlow和图像 6.模型训练 7.模型评估 8.多GPU的模型训练

6.1:卷积神经网络 应用:是深度学习技术中极具代表的网络结构之一,属于人工神经网络的一种。它在许多最新的神经网络模型中都有具体的应用,并被应用于多个实际领域中,其中应用最频繁,也是应用最成功的领域就是图像处理。在国际标准的ImageNet数据集上,许多成功的模型都是基于卷积神经网络的应用。 优点:卷积神经网络包含了一个由卷积层和子采样层构成的特征抽取器。在卷积神经网络的一个卷积层中,通常包含了若干个特征平面,每个特征平面都是由一些矩形排列的神经元所构成,同一特征平面的神经元共享权值,这里共享的权值就是卷积核。卷积核带来的直接好处就是减少了网络中各层之间的连接,同时又降低了过拟合的风险。子采样层也叫作池化,通常有均值子采样和最大值子采样两种形式。子采样可以看作一种特殊的卷积过程。卷积和子采样大大简化了模型的复杂度,减少了模型的参数。

6.1:卷积神经网络 卷积神经网络(Convolutional Neural Network, CNN)是深度学习技术中极具代表的网络结构之一,属于人工神经网络的一种。其应用最成功的领域就是图像处理。在国际标准的ImageNet数据集上,许多成功的模型都是基于卷积神经网络的应用。 卷积神经网络相较于传统的图像处理算法的优点在与避免了对图像处理时复杂的前期预处理过程(提取人工特征等),可以直接输入原始图像。