Linux 系统日志收集分析系统

Linux 系统日志收集分析系统

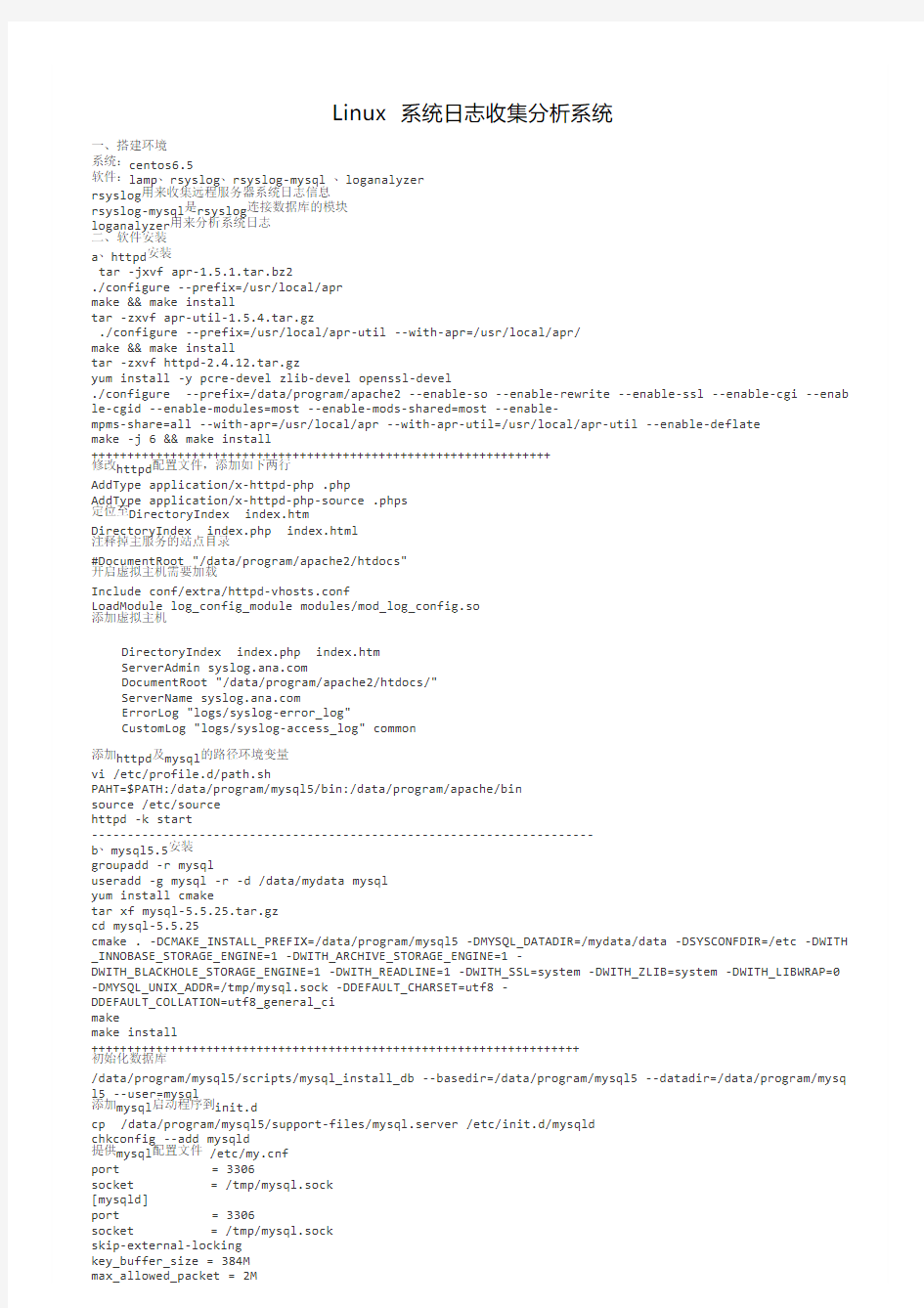

一、搭建环境

系统:centos6.5

软件:lamp、rsyslog、rsyslog-mysql 、loganalyzer

rsyslog用来收集远程服务器系统日志信息

rsyslog-mysql是rsyslog连接数据库的模块

loganalyzer用来分析系统日志

二、软件安装

a、httpd安装

tar -jxvf apr-1.5.1.tar.bz2

./configure --prefix=/usr/local/apr

make && make install

tar -zxvf apr-util-1.5.4.tar.gz

./configure --prefix=/usr/local/apr-util --with-apr=/usr/local/apr/

make && make install

tar -zxvf httpd-2.4.12.tar.gz

yum install -y pcre-devel zlib-devel openssl-devel

./configure --prefix=/data/program/apache2 --enable-so --enable-rewrite --enable-ssl --enable-cgi --enab le-cgid --enable-modules=most --enable-mods-shared=most --enable-

mpms-share=all --with-apr=/usr/local/apr --with-apr-util=/usr/local/apr-util --enable-deflate

make -j 6 && make install

++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++

修改httpd配置文件,添加如下两行

AddType application/x-httpd-php .php

AddType application/x-httpd-php-source .phps

定位至DirectoryIndex index.htm

DirectoryIndex index.php index.html

注释掉主服务的站点目录

#DocumentRoot "/data/program/apache2/htdocs"

开启虚拟主机需要加载

Include conf/extra/httpd-vhosts.conf

LoadModule log_config_module modules/mod_log_config.so

添加虚拟主机

DirectoryIndex index.php index.htm

ServerAdmin https://www.sodocs.net/doc/4d16735417.html,

DocumentRoot "/data/program/apache2/htdocs/"

ServerName https://www.sodocs.net/doc/4d16735417.html,

ErrorLog "logs/syslog-error_log"

CustomLog "logs/syslog-access_log" common

添加httpd及mysql的路径环境变量

vi /etc/profile.d/path.sh

PAHT=$PATH:/data/program/mysql5/bin:/data/program/apache/bin

source /etc/source

httpd -k start

----------------------------------------------------------------------

b、mysql5.5安装

groupadd -r mysql

useradd -g mysql -r -d /data/mydata mysql

yum install cmake

tar xf mysql-5.5.25.tar.gz

cd mysql-5.5.25

cmake . -DCMAKE_INSTALL_PREFIX=/data/program/mysql5 -DMYSQL_DATADIR=/mydata/data -DSYSCONFDIR=/etc -DWITH _INNOBASE_STORAGE_ENGINE=1 -DWITH_ARCHIVE_STORAGE_ENGINE=1 -

DWITH_BLACKHOLE_STORAGE_ENGINE=1 -DWITH_READLINE=1 -DWITH_SSL=system -DWITH_ZLIB=system -DWITH_LIBWRAP=0 -DMYSQL_UNIX_ADDR=/tmp/mysql.sock -DDEFAULT_CHARSET=utf8 -

DDEFAULT_COLLATION=utf8_general_ci

make

make install

++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++

初始化数据库

/data/program/mysql5/scripts/mysql_install_db --basedir=/data/program/mysql5 --datadir=/data/program/mysq l5 --user=mysql

添加mysql启动程序到init.d

cp /data/program/mysql5/support-files/mysql.server /etc/init.d/mysqld

chkconfig --add mysqld

提供mysql配置文件 /etc/https://www.sodocs.net/doc/4d16735417.html,f

port = 3306

socket = /tmp/mysql.sock

[mysqld]

port = 3306

socket = /tmp/mysql.sock

skip-external-locking

key_buffer_size = 384M

max_allowed_packet = 2M

/var/log/secure

/var/log/spooler

{

sharedscripts

postrotate # 轮换之后重启rsyslog服务

/bin/kill -HUP `cat /var/run/syslogd.pid 2> /dev/null` 2> /dev/null || true

endscript

}

rsyslog服务端配置文件修改为:

vim /etc/ryslog.conf

$ModLoad imuxsock

$ModLoad imklog

$ModLoad imudp

$UDPServerRun 514

$ModLoad imtcp

$InputTCPServerRun 514

$ModLoad ommysql

$ActionFileDefaultTemplateRSYSLOG_TraditionalFileFormat

$IncludeConfig /etc/rsyslog.d/*.conf

$ModLoad ommysql

*.* :ommysql:10.100.4.84,Syslog,rsyslog,123456

#添加这行,这行表示把所有的设施的所有日志都记录到数据库服务器中的Syslog数据库中,以rsyslog用户,123456密码访问数据库cron.* /var/log/cron

*.emerg *

#添加这行,把其他行都注释掉,这行表示把所有的设施的所有日志都记录到数据库服务器中的Syslog数据库中,以rsyslog用户,1234 56密码访问数据库

local7.* /var/log/boot.log

rsyslog客户端配置文件:

*.* @10.100.4.84 #只需添加这行用于将日志发送到服务器端

service rsyslog restart

验证客户端的日志存放位置

在客户端执行

logger -p info "This is a test message"

tail -f /var/log/message

验证是否在服务器的/var/log/allsystem.log

响应的查询数据库的Syslog.SystemEvents表也能看到这条语句的插入,表示数据已经被写入数据库

----------------------------------------------------------------------

e、安装loganalyzer

mkdir -pv /data/program/apache2/htdocs/loganalyzer #此为loganalyzer程序存放路径

tar -zxvf loganalyzer-3.6.6.tar.gz

cd loganalyzer-3.6.6

mv src/* /data/program/apache2/htdocs/loganalyzer

mv contrib/*.sh /data/program/apache2/htdocs/loganalyzer

cd /data/program/apache2/htdocs/loganalyzer

sh configure.sh

sh secure.sh

chown -R daemon.daemon /data/program/apache2/htdocs/loganalyzer

chmod 644 config.php #安装的时候需要对此文件有写权限

三、安装loganalyzer

http://10.100.4.84/loganalyzer

提示没有配置文件,点击here利用向导生成

step1

step2

step3

step4

开始写入数据库

step5

step6

step7

设置监控日志保存到mysql数据库中,按照如图配置后NEXT step8

完成配置

step9

进入登录界面

问题处理:

安装完成后浏览器自动记录了用户密码,但在登录界面无法登录,提示账户密码错误,这个问题网上有高手已经解决了,参考他的处理办法就可以,本身mysql的配置文件中没有记录一般日志,而后台登录时记录在logcon_users表中,mysql密码是加密的所以要重现你登录密码的加密场景,在https://www.sodocs.net/doc/4d16735417.html,f 中开启一般日志general_log,浏览器登录在一般日志中可以看到

SELECT * FROM `logcon_users` WHERE username = 'admin' and password = '21232f297a57a5a743894a0e4a801fc3'

‘21232f297a57a5a743894a0e4a801fc3’就是密码密文

通过navicat将logcon_users的last_login字段设为允许为空

执行

insert into logcon_users

(username, password, is_admin) VALUES ('admin','21232f297a57a5a743894a0e4a801fc3',1);

Query OK, 1 row affected (0.06 sec)

再登录就没有问题了

看来是mysql在执行该语句时,发现last_login栏默认为非空,所以拒绝这条insert语句执行,解决办法就是将该栏设置为允许空值即可博主在线上老版本mysql-5.0.56无需进行上述手动操作,即可成功登录后台

但本篇出现的问题则是在mysql-5.6.10版本上

看来这应该不算是loganalyzer的BUG,应该是mysql在高版本执行insert语句提高了严谨性

系统下收集日志方法

收集日志操作如下: HPS 1、将附件HPSRPT_Enhanced_v9.0.00r2.zip 文件copy到目标服务器,存放在c:\ 2、解压到当前文件夹后双击运行HPSRPT_Enhanced_v9.0.00r2.cmd文件 3、不要关闭DOS运行窗口大约15分钟左右会自动消失说明运行完成。 4、完成后需要到C:\WINDOWS\HPSReports\Enhanced\Report\cab 目录下查看生成文件信息 5、收集对应时间点的cab文件即可。 第一个日志:ADU报告 2、打开开始——程序——HP System Tools——HP Array Configuration Utility——HP Array Configuration Utility。

3、选择Local Applcation Mode,本地应用模式。 4、打开了HP Array Configuration Utility工具后,点中间的Diagnostics选项卡,选中左侧的

阵列卡,右侧会出现2个按钮,查看和提取日志报告,我们选择Generate Diagnostic Report。 5、提示Reprot Generation Complete日志提取完毕,这时可以选择右下角Save report按钮。

6、选择保存,弹出保存菜单,点保存。 7、可以选择保存到桌面上。

第二个报告:survey报告 打开开始——程序——HP System Tools——HP Insight Diagnostics online Edition for Windows ——HP Insight Diagnostics online Edition for Windows。 9、提示安全证书报警,选择是,继续。

日志分析系统调研分析-ELK-EFK

日志分析系统 目录 一. 背景介绍 (2) 二.日志系统比较 (2) 1.怎样收集系统日志并进行分析 (2) A.实时模式: (2) B.准实时模式 (2) 2.常见的开源日志系统的比较 (3) A. FaceBook的Scribe (3) B. Apache的Chukwa (3) C. LinkedIn的Kafka (4) E. 总结 (8) 三.较为成熟的日志监控分析工具 (8) 1.ELK (9) A.ELK 简介 (9) B.ELK使用场景 (10) C.ELK的优势 (10) D.ELK的缺点: (11) 2.EFK (11) 3. Logstash 于FluentD(Fluentd)对比 (11)

一. 背景介绍 许多公司的平台每天会产生大量的日志(一般为流式数据,如,搜索引擎的pv,查询等),处理这些日志需要特定的日志系统,一般而言,这些系统需要具有以下特征: (1)构建应用系统和分析系统的桥梁,并将它们之间的关联解耦; (2)支持近实时的在线分析系统和类似于Hadoop之类的离线分析系统; (3)具有高可扩展性。即:当数据量增加时,可以通过增加节点进行水平扩展。二.日志系统比较 1.怎样收集系统日志并进行分析 A.实时模式: 1 在打印日志的服务器上部署agent 2 agent使用低耗方式将日志增量上传到计算集群 3 计算集群解析日志并计算出结果,尽量分布式、负载均衡,有必要的话(比如需要关联汇聚)则采用多层架构 4 计算结果写入最适合的存储(比如按时间周期分析的结果比较适合写入Time Series模式的存储) 5 搭建一套针对存储结构的查询系统、报表系统 补充:常用的计算技术是storm B.准实时模式 1 在打印日志的服务器上部署agent 2 agent使用低耗方式将日志增量上传到缓冲集群 3 缓冲集群将原始日志文件写入hdfs类型的存储 4 用hadoop任务驱动的解析日志和计算 5 计算结果写入hbase 6 用hadoop系列衍生的建模和查询工具来产出报表 补充:可以用hive来帮助简化

日志分析系统

Web日志集中管理系统的研究与实现 吴海燕朱靖君程志锐戚丽 (清华大学计算机与信息管理中心,北京100084) E-mail:wuhy@https://www.sodocs.net/doc/4d16735417.html, 摘要: Web服务是目前互联网的第一大网络服务,Web日志的分析对站点的安全管理与运行维护非常重要。在实际运行中,由于应用部署的分散性和负载均衡策略的使用,使得Web日志被分散在多台服务器上,给日志的管理和分析带来不便。本文设计并实现了一个Web日志集中管理系统(命名为ThuLog),系统包括日志集中、日志存储和日志分析三个模块。目前,该系统已经在清华大学的多个关键Web应用系统上进行了应用,能够帮助系统管理员清晰地了解系统运行情况,取得了较好的运行效果。 关键词:Web日志日志分析日志集中管理系统 The Research and Implementation of a Centralized Web Log Management System Wu Haiyan Zhu Jingjun Cheng Zhirui Qi Li (Computer&Information Center,Tsinghua University,Beijing100084) Abstract:Web is now the biggest network service on the Internet.The analysis of Web logs plays an important role in the security management and the maintenance of a website.But because of the decentralization of deployment and the use of load balancing,Web logs are often seperated on each Web server,which makes the management and analysis of them not so convenient.This paper designs and implements a Web Log Centralized Management System(named ThuLog),which includes3modules:the centralization of logs,the storage of logs and the analysis of logs.Through log analysis of several critical Web systems in Tsinghua University,it could help system administrators learn clearly what happens in information systems and achieves good operating results. Key words:Web Logs Log Analysis Web Log Centralized Management System 1.引言 近年来,随着计算机网络技术的迅速发展,Web正以其广泛性、交互性、快

技术参数日志实时监视系统提供实时的日志滚动显示和

技术参数:日志实时监视:系统提供实时的日志滚动显示和查询,可自定义实时监视的日志内容,可查看实时日志详细信息;统一监控主页:系统应提供从总体上把握日志告警和日志统计分析的实时综合性监控界面。界面由多个监控组件组成,用户可以自定义监控主页;生产厂商:北京启明星辰信息安全技术有限公司;日志关联分析告警:系统支持异常行为分析,维护一个与用户信息 系统相关的合法账号的正常行为集合,以此区分入侵者的行为和合法用户的异常行为;系统应至少默认有50条告警规则,系统提供可视化规则编辑器,对告警规则进行增删改查。系统内置针对服务器和其他安全设备的访问ip地址、访问账户和访问时间的访问控制规则;告警规则可按照树型结构组织,并可在该树型结构上直接查看该规则的告警信息,对告警日志可按各告警字 段进行分组排序。可对不同类型设备的日志之间进行关联分析,支持递归关联,统计关联,时序关联,这几种关联方式能同时应用于一个关联分析规则;日志审计查询:所有日志采用统一的日志查询界面,用户可以自定义各种查询场景。查询场景可保存,并可支持在查询结果中继续查询。支持原始消息中的关键字查询,可进行全文检索,可对查询结果进行分组排序,查询结 果可导出;二次开发接口:支持二次开发功能;型号:TSOC-SA-SW-SC;趋势分析:可对收集的日志根据过滤条件,针对设备地址、源地址、目标地址等进行事件数量等的趋势分析;支持端口监控:支持对服务器开启的无用端口、短时间使用不同的口令多次尝试连接服务器的审计;告警和响应管理:通过关联分析,对于发现的严重事件可以进行自动告警,告警内容支持 用户自定义字段。告警方式包括邮件、短信、SNMP Trap、Syslog等。响应方式包括:自动执行预定义脚本,自动将事件属性作为参数传递给特定命令行程序;移动存储介质使用痕迹审计:应能够对受控主机使用过的移动存储介质进行常规审计;应能够将受控主机删除后的移动存储介质使用痕迹进行深度审计;备份归档:支持数据库备份归档;支持历史日志恢复导入;支 持各种配置项的备份和导入;报表管理:提供丰富的报表管理功能,预定义了针对各类服务器、网络设备、防火墙、入侵检测系统、防病毒系统、终端安全管理系统、数据库、策略变更、流量,设备事件趋势以及总体报表,根据时间、数据类型等生成报表,提供导出以及邮件送达等服务;直观地为管理员提供决策和分析的数据基础,帮助管理员掌握网络及业务系统的状况。 报表可以保存为html、excel、pdf等多种格式。提供自定义报表,用户可根据自身需要进行定制。报表可根据设置自动运行,调度生成日报、周报和月报;日志实时分析和统计:可对收集的日志进行分类实时分析和统计,从而快速识别安全事故。分析统计结果支持柱图、饼图、曲线图等形式并自动实时刷新,图表数据支持数据下钻。日志实时图表数据支持数据下钻。日志实时分析在内存中完成,不需借助数据库和文件系统;告警查询:支持显示所有和按规则树结果分别显示告警事件信息,对告警查询结果字段可以分别二次排序显示;采集方式:审计中心可通过syslog、snmptrap、jdbc/odbc、agent等多种方式完成日志收集功能;告警:支持告警,告警动作支持多种常规告警方式;支持主机状态监控与审计:应能审计账户快照、操作系统版 本、主机名称、内存容量、硬盘容量、CPU信息等;售后服务内容:1、为最终用户提供技术服务热线。2、提供3年的产品授权和原厂服务,原厂服务为与产品出厂市场服务标准一致的原厂服务。3、提供5*8小时技术支持服务。4、提供如下 故障保修服务:两小时电话响应,两个工作日解决问题。对于未能解决的问题和故障应提供可行的升级方案等。5、发生非人为因素故障,在七日内免费对产品进行补充或者更换。;核心功能:对日志进行归一、汇总、分析将海量安全日志转化为少量安全事件;采集器:日志采集前置可以分布式部署,以降低网络传输、分散负载,可以在需要时增设新的日志采集前置,从而 提高系统的伸缩性;支持异常监控审计:主要审计终端电脑上对CPU占有率、内存占有率和运行时间超过策略中设置值的信息,包括计算机账户、IP地址、MAC地址、事件类型、运行时间等信息;支持多操作系统:支持Windows、Linux等主流操作系统;供货要求:供货商按照客户约定的时间和地点提供相应的产品和服务,并完成现场交付和安全调试:(1)负责产品的安 装与现场调试服务(2)完成软件的安装与调试服务(3)负责提供安装与调试所需的相应工具和设备等(4)负责提供所需相关保护设备。(5)交付产品时应提供配套的技术资料,包括但不限于:系统说明文件、用户手册(安装、操作、维护、故障排除)等;支持文件操作痕迹检查:系统应能够对主机文件操作痕迹进行检查,操作行为应包括:编辑、保存、复制、粘贴等常规文件操作行为;日志关联分析:系统具有日志关联分析的能力,能够对不同的日志进行相关性分析,发掘潜在的信息;系统支持编写自定义关联规则;品牌:启明/QEEMEE;过滤归并:支持对无用日志的可设置过滤条件和归并规则;支持未授权操作信息:支持对未经授权卸载、删除、修改终端审计;应能够审计未经过授权删除终端安装目录文件的日志,包括计算机账户、IP地址 、MAC地址、时间类型、进程路径、文件路径等信息;管理权限分级分域:管理员分级分权,可以自行设置管理员权限和策略。如管理员、安全员、操作员、审计员等。;报表:提供报表功能,支持自定义生成报表;是否需要安装:需要;综合日志审计:采集日志,日志信息汇集到审计中心,通过统一的控制台界面进行实时、可视化的呈现分析,能对网络设备、安全设备和 系统、主机操作系统、数据库以及各种应用系统的日志、事件、告警等安全信息进行全面的审计;日志范式化:系统具备日志范式化功能,实现对异构日志格式的统一化;针对不支持的事件类型做范式化不需改动编码,通过修改配置文件即可完成;日志审计对象:包括主流网络设备、安全设备、安全系统、主机操作系统、数据库、应用系统、网管系统告警日志、终端管理系

任务及日志管理系统建设方案

xxxxxxxxxxx 任务及日志管理系统 建设方案 2012年8月

四、总体设计-------------------- ---------------------------------------------------------------错误!未定义书签。** 系统安全设计 ----------------------------------------------------------------------------错- 误!未定义书签。一、概述-----------------------------------------------------------------------------------------错误!未定义书签。 二、建设内容-----------------------------------------------------------------------------------错误!未定义书签。 三、需求分析-----------------------------------------------------------------------------------错误!未定义书签。 ** 业务需求------------------------------------------------------------------------------------错-误!未定义书签。 ** 任务登记 ----------------------------------------------------------------------------错- 误!未定义书签。 ** 日志登记 ----------------------------------------------------------------------------错- 误!未定义书签。 ** 日志采集 ----------------------------------------------------------------------------错- 误!未定义书签。 ** 系统管理 ----------------------------------------------------------------------------错- 误!未定义书签。 ** 统计分析 ----------------------------------------------------------------------------错- 误!未定义书签。 ** 涉及部门或单位--------------------------------------------------------------------------错-误!未定义书签。 ** 用户角色------------------------------------------------------------------------------------错-误!未定义书签。 ** 信息安全要求-----------------------------------------------------------------------------错-误!未定义书签。 ** 运维要求-----------------------------------------------------------------------------------错-误!未定义书签。 ** 技术要求-----------------------------------------------------------------------------------错-误!未定义书签。 ** 设计原则-----------------------------------------------------------------------------------错-误!未定义书签。 ** 业务流程设计-----------------------------------------------------------------------------错-误!未定义书签。 ** 业务架构设计 ----------------------------------------------------------------------------错- 误!未定义书签。 ** 业务功能设计 ----------------------------------------------------------------------------错-- 误!未定义书签。 ** 普通用户端功能 -------------------------------------------------------------------错- 误!未定义书签。 ** 部门领导功能 ----------------------------------------------------------------------错- 误!未定义书签。 ** 任务提醒 -----------------------------------------------------------------------------错- 误!未定义书签。 ** 查询统计功能 -----------------------------------------------------------------------错- 误!未定义书签。 ** 系统管理 -----------------------------------------------------------------------------错- 误!未定义书签。 ** 流程定义-----------------------------------------------------------------------------错- 误!未定义书签。 ** 系统技术架构设计-----------------------------------------------------------------------错- 误!未定义书签。 ** 技术路线 ----------------------------------------------------------------------------------错- 误!未定义书签。 ** J2EE 体系结构 ---------------------------------------------------------------------错- 误!未定义书签。 ** AJAX 界面开发技术---------------------------------------------------------------错- 误!未定义书签。

Linux 系统日志收集分析系统

Linux 系统日志收集分析系统 一、搭建环境 系统:centos6.5 软件:lamp、rsyslog、rsyslog-mysql 、loganalyzer rsyslog用来收集远程服务器系统日志信息 rsyslog-mysql是rsyslog连接数据库的模块 loganalyzer用来分析系统日志 二、软件安装 a、httpd安装 tar -jxvf apr-1.5.1.tar.bz2 ./configure --prefix=/usr/local/apr make && make install tar -zxvf apr-util-1.5.4.tar.gz ./configure --prefix=/usr/local/apr-util --with-apr=/usr/local/apr/ make && make install tar -zxvf httpd-2.4.12.tar.gz yum install -y pcre-devel zlib-devel openssl-devel ./configure --prefix=/data/program/apache2 --enable-so --enable-rewrite --enable-ssl --enable-cgi --enab le-cgid --enable-modules=most --enable-mods-shared=most --enable- mpms-share=all --with-apr=/usr/local/apr --with-apr-util=/usr/local/apr-util --enable-deflate make -j 6 && make install ++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++ 修改httpd配置文件,添加如下两行 AddType application/x-httpd-php .php AddType application/x-httpd-php-source .phps 定位至DirectoryIndex index.htm DirectoryIndex index.php index.html 注释掉主服务的站点目录 #DocumentRoot "/data/program/apache2/htdocs" 开启虚拟主机需要加载 Include conf/extra/httpd-vhosts.conf LoadModule log_config_module modules/mod_log_config.so 添加虚拟主机

基于Flume的美团日志收集系统

基于Flume的美团日志收集系统(一)架构和设计

Agent 丰 富程度提供丰富的Agent,包括avro/thrift socket, text, tail等 主要是thrift端口 Store丰富程度可以直接写hdfs, text, console, tcp;写 hdfs时支持对text和sequence的压 缩; 提供buffer, network, file(hdfs, text)等 代码结构系统框架好,模块分明,易于开发代码简单 3 美团日志收集系统架构 美团的日志收集系统负责美团的所有业务日志的收集,并分别给Hadoop平台提供离线数据和Storm平台提供实时数据流。美团的日志收集系统基于Flume设计和搭建而成。目前每天收集和处理约T级别的日志数据。 下图是美团的日志收集系统的整体框架图。 a. 整个系统分为三层:Agent层,Collector层和Store层。其中Agent层每个机器部署一个进程,负责对单机的日志收集工作;Collector层部署在中心服务器上,负责接收Agent 层发送的日志,并且将日志根据路由规则写到相应的Store层中;Store层负责提供永久或者临时的日志存储服务,或者将日志流导向其它服务器。 b. Agent到Collector使用LoadBalance策略,将所有的日志均衡地发到所有的Collector上,达到负载均衡的目标,同时并处理单个Collector失效的问题。 c. Collector层的目标主要有三个:SinkHdfs, SinkKafka和SinkBypass。分别提供离线的数据到Hdfs,和提供实时的日志流到Kafka和Bypass。其中SinkHdfs又根据日志量的大小分为SinkHdfs_b,SinkHdfs_m和SinkHdfs_s三个Sink,以提高写入到Hdfs的性能,具体见后面介绍。 d. 对于Store来说,Hdfs负责永久地存储所有日志;Kafka存储最新的7天日志,并给Storm 系统提供实时日志流;Bypass负责给其它服务器和应用提供实时日志流。

日志审计管理系统需求说明书

日志审计管理系统需求说明书 一、总体要求 ?支持对主流操作系统、数据库系统、应用软件系统、网络设备、安全设 备进行自动采集。 ?支持SYSLOG和OPSEC LEA标准日志协议,能通过代理收集日志文件, 并将日志统一格式化处理。 ?对采集的日志可分类实时监控和自动告警。 ?对收集的日志信息可按日志所有属性进行组合查询和提供报表。 ?能按日志来源、类型、日期进行存储,支持日志加密压缩归档。 ?不影响日志源对象运行性能和安全。 ?操作简便直观,可用性好。 二、具体要求 2.1日志收集对象要求

用户可根据自己的需求很容易定制开发新的日志收集代理。 2.2 日志收集方式要求 需要支持的协议有syslog、snmp trap、windows log、checkpoint opsec、database、file、xml、soap等等。 ?主动信息采集 对路由器、交换机、防火墙、VPN、IDS/IPS等网络设备的日志采集支持采用SYSLOG(UDP514)和OPSEC LEA协议形式自动采集。 ?日志文件采集 支持本地系统平台上通过安装Agent采集日志文件中的日志信息。 ?性能状态探测 能获取系统平台的CPU、内存、端口使用率、应用的响应时间、进程数、TCP连接数、负载等性能参数。 2.3日志分析功能要求 2.3.1告警功能 ?支持对紧急、严重日志进行自动报警,可自定义需报警的日志类型。 ?监控台支持对收集的全部日志进行分类实时监控。 ?应该能够将各种不同的日志格式表示为统一的日志数据格式。且统一格 式时不能造成字段丢失。 ?能自动对各种类型的日志进行实时分析,并能将紧急、严重的事件日志 通过设备远程主控台、短信、邮件、电话语音提示等方式向管理员发送 实时告警消息,支持自定义报警日志的类型。 ?通过对网络设备及系统平台的性能状态、安全访问、异常事件产生的日

日志分析系统

日志分析系统 1.前言 随着江苏中烟信息化程度的不断提升,信息化系统的数目也不断增加,运维任务也不断增加。为了应对日益增加的信息化需求,提升服务质量,减轻运维工作,在信息系统服务化的基础上,迫切需要一个管理平台,实现对所有服务的管理和监控,这就是微服务平台。微服务平台能够实现devOps,服务的注册、发现、权限管理、监控、测试、故障预警,故障恢复等。 日志分析系统是微服务平台的重要组成部分,它能够对各服务的日志进行采集,存储,分析(找出异常的请求、统计报错情况、统计QPS、统计系统功能的使用情况、超负荷预警等)。同时,对系统资源的监控信息也可以以日志的形式,由日志分析系统分析。日志分析系统后台使用大数据平台来存储和分析日志,能够支持大量的日志,不需要担心日志的存储问题。 2.日志分析系统 2.1.功能 日志分析系统主要功能包括日志的采集、存储、分析。 日志采集常见的场景如:对webserver服务器的log文件进行监控,发现有变动时,采集变动的信息;对网络的某个端口监控,当此端口出现数据流时,采集数据流;监控程序定时的获取系统资源信息(同理,也适用于对JVM,tomcat的监控);采集Http请求和响应(同理适用于rpc远程调用)。 日志的存储使用大数据平台。根据日志的类型,可以以非结构化或者结构化数据存储,也可以使用图数据库存储。 日志分析包括日志的离线和在线分析。离线分析借助大数据平台提供的SQL,对日志数据库中的所有数据进行统计分析,适合于统计QPS,系统功能使用情况。在线分析(实时分析)处理即时产生的日志信息,适合于预警,异常请求的监控。 2.2.结构

3.实现 3.1.要求 ?能够适配不同的日志数据,例如web server log、rpc log、syslog ?能够处理突发的大流量数据 ?能够检测日志系统的个节点的运行状态,并自动恢复 ?能够方便的和Hive、Spark、Hbase等集成 ?稳定的运行,尽量少占用资源 3.2.日志收集和路由 logstash是一种分布式日志收集框架,非常简洁强大,经常与ElasticSearch,Kibana配置,组成著名的ELK技术栈,非常适合用来做日志数据的分析。Logstash分为Shipper(收集日志),Broker(日志集线器,可以连接多个Shipper),Indexer(日志存储)。Shipper 支持多种类型的日志文件,且可以自定义插件支持更多的种类。Logstash采用JRuby语言实现,插件开发相对困难。Logstash可以通过配置正则表达式的方式,将日志解析为结构化数

项目7 Flume日志采集系统-任务7.2 Flume采集方案说明与可靠性保证

B I T C 项目7 Flume日志采集系统任务7.2 Flume采集方案说明与可靠性保证 主讲教师:马东波

学习目标

章节概要 在大数据系统的开发中,数据收集工作无疑是开发者首要解决的一个难题,但由于生产数据的源头丰富多样,其中包含网站日志数据、后台监控数据、用户浏览网页数据等,数据工程师要想将它们分门别类的采集到HDFS系统中,就可以使用Apache Flume(数据采集)系统。 本章将针对Flume系统的基本概念、安装及应用方式详细讲 解,让读者掌握Flume系统的原理与应用。

C O N T E N T S Flume采集方案说明PART 01 Flume的可靠性保证 PART 02

Flume Sources 在编写Flume采集方案时,首先必须明确采集的数据源类型、出处;接着,根据这些信息与Flume已提供支持的Flume Sources进行匹配,选择对应的数据采集器类型 (即sources.type);再根据选择的数据采集器类型,配置必要和非必要的数据采集器 属性,Flume提供并支持的Flume Sources种类如下所示。 Avro Source Thrift Source Exec Source JMS Source Spooling Directory Source Twitter 1% firehose Source Kafka Source NetCat TCP Source NetCat UDP Source Sequence Generator Syslog TCP Source Multiport Syslog TCP Source Source Syslog UDP Source HTTP Source Stress Source Avro Legacy Source Thrift Legacy Source Custom Source Scribe Source Taildir Source

用Kibana和logstash快速搭建实时日志查询、收集与分析系统

用Kibana和logstash快速搭建实时日志查询、收集与分析系统 Logstash是一个完全开源的工具,他可以对你的日志进行收集、分析,并将其存储供以后使用(如,搜索),您可以使用它。说到搜索,logstash带有一个web界面,搜索和展示所有日志。 kibana 也是一个开源和免费的工具,他可以帮助您汇总、分析和搜索重要数据日志并提供友好的web界面。他可以为 Logstash 和 ElasticSearch 提供的日志分析的 Web 界面 说到这里,我们看看 kibana 和 logstash到底能为我们做些什么呢?下面是kibana的界面 简单来讲他具体的工作流程就是 logstash agent 监控并过滤日志,将过滤后的日志内容发给redis(这里的redis只处理队列不做存储),logstash index将日志收集在一起交给

全文搜索服务ElasticSearch 可以用ElasticSearch进行自定义搜索通过Kibana来结合自定义搜索进行页面展示,下图是 Kibana官网上的流程图 好了让我们一步步的把这套环境搭建起来吧,先看看都需要安装什么软件包 ruby 运行Kibana 必须, rubygems 安装ruby扩展必须 bundler 功能类似于yum JDK 运行java程序必须 redis 用来处理日志队列 logstash 收集、过滤日志

ElasticSearch 全文搜索服务(logstash集成了一个) kibana 页面展示 这里有三台服务器 192.168.233.128 logstash index,ElasticSearch,kibana,JDK 192.168.233.129 logstash agent,JDK 192.168.233.130 redis 首先到 logstash index服务器上面,logstash分为 index和aget ,agent负责监控、过滤日志,index负责收集日志并将日志交给ElasticSearch 做搜索 此外 logstash 的收集方式分为 standalone 和 centralized。 standalone 是所有功能都在一个服务器上面,自发自收,centralized 就是集中收集,一台服务器接收所有shipper(个人理解就是logstash agent)的日志。 其实 logstash本身不分什么 shipper 和 collector ,只不过就是配置文件不同而已,我们这次按照集中的方式来测试 在 logstash index上安装基础的软件环境 1.[19 2.168.23 3.128 root@nodec:~] 2.# cd /soft/ 3.[192.168.233.128 root@nodec:/soft] 4.# wget https://www.sodocs.net/doc/4d16735417.html,/distfiles/jdk-6u13-dlj-linux-i586. bin 5.从oracle下载实在是太慢了,从CU下载会快一些,如果需要最新版本请访问这里 6.https://www.sodocs.net/doc/4d16735417.html,/technetwork/java/javase/downloads/jdk7-downloa ds-1880260.html 7.[192.168.233.128 root@nodec:/soft] 8.# sh jdk-6u13-dlj-linux-i586.bin

日志分析:千亿级数量下日志分析系统的技术架构选型

日志分析:千亿级数量下日志分析系统的技术架构选型 随着数据已经逐步成为一个公司宝贵的财富,大数据团队在公司往往会承担更加重要的角色。大数据团队往往要承担数据平台维护、数据产品开发、从数据产品中挖掘业务价值等重要的职责。所以对于很多大数据工程师,如何根据业务需求去选择合适的大数据组件,做合适的大数据架构工作就是日常工作中最常遇到的问题。在这里根据七牛云在日增千亿级的日志分析工作,和大家分享一下大数据技术架构选型的一些经验。 大数据架构师在关注什么 在一个大数据团队中,大数据架构师主要关注的核心问题就是技术架构选型问题。架构选型问题一般会受到哪些因素的影响呢?在我们的实践中,一般大数据领域架构选型最受以下几个因素影响: 数据量级 这一点在大数据领域尤其是一个重要的因素。不过从根本上讲,数据量级本身也是一种业务场景的衡量。数据量级的不同往往也就昭示着业务场景的不同。

业务需求 经验丰富的大数据架构师能够从纷繁的业务需求中提炼出核心技术点,根据抽象的技术点选择合适的技术架构。主要的业务需求可能包括:应用实时性要求、查询的维度和灵活程度、多租户、安全审计需求等等。 维护成本 这一点上大数据架构师一方面要能够清楚的了解各种大数据技术栈的优劣势,在满足业务需求的要求下,能够充分的优化架构,合理的架构能够降低维护的成本,提升开发的效率。 另一方面,大数据架构师要能清楚的了解自己团队成员,能了解其他同学的技术专长和品位,能够保证自己做的技术架构可以得到认可和理解,也能得到最好的维护和发展。 接下来我们会围绕这几个方面去看看,做一个最适合自己团队业务的架构选型会如何受到这些因素的影响? 技术架构选型 业务需求是五花八门的,往往影响我们做技术选型的不是种种需求的细节,而是经过提炼后的一些具体的场景。就好比,业务需求提出我们要做一个日志分析系统,或者要做一个用户行为分析系统,这些具体需求背后我们要关注哪些具体的点?这是一个很有趣的问题,我们在做大数据的过程中,常发现我们对这些需求的疑问很多时候会落在以下几个问题上。 其中数据量级作为一个重要的因素影响着我们对于技术选型的决定,另外在数据量的变化之外各种业务场景的需要也会影响我们对技术组件的选择。 数据量级

日志收集与分析系统

点击文章中飘蓝词可直接进入官网查看 日志收集与分析系统 安全日志就是计算机系统、设备、软件等在某种情况下记录的信息。日志收集与分析 是其中比较重要的环节,事前及时预警发现故障,事后提供详实的数据用于追查定位问题,下面给大家介绍一下日志收集与分析系统中关于日志审计数据收集,日志分析,审计管理 平台等相关内容。并谈一谈日志收集与分析系统哪家好? 南京风城云码软件技术有限公司是获得国家工信部认定的“双软”企业,具有专业的 软件开发与生产资质。多年来专业从事IT运维监控产品及大数据平台下网络安全审计产品研发。开发团队主要由留学归国软件开发人员及管理专家领衔组成,聚集了一批软件专家、技术专家和行业专家,依托海外技术优势,使开发的软件产品在技术创新及应用领域始终 保持在领域上向前发展。 目前公司软件研发部门绝大部分为大学本科及以上学历;团队中拥有系统架构师、软 件工程师、中级软件工程师、专业测试人员;服务项目覆盖用户需求分析、系统设计、代码开发、测试、系统实施、人员培训、运维整个信息化过程,并具有多个项目并行开发的 能力。 日志收集与分析系统通过高性能的日志收集引擎,实时自动化收集日志,解决手工处 理的低效率问题。收集到的所有日志均统一加密存储管理,可根据存储空间情况灵活扩展 存储位置。支持常见操作系统、应用系统、数据库、网络设备、安全设备等类型的日志收集,对于客户网络中特定的日志类型,支持定制扩展收集分析脚本,不再忧心类型复杂问题。可将不同系统和设备日志授权给指定人员进行管理,管理人员各司其职,负责自身所 管辖的系统或设备日志的审计管理,互不干涉、互不影响,使日志审计工作更加清晰、易 操作。 实时收集应用程序的日志信息,进行实时的统计和数据过滤。 实时显示应用程序中业务功能的动态性能视图,提供阀值报警。

大数据日志分析系统

点击文章中飘蓝词可直接进入官网查看 大数据日志分析系统 大数据时代,网络数据增长十分迅速。大数据日志分析系统是用来分析和审计系统及 事件日志的管理系统,能够对主机、服务器、网络设备、数据库以及各种应用服务系统等 产生的日志进行收集和细致分析,大数据日志分析系统帮助IT管理员从海量日志数据中准确查找关键有用的事件数据,准确定位网络故障并提前识别安全威胁。大数据日志分析系 统有着降低系统宕机时间、提升网络性能、保障企业网络安全的作用。 南京风城云码软件公司(简称:风城云码)南京风城云码软件技术有限公司是获得国 家工信部认定的“双软”企业,具有专业的软件开发与生产资质。多年来专业从事IT运维监控产品及大数据平台下网络安全审计产品研发。开发团队主要由留学归国软件开发人员 及管理专家领衔组成,聚集了一批软件专家、技术专家和行业专家,依托海外技术优势, 使开发的软件产品在技术创新及应用领域始终保持在领域上向前发展。 审计数据采集是整个系统的基础,为系统审计提供数据源和状态监测数据。对于用户 而言,采集日志面临的挑战就是:审计数据源分散、日志类型多样、日志量大。为此,系 统综合采用多种技术手段,充分适应用户实际网络环境的运行情况,采集用户网络中分散 在各个位置的各种厂商、各种类型的海量日志。 分析引擎对采集的原始数据按照不同的维度进行数据的分类,同时按照安全策略和行 为规则对数据进行分析。系统为用户在进行安全日志及事件的实时分析和历史分析的时候 提供了一种全新的分析体验——基于策略的安全事件分析过程。用户可以通过丰富的事件分析策略对的安全事件进行多视角、大跨度、细粒度的实时监测、统计分析、查询、调查、追溯、地图定位、可视化分析展示等。

相关文档

- 日志采集与分析系统

- 日志分析:千亿级数量下日志分析系统的技术架构选型

- ELk日志采集分析系统搭建

- 云计算环境下实时日志分析系统的设计与实现

- 用Kibana和logstash快速搭建实时日志查询、收集与分析系统

- 技术参数日志实时监视系统提供实时的日志滚动显示和

- 基于Spark Streaming的实时日志分析与信息管理系统的设计与实现

- 日志分析平台建设方案

- 日志数据分析系统的设计与实现

- 日志分析系统的架构设计

- 日志分析系统

- 日志分析系统

- 日志收集与分析系统

- Linux 系统日志收集分析系统

- 大数据日志分析系统

- 日志分析系统调研分析-ELK-EFK

- 日志分析系统调研分析-ELK-EFK

- 基于Filebeat自动收集Kubernetes日志的分析系统

- 基于ELK的实时日志分析系统