信息熵-特征选择方案

基于互信息的特征选择

1. 模型

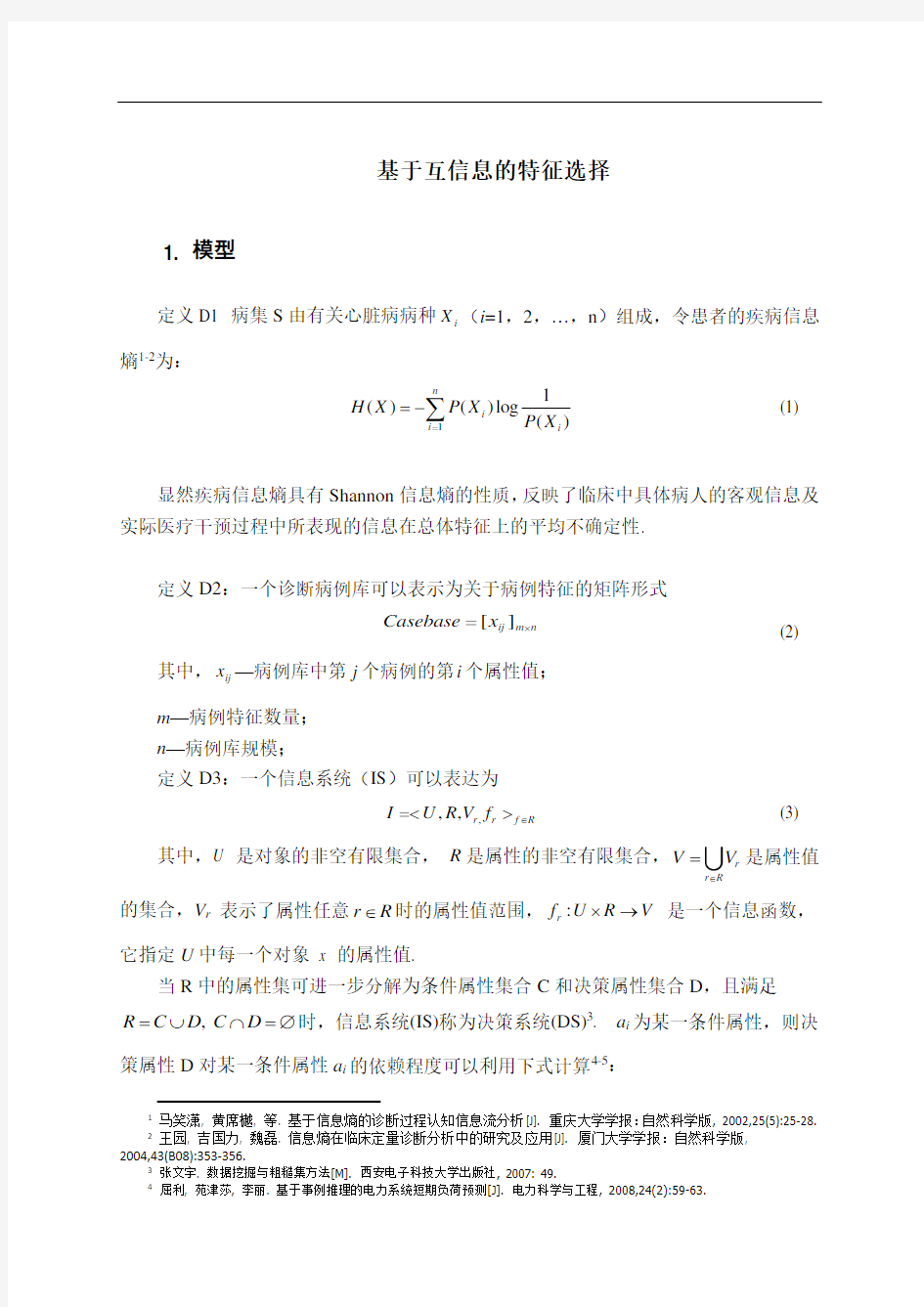

定义D1 病集S 由有关心脏病病种i X (i =1,2,…,n )组成,令患者的疾病信息熵1-2为:

)

(1

log

)()(1

i n

i i X P X P X H ∑=-= (1)

显然疾病信息熵具有Shannon 信息熵的性质,反映了临床中具体病人的客观信息及实际医疗干预过程中所表现的信息在总体特征上的平均不确定性.

定义D2:一个诊断病例库可以表示为关于病例特征的矩阵形式

n

m ij x Casebase ?=][ (2)

其中,ij x —病例库中第j 个病例的第i 个属性值; m —病例特征数量; n —病例库规模;

定义D3:一个信息系统(IS )可以表达为

,,,r r f R I U R V f ∈=<>

(3)

其中,U 是对象的非空有限集合, R 是属性的非空有限集合,r r R

V V ∈=U 是属性值的集合,V r 表示了属性任意r R ∈时的属性值范围,:r f U R V ?→ 是一个信息函数,它指定U 中每一个对象 x 的属性值.

当R 中的属性集可进一步分解为条件属性集合C 和决策属性集合D ,且满足

,R C D C D =? ?=?时,信息系统(IS)称为决策系统(DS)3. a i 为某一条件属性,则决

策属性D 对某一条件属性a i 的依赖程度可以利用下式计算4-5:

1

马笑潇, 黄席樾, 等. 基于信息熵的诊断过程认知信息流分析[J]. 重庆大学学报:自然科学版, 2002,25(5):25-28. 2 王园, 吉国力, 魏磊. 信息熵在临床定量诊断分析中的研究及应用[J]. 厦门大学学报:自然科学版, 2004,43(B08):353-356.

3

张文宇. 数据挖掘与粗糙集方法[M]. 西安电子科技大学出版社, 2007: 49. 4

屈利, 苑津莎, 李丽. 基于事例推理的电力系统短期负荷预测[J]. 电力科学与工程, 2008,24(2):59-63.

(4)

式中,R C 、R D 分别表示条件属性集合C 和策属性集合D 在论域上的等价关系.(

)D

C

R H R 表示R D 相对于R C 的条件熵.(,)i I a D 的值越大,

则条件属性a i 对决策属性D 的重要性越大.如果(,)0i I a D ,则说明a i 对于D 不起作用,可以删除.在基于属性信息增益的约简方法中,计算案例库属性集的每个属性的信息增益,并约定属性的信息增益大于某个阈值时就将该属性归入最优属性子集,否则弃用属性.

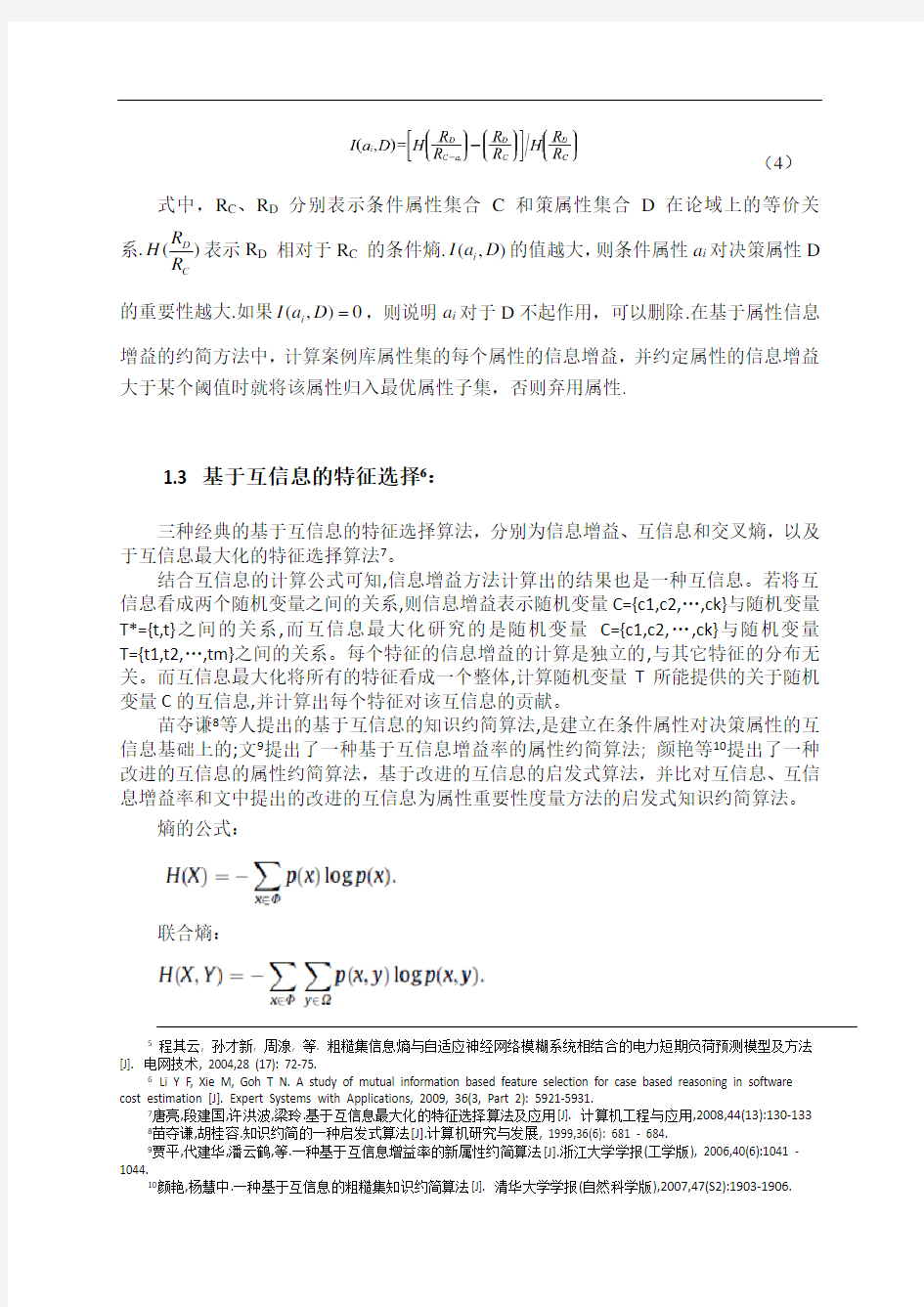

1.3 基于互信息的特征选择6:

三种经典的基于互信息的特征选择算法,分别为信息增益、互信息和交叉熵,以及于互信息最大化的特征选择算法7。

结合互信息的计算公式可知,信息增益方法计算出的结果也是一种互信息。若将互信息看成两个随机变量之间的关系,则信息增益表示随机变量C={c1,c2,…,ck}与随机变量T*={t,t}之间的关系,而互信息最大化研究的是随机变量C={c1,c2,…,ck}与随机变量T={t1,t2,…,tm}之间的关系。每个特征的信息增益的计算是独立的,与其它特征的分布无关。而互信息最大化将所有的特征看成一个整体,计算随机变量T 所能提供的关于随机变量C 的互信息,并计算出每个特征对该互信息的贡献。

苗夺谦8等人提出的基于互信息的知识约简算法,是建立在条件属性对决策属性的互信息基础上的;文9提出了一种基于互信息增益率的属性约简算法; 颜艳等10提出了一种改进的互信息的属性约简算法,基于改进的互信息的启发式算法,并比对互信息、互信息增益率和文中提出的改进的互信息为属性重要性度量方法的启发式知识约简算法。

熵的公式:

联合熵:

5

程其云, 孙才新, 周湶, 等. 粗糙集信息熵与自适应神经网络模糊系统相结合的电力短期负荷预测模型及方法[J]. 电网技术, 2004,28 (17): 72-75.

6

Li Y F, Xie M, Goh T N. A study of mutual information based feature selection for case based reasoning in software cost estimation [J]. Expert Systems with Applications, 2009, 36(3, Part 2): 5921-5931.

7

唐亮,段建国,许洪波,梁玲.基于互信息最大化的特征选择算法及应用[J]. 计算机工程与应用,2008,44(13):130-133 8

苗夺谦,胡桂容.知识约简的一种启发式算法[J].计算机研究与发展, 1999,36(6): 681 - 684. 9

贾平,代建华,潘云鹤,等.一种基于互信息增益率的新属性约简算法[J].浙江大学学报(工学版), 2006,40(6):1041 - 1044.

10

颜艳,杨慧中.一种基于互信息的粗糙集知识约简算法[J]. 清华大学学报(自然科学版),2007,47(S2):1903-1906.

条件熵:

联合熵和条件熵的关系:

1.3.1 互信息(MI)

互信息是衡量不考虑特征分布的两个特征之间的一般依赖性.

互信息越大,这两个随机变量之间的联系月越紧密.当互信息趋近于零时,这两者之间相互独立.

特征和类之间的互信息:P(w i)是特征w i的概率,表示w i没有发生.P(c i)是类c j的概率,P(c j,w i)是类c j与特征w i的联合概率.

是特征之间的互信息.

互信息和信息熵之间的联系:

互信息和信息熵的关系见图1.

图1 互信息和信息熵的关系图

连续型时,(p(x),p(y) 和p(x,y)都是连续的)

计算连续的基因表达变量的熵或互信息,首先要将其离散化,一般采用直方图方法11,并根据表达向量的值域范围选择合适的bin值,联合熵计算可采用二维直方图法.

连续变量的互信息计算:

第一种,histogram 方法(Moddemeijer,1989),将数据划分成等尺度(直方图)的间隔.该方法在低维度条件下,可以获得满意解;随着数据维度的增多,histogram估算值的精确度呈递减趋势.

第二种,using the continuous kernel based density estimator to approximate I(x;y),as proposed by Kwak and Choi (2002b). 利用基于密度评价者的连续核心近似互信息I(x;y),该方法由Kwak and Choi (2002b)提出.

给出一个变量x的N个样本,近似密度函数为:(基于互信息特征选择标准:最大的依赖,最大关联,最小冗余)12

其中,是Parzen窗口函数(Parzen window function (Parzen,1962));是第

i个样本;h是窗口宽度.Parzen已证明了,选择适当的和h,当N趋近于无穷时,近似函数趋近于真实的p(x).

通常,可用高斯窗口(Gaussian window):

其中,,d是样本x的维度,是z的协方差,

以上计算可以利用peng制作的matlab的互信息计算工具包.

11SteuerR, Kurths J, DaubC O, eta.l Themutual information: detecting and evaluating dependencies between variables [J]. Bioinformatics, 2002,18( sup2):231-240.

12Feature Selection Based on Mutual Information Criteria of Max-Dependency, Max-Relevance, and Min-Redundancy

https://www.sodocs.net/doc/e05024027.html,/matlabcentral/fileexchange/14888-mutual-information-com putation

1.3.2 基于互信息的特征选择的算法模型

建立一个特征选择的模型,可以描述为:设原始特征空间为FR,包含有n个特征,c为分类类别,现要从FR中选择k个最有效的特征,形成一个新的特征空间R ,要求k< n.

利用互信息的特征选择的算法模型,包括二阶段

1)内部阶段为:经典的MIFS (Battiti,1994)用来选择特征的m个序数,——找到更高级的该种算法1314。经典的MIFS算法的步骤如下1516:

改进的算法:

MIFS和MIFS-u算法都是近似算法,随着输入特征的增加,特征选择性能逐渐下降.希望考虑待选输入特征和已选输入特征之间互信息在特征选择过程中的权重是一致的,我们可以用待选输入特征和各个已选输入特征之间互信息J(F F ;C)的均值作为待选输入特征和已选输入特征互信息J(F S;C) 的近似,这样,权重系数可以取常数,在整个特征选择过程中,考虑与已选输入特征互信息权重的系数是一致的17.

2)外部阶段为:最小化训练数据集的基于案例推理的错误,以确定序数m 外层阶段解决内层阶段没能解决的问题:确定特征m的最佳序数.假定数据集中有n个特征,MIFS首先用来选择1到n的特征,并形成一连串的特征集:

1.3.3 比较这n个连续的特征集

,找出子集,使得CBR的训练误差(用MMRE衡量)

最小.因此,m是特征的最佳序数,是最佳数据集.

13Using Mutual Information for Selecting Features in Supervised Neural Net Learning

14Novovi?ová J, Malík A, Pudil P. Feature Selection Using Improved Mutual Information for Text Classification [M]. 2004: 1010-1017.

15杨打生.特征选择的信息论算法研究[D].东南大学硕士学位论文, 2005.

16Improved Mutual Information Feature Selector for Neural Networks in Supervised Learning

17杨打生,李泰. 信息论特征选择算法的改进[J].商丘职业技术学院学报,2005(4):2.

MMRE ,mean magnitude of relative error ,平均相对误差幅度18

其中,n 代表了对象的序数,

指第i 个对象的真实影响,

指第i 个对象的期

望影响,小的MMRE 指期望误差处在低水平;

基于案例推理已选择的特征子集特征选择基于案例推理WEKA 软件

特征集

预测

最小化MMRE

训练的数据集最大化I (C;f i |s)

最小的MMRE?

最优的特征集

第一阶段

“filters ”

第二阶段

“wrappers ”

图1 基于互信息的特征选取(MICBR 方法)的框架图

1.3.7最大依赖性、最大相关性和最小冗余性的准则19 彭汉川,

赵军阳等20基于模糊粗糙集的信息熵模型提出最大互信息最大相关熵标准,并根据该标准设计了一种新的特征选择方法,能同时处理离散数据、连续数据和模糊数据等混合信息。属性子集中单个属性与决策类之间互信息均值的最大值. 相关熵来度量条件属性集的独立性. 基于最大互信息最大相关熵标准MmMi ce,提出一种新的特征选择算法FS-mMC 。该算法采用启发式前向搜索,初始为空集,每次选择具有最大互信息的属性添加到特征子集中,如果该属性使子集的相关熵增大,即冗余性减少,则保留该属性,否则去除该属性.

1.3.8基于互信息梯度优化计算的信息判别特征提取

将互信息梯度优化引入特征提取矩阵求解,提出一种信息判别分析的特征提取方法,建立了类条件分布参数模型下互信息最大化的信息判别模型,证明了互信息判别的线性变换不变性和贝叶斯一致优化,构造了一个互信息梯度优化计算的特征提取算法

(Huang & Chiu, 2006).

19

Peng H. Feature Selection Based on Mutual Information: Criteria of Max-Dependency, Max-Relevance [J]. IEEE TRANSACTIONS ON PATTERN ANALYSIS AND MACHINE INTELLIGENCE, 2005, 27(8): 1126-1138.

20

赵军阳, 张志利. 基于最大互信息最大相关熵的特征选择方法[J]. 计算机应用研究,2009,26(1):233-235

21。

论述了高斯分布假设下的该互信息判据的类可分特性,并证明了现有典型算法都是本算法的特例;然后,在给出该互信息判据严格的数学意义基础上,提出了基于矩阵特征向量分解计算最优化特征规模算法22。

作为高维数据分离度度量的有效工具,互信息建立了特征提取向量和数据分类信息的内在关系,产生了特征提取的信息判据分析方法23。

分析特征向量和分类判别关系的基础上,在判据目标函数中引入互信息的罚函数机制24。

通过启发式迭代优化进行混合模型的极大似然拟合,一定程度上克服了罚函数的过度拟合25。

1.4 Adaboost-互信息的CBR

CBR智能体的集成学习,典型的继承算法包括boosting、bagging和stacking26:

A new problem is solved as the weighted vote of all the Agents' solutions. 每个CBR智能体都有其案例库,用来整合智能体的经验.

Bagging包括使用权重投票方案,但是在这种案例中中经验并没有针对每个智能体,以致互补性(complementarity)学习者的the construction is left to chance and the variability 学习方法.

Stacking技术中每个智能体使用不同的推理方法.

1.4.1 Adaboost算法27

Boosting CBR的核心问题是每个智能体的权重设置.Adaboost是该领域的最著名的学习算法,(AdaBoost算法是1995 年提出的一种快速人脸检测算法,Adaboost是一种迭代算法,其核心思想是针对同一个训练集训练不同的分类器(弱分类器),然后把这些弱分类器集合起来,构成一个更强的最终分类器(强分类器).其算法本身是通过改变数据分布来实现的,它根据每次训练集之中每个样本的分类是否正确,以及上次的总体分类的准确率,来确定每个样本的权值.将修改过权值的新数据集送给下层分类器进行训练,最后将每次训练得到的分类器最后融合起来,作为最后的决策分类器.使用adaboost分类器可以排除一些不必要的训练数据特徵,并将关键放在关键的训练数据上面.)

21谢文彪,樊绍胜,费洪晓,樊晓平. 基于互信息梯度优化计算的信息判别特征提取[J]. 电子与信息学

报,2009,31(12):2975-2979.

22谢文彪,樊绍胜,樊晓平.一种可最优化计算特征规模的互信息特征提取[J]. 控制与决策,2009,24(12):1810-1815 23Hild II K E, Erdogmus D, and Torkkola K. Feature extraction using information-theoretic learning [J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2006, 28(9): 1385-1392.

24Padmanabhan M and Dharanipragada S. Maximizing information content in feature extraction [J]. IEEE Transactions on Speech Audio Processing, 2005, 13(4): 512-519.

25Leiva-Murillo J M and Artés-Rodríguez A. Maximization of mutual information for supervised linear feature extraction [J]. IEEE Transactions on Neural Networks, 2007, 18(5): 1433-1440.

26López B, Pous C, Pla A, et al. Boosting CBR Agents with Genetic Algorithms [M]. 2009: 195-209.

27Boosting原理及在分类上的应用

将弱学习机按其相应的权重加权组合形成强学习机,准确率越高的弱学习机权重越高

Boosting训练器内部结构:训练集特征向量输入(1)--> 直方图计算(2)--> 选择准确率最高的一维作为弱学习机(3)--> 根据公式计算相应的权重,调整样本分布(4)--> 转向(3)直到到达规定的循环次数--> 输出加权组合后的分类器。

Boosting的思想源泉:将一系列粗略的规则加权组合起来得到高度精确的规则。

Boosting的数学实质:对目标函数(损失函数)的最优化问题;损失函数形式不同,优化方法不同;

Boosting的理论联系:熵映射;对数回归;

改进方向:用遗传算法学习boosting权重,提出遗传算法优于AdaBoost算法(存在贪婪行为)

为了Boosting目的,将在CBR智能体合作解决问题的多智能体的环境中,应用遗传算法,

1.4.2 基于熵的AdaBoost分类器

Adaboost方法能够“聚焦于”那些较困难(更富信息)的样本上。令每个样本的权重相等,对于第k次迭代操作,我们就根据这些权重来选择样本点,进而训练分类器C k,根据这个分类器,来提高被它错分的那些样本点的权重,并减低可以被正确分类的样本权.然后,权重更新过的样本集被用来训练下一个分类器C k+128.

基于Boosting 的条件互信息Conditional Mutual Information based Boosting(CMIB)29,

28刘天键.基于熵的特征选择的AdaBoost改进算法[J]. 闽江学院学报,2009,30(2):60-64. 烂文献

29Caifeng Shan S G, Peter W. Mcowan Conditional Mutual Infomation Based Boosting for Facial Expression Recognition [J]. 2005

1.6 最大熵特征选取30

特征选择方法MEFS(maximum entropy feature selection).MEFS在基于最大熵原理的基础上,运用互信息和Z-测试技术,采用两步方法进行空间特征选择。对MEFS方法和RELIEF方法以及基于MEFS的分类方法与决策树算法ID3分别进行了实验比较。

1.7 互信息增益率31

为了获得决策系统中更好的相对属性约简%提出了一种基于互信息增益率的属性约简算法<该算法考虑了所选择条件属性与决策属性的互信息%还考虑了所选择属性的值的分布情况%从信息论角度定义了基于互信息增益率的属性重要性度量方法%并以此度量为启发式信息%算法从空集开始逐步将最重要的条件属性加入到选择属性集%直到所选择的条件属性集与决策属性集的互信息等于整个条件属性集与决策属性集的互信息时%算法停止< 结果表明%算法能更有效地对决策系统进行约简%同时约简后的对象数目较少.

中对以互信息增益和本文的互信息增益率为度量的方法进行了数据集对照<

30宋国杰, 唐世渭, 杨冬青,王腾蛟. 基于最大熵原理的空间特征选择方法[J].软件学报.2003(14):9

31贾平,代建华,潘云鹤,朱淼良. 一种基于互信息增益率的新属性约简算法[J].浙江大学学报(工学版).2006(40):6

2. 仿真数据

用UCI 机器学习数据库中的心脏病诊断数据集cleveland 作为例子, 该数据集由医学博士Robert Detrano 收集, 包括303 个病例, 13 个条件属性(age, sex, cp, trestbps, chol, fbs,restecy, thalach, exang,oldpeak, slope, ca, thal), 1 个决策属性(num)32。

将数据集分为两部分, 其中223 个对象作为训练数据, 其余80个作为测试数据。

2.1 任一样本的特征的数据结构

ID

特征

(Features)

Full name

属性说明Description

1 Age 年龄age: age in years

2 Sex 性别sex: sex (1 = male;0 = female)

3 Cp 胸痛类型

cp: chest pain type

-- Value 1: typical angina -- Value 2: atypical angina -- Value 3: non-anginal pain -- Value 4: asymptomatic

4

Trest

bps

静脉压

trestbps: resting blood pressure (in mm

Hg on admission to the

hospital)

5 Chol

每毫升血液中的

血清重量mg

chol: serum cholestoral in mg/dl

6 Fbs

每毫升的血糖浓

度是否超过120mg

fbs: (fasting blood sugar > 120 mg/dl)

(1 = true;0 = false)

7

Reste

cg

安静时的心电图

结果

restecg: resting electrocardiographic

results

-- Value 0: normal

-- Value 1: having ST-T wave abnormality (T

wave inversions and/or ST

elevation or depression of >

0.05 mV)

-- Value 2: showing probable or definite left

ventricular hypertrophy

by Estes' criteria

8

Thal

ach

最高心率thalach: maximum heart rate achieved

9 Exan

g

是否运动导致心

绞痛

exang: exercise induced angina (1 = yes;

0 = no)

32UCI 机器学习数据库网址.UCI Repository of machine learning atabases [DB/OL].https://www.sodocs.net/doc/e05024027.html,/~ mlearn/MLRepository.html.

10

Oldp

eak

运动所导致的ST

下降

oldpeak = ST depression induced by

exercise relative to rest

11

Slop

e

峰值ST倾斜角度

slope: the slope of the peak exercise ST

segment

-- Value 1: upsloping

-- Value 2: flat

-- Value 3: downsloping

12 Ca 主血管数量

ca: number of major vessels (0-3) colored by flourosopy

13 Thal 心跳情况

thal: 3 = normal;6 = fixed defect;7 = reversable defect

14 num

num: diagnosis of heart disease (angiographic disease status)

-- Value 0: < 50% diameter narrowing

-- Value 1: > 50% diameter narrowing

(in any major vessel: attributes 59 through 68 are vessels)

2.2样本数据

样本数据(大于15)

特征样本编号

A

ge

Se

x

Di

sese(是

否患有

心脏

病)

1

2

3

4

2.2验证方法

利用朴素Bayes(NB)和TFIDF算法进行分类

结合新西兰Waikato大学开发的WEKA软件,将选择结果与CFS、Re-lief和InfoGain 算法进行了比较,并分别在C4. 5、Bagging和NaiveBayes条件下对每种算法选择的各个数据集的特征子集进行分类精度评价20。

3. 预期结果

特征筛选与数据处理

影响心脏病种类的动脉氧含量的信息熵计算

动脉氧含量 A1类心脏病

A2类心脏病

例数

1N

概率

1P

H

1(X ) 例数2N

概率

2P

H2(X )

<50 50—65 65—80 80>

RELIEF 、SSGA 、MIFS 和FMIFS 的特征选取的比较33: (1) Feature selection with RELIEF. (2) Feature selection with SSGA. (3) Feature selection with MIFS. (4) Feature selection with FMIFS.

4. 结果分析

特征选取是基于案例推理的重要环节.当前基于案例推理的特征选取是是

33

S ánchez L, Rosario Su árez M, Villar J R, et al. Mutual information-based feature selection and partition design in fuzzy rule-based classifiers from vague data [J]. International Journal of Approximate Reasoning, 2008, 49(3): 607-622.

“…wrappers? (Kohavi & John,1997).”,wrappers可以产生高拟合精度,但是计算复杂和所选特征对于其他条件具有较低的普适性.

另一特征选取的方式是“…filters?(Almuallim & Dietterich,1994;Kohavi & John,1997)”,相对于wrappers来讲计算更为简单,所选的特征对其他条件具有更高的普适性.

本方案提出基于互信息的混合包装(wrappers)和过滤(…filters?)的特征选择方法——MICBR.为了验证该方法,使用了真实的数据集:

第一步,过滤(…filters?)特征选择,通过调整CBR的参数设置;

第二步,所提出MICBR的与其他基于案例推理的特征选取的“包装”(wrappers)方法((exhaustive search,hill climbing,and forward sequential selection))相比较,预测结果表明MICBR方法比其他方法所取得的训练数据集的预测结果(普适性)更好,但其调整训练数据集反而不及它们.

5. 结论

巴洛克时期的音乐特点

巴洛克时期的音乐特点 巴洛克时期是西方音乐史上的一个重要时期,以意大利歌剧的产生为标志。意大利歌剧中流传至今的优秀曲目成为这一时期音乐创作中的古典艺术精品。这些歌曲可称得上是世界声乐作品中一枝独放的奇葩,虽然距今已有300多年的历史,但仍以主题内容具有鲜明的人文特征;旋律声部优美、流畅;钢琴伴奏的织体简洁、纯朴;以及歌唱风格柔美、抒情等特征为世界各地的声乐爱好者和歌唱家们所珍爱。这些歌曲在当今的声乐教学中具有十分重要的价值。巴洛克音乐节奏强烈、跳跃,采用多旋律、复音音乐的复调法,比较强调曲子的起伏,很看重力度、速度的变化。在声乐方面,巴洛克音乐带有很浓的宗教色彩,当时的宗教音乐在西方音乐的发展占很大的分量。那个时期的器乐曲发展也很迅速,尤其是弦乐方面的发展,弦乐的音色更能体现出巴洛克的特色。巴洛克时期的三个代表人物有巴赫、维瓦尔蒂和亨德尔。巴赫是德国最伟大的古典作曲家之一,又是管风琴演奏家。他的主要作品有《约翰·受难曲》、《十二平均律钢琴曲集》等。巴赫的作品对近代西洋音乐具有深远的影响,所以在西欧他有"音乐之父"和"不可超越的大师"的荣称。亨德尔,著名的英籍德国作曲家,主要作品有《弥赛亚》、《哈利路亚》等。他的作品熔德国严谨的对位法、意大利的独唱艺术和英国的合唱传统于一炉,成为世界音乐史上的瑰宝。他同巴赫、维瓦尔第一起,为辉煌的巴洛克时代划上了一个圆满的句号。维瓦尔第,巴洛克时期意大利著名的作曲家、小提琴家。他最著名的作品是小提琴协奏曲《四季》。他的音乐天才启迪了后来的

巴洛克大音乐家,尤其是他丰富的作品和新颖的、科学的歌剧创作方法,刺激了现代意大利作曲家的好奇心。下面,我们具体的说一下巴洛克时期音乐的特点。 一、旋律特点。 旋律作为构成歌曲的首要要素,是人们感受并理解歌曲音乐的最直接载体,蕴藏着深刻而丰富的内涵。这一时期的歌曲具有篇幅短小但艺术表现独立而完整的特点,为了更好地表达作曲家对生命浓缩的感受,展现内心世界丰富的情感,作曲家在旋律上倾注了更多的心血。巴洛克时期的意大利歌曲一般具有音域不宽,音程以级进为主,旋律优美、流畅自然,感情真挚细腻,即使偶尔出现一些音程的大跳,也是为了情感表达的需要。 二、伴奏织体的特点。 巴洛克时期,在音乐上的一个突出的特点就是“数字低音”,它的运用构成了一种典型的巴洛克音乐织体——基本上是由旋律加和声伴奏构成。这种织体的优点在于:它强调的是两端的声部,即低声部和高声部这两个基本的旋律线条。我们现在接触到的乐谱是根据当时的“数字低音”而编配的钢琴伴奏谱,所以伴奏织体具有上述的特点。 三、演唱风格的特点。 巴洛克时期意大利歌曲的演唱和作品一样简单,不矫揉造作,宁静又连贯。演唱者必须严格按照谱面的要求,不能随意加快、放慢或者延长,尤其是有装饰音的乐句,必须认真对待装饰音中的每个音符,使

信息熵理论

信息熵理论 在通信系统中,信息从发送到接收的传输过程是一个有干扰的信息复制过程。 对每一个具体的应用而言,传输的信息是确定的,有明确的应用目的。 对一个通信系统而言主,不同的用户要传送的具体的信息内容是不同的,则如何从这些繁杂的具体信息中提炼出它们的共同特征,并可进行量化估计是shannon 信息论研究的基础。 所谓量化估计就是用提炼的共同特征估计与某些具体内容所对应的需要传输的信息量大小。 信息量定义的另一个重要特征是它能保证信息量值的大小与具体的信息内容无关。 1.定义信息熵: 设X 是一个离散的随机变量,其定义空间为一个字符集E 。 ()()E x x X P x p ∈==,,表示相应的概率分布函数,则 ()()()()x p x p X H x log ∑-=称为离散随机变量的熵。 有时记()()()()(){}X p E x p x p p H p x log log -=-=∑ {}p E 表示以概率分布()x p 对某随机变量或随机函数求概率平均。 2.定义联合熵: 设X ﹑Y 是丙个离散的随机变量,(X,Y )的联合概率分布函数为()()y Y x X P y x p ===,,,则 ()()()y x p y x P Y X H x y ,log ,,∑∑-= 称为离散随机变量X 与Y 的联合熵。 有时记为: ()()()(){}Y X p E y x p y x p Y X H p x y ,log ,log ,,-=-=∑∑ 3.定义条件熵: 如果()(),,~,y x p Y X 则条件熵()X Y H /定义为 ()()() ∑=-=x x X Y H x p X Y H // ()()()∑∑- =x y x y p x y p x p /log / ()()∑∑-=x y x y p y x p /log , (){}X Y p E /log -= 条件熵等于零的条件为()1==Y X p 事实上,对任意的y x ,都有()()0/log /=x y p x y p ,从而得()()1/0/==x y p x y p 或,又因为X 与Y 是取值空间完全相同的随机变量,所以有()1/=X Y p

基于信息熵的快速求核算法

收稿日期!"##$%&"%&’基金项目!国家自然科学基金重点资助项目()*+’$##&,作者简介!徐章艳-男-&*."年生-博士研究生-讲师-研究方向为模糊集-粗糙集-数据挖掘/杨炳儒-男-&*0’年生-教授-博士生导师-研究方向为人工智能-数据挖掘/郭燕萍-女-&*+"年生-硕士研究生-研究方向为粗糙集-数据挖掘/宋威-男-&*+#年生-博士研究生-研究方向为粗糙集-数据挖掘1 基于信息熵的快速求核算法 徐章艳&-"-杨炳儒"-郭燕萍&-宋威" &(广西师范大学 计算机系-广西桂林$0&##0,"( 北京科技大学 信息工程学院-北京&###+’, 2%3456!789:67.";84<==1>=31>? 摘 要!基于信息熵的求核算法的最好时间复杂度为@(A B A " A C A 6=D A C A ,1为降低算法的时间复杂度-本文首先给出了基于信息熵的简化差别矩阵及相应核的定义-并证明了该核与基于信息熵的属性约简的核是等价的1然后以基数排序的思想设计了一个新的求C E B 的算法-其时间复杂度为@(A B A A C A ,1在此基础上-设计了一个新求核算法-其时间复杂度被降为347F @(A B A A C E B A " ,-@(A B A A C A ,G 1最后用一个实例说明了新求核算法的高效性1关键词!H =I D

巴洛克时期的音乐历史文化背景及音乐特点简析

学院:工商管理学院 班级:08会计学三班 学号:200842114351 姓名:朱华越 2010---2011学年第二学期《西方音乐简史》考试试题 巴洛克时期的音乐历史文化背景及音乐特点简析 摘要:“巴洛克”是一个时期,而不是一种“风格”,这个时期出产的音乐作品就称为巴洛克音乐,1600到1750年这150年间就叫做巴洛克时期,14至16世纪就是“文艺复兴时期”,这两个时期虽然在时间方面的区别不是很大,但在艺术方面的东西有很大的区别,所以把它们分为两个时期!“巴洛克”也译为“巴罗克”,这一词产生于文艺复兴时期,并源语葡萄牙语,原意指体大且形状不规则的珍珠,在意大利语中有冲动、任性、夸张、幻想之意。它的节奏强烈、跳跃,采用多旋律、复音音乐的复调法,比较强调曲子的起伏,所以很看重力度、速度的变化。巴洛克音乐是后期发展的一个基础。在声乐方面,巴洛克音乐带有很浓的宗教色彩,当时的宗教音乐在西方音乐的发展占很大的分量。那个时期的器乐曲发展也很迅速,尤其是弦乐方面的发展。那个时期的代表人物有:巴赫、维瓦尔蒂和亨德尔。小提琴的出现、拨弦古钢琴的成形都为巴洛克音乐提供了更丰富的表现力;其他乐器的发展也使得某些特定风格的巴洛克音乐其配器得以朝着多元化、大规模的方向发展。 关键字:巴洛克、文艺复兴、音乐特点、代表人物 一、巴洛克音乐的历史文化背景 巴洛克是西方艺术史上的一种艺术风格,最初是指那些产生于文艺复兴时期的,并且在1600~1750年间繁荣起来的音乐和其他一些视觉艺术。巴洛克风格的产生经历了一个相当长的时间过程。随着文艺复兴的衰落和反宗教改革潮流的蔓延,在意大利以及天主教甚至新教世界中,艺术和音乐比纳入具有新的教会精神的文化氛围中。在古典主义形式的完美、平衡、和谐被打乱之后,综合、调和以及刻意的修饰成为新一代风格教会为自己的世界从建筑形式上提供了富丽堂皇、瑰丽精致的形式,同时也给音乐打下了自己的文化烙印。随着文化功能的转变,艺术和音乐实际上远离文艺复兴的人文精神,而在教会精神中获得原动力。 虽然“巴洛克”这样一个术语是无法总括一段历史中多样的音乐风格,但是,由于“巴洛克”在使用中确实被用来泛指整整一个历史时期的艺术和文学,并且这样一个时期的音乐,与当时的建筑、绘画、文学,甚至与科学、哲学都有某种相似的文化品性,因此,出于这样一种看法,即音乐和人类其他创造性活动之间存有一种联系,而一个时代的音乐又往往会以为它特有的方式去反映其他时代艺术中表达相似的观念和倾向,人们才会在艺术史上,用巴洛克、浪漫派之类的称谓来表示一个历史时期的艺术。

古典主义时期音乐的风格特征

古典主义时期音乐的风格特征 本学期我选修了欧洲音乐史,因为我一直对古典音乐有着浓厚的热爱。我综合一个学期以来所学的关于欧洲音乐史的知识和自己搜集的一些资料,对这个学期的学习进行一个总结。在这里我从欧洲音乐史中选择了古典主义时期具体阐述一下这一时期音乐的风格特征。 古典主义时期主要是指欧洲音乐史1750年至1827年左右这70多年的历史阶段。 古典主义时期之前欧洲爆发了在思想文化领域内掀起的启蒙运动,它对当时的教会权威和封建制度采取怀疑或反对的态度,把“理性”推崇为思想和行动的基础,相信实用性实验知识的效用和相信普遍自然感觉的价值,提出“自由、平等、博爱”的口号。后来又经历了狂飙突进运动、德国资产阶级文学运动的洗礼,欧洲音乐的主题从延续近千年对神的虔诚转移到对理性的崇尚上来,使得古典时期的作品开始具有丰富的哲理内涵。所以古典主义时期音乐的社会文化特质表现为强调人性解放,崇尚英雄主义,追求人权平等。 这一时期音乐的整体风格特征主要表现在一下七个方面:1、音乐从教堂步入宫廷,并逐步走向社会,走向民众。2、音乐创作不再以巴罗克时期的复调手法为主,采用的是主调音乐形式,加强了旋律与和声的对应,建立起“主—下属—属—主”的功能和声进行。3、确立曲式分段式结构原则,旋律不再采用巴罗克时期延绵不断、扩充的音型,而是以短小对称的2、4小节(也有3、5、6小节)为基本单位形成方整型乐句结构。音乐呈现出优美、简单、均衡的特征。4、主题动机式发展,以主题间的对比取代巴罗克时期单一主题的模进发展。5、“通奏低音”被明确的乐器记谱取代,使作曲家对乐器音色的体验更明晰。6、追求客观的美,描绘自然界中的人挣脱对教堂中的神、宫廷中的君主的依恋,拓宽了音乐的表现范围和表现力。7、音乐的重心移到新型的器乐体裁——交响曲、协奏曲、奏鸣曲、四重奏上。以上这些变化对欧洲音乐的发展都具有深远的影响。 古典主义时期音乐的类型主要世俗化,专业化,定向化。 在古典主义这一音乐时期不仅确立了主调音乐形式,还出现了三个重要的乐派曼海姆乐派、柏林乐派和维也纳古典乐派和许多优秀的音乐家。 曼海姆乐派是18世纪在德国南部曼海姆形成的一个音乐流派。曼海姆乐派在音乐史上做出了重大的贡献,主要有(1)在结构上,奠定了古典交响乐的基本结构布局,在意大利歌剧序曲快—慢—快结构的基础上加入了快速的第四乐章,形成了快板—行板—小步舞曲—快板终曲的交响乐套曲形式。(2)在演奏风格上,仔细安排乐队演奏力度上“渐强”、“渐弱”的情感幅度变化,在当时具有前瞻性。(3)在创作上,以主调音乐风格为主,重视以小提琴为中心的旋律声部,

信息熵的应用

分类号: O236单位代码:106 密级:一般学号: 本科毕业论文(设计) 题目:信息熵在球员选拔中的应用专业: 姓名: 指导教师: 职称: 答辩日期:

信息熵在球员选拔中的应用 摘要:.本课题通过研究信息熵的定义和性质,运用p c -分析法,通过统计一场球赛中各个球员的各项技术指标并该场球赛中各个队员的信息熵,自信息等值,得到球员选拔过程中对球员的评判方法.并以此法选出优秀的球员,根据信息熵的性质指出每个球员的不足之处,为今后的训练指明了方向. 关键字:信息熵;P-C分析法;球员选拔 Information entropy application in selecting players Abstract: Shannon information entropy presented expressions in 1948, which pioneered information theory. Now more and more international competitions, how to select best players on behalf of the state competition become critical .This issue through the definition and nature of information entropy, use of p c -law to come the assessment of each player, and select a good player, and point out the inadequacties of each player based on information entropy, that should be strengthened in future training exercises. Key Words: Information Entropy; P-C Analysis; Selecting Players

信息熵

信息熵在遥感影像中的应用 所谓信息熵,是一个数学上颇为抽象的概念,我们不妨把信息熵理解成某种特定信息的出现概率。信源各个离散消息的自信息量得数学期望(即概率加权的统计平均值)为信源的平均信息量,一般称为信息源,也叫信源熵或香农熵,有时称为无条件熵或熵函数,简称熵。 一般而言,当一种信息出现概率更高的时候,表明它被传播得更广泛,或者说,被引用的程度更高。我们可以认为,从信息传播的角度来看,信息熵可以表示信息的价值。这样子我们就有一个衡量信息价值高低的标准,可以做出关于知识流通问题的更多推论。 利用信息论中的熵模型,计算信息量是一种经典的方法,广泛应用于土地管理,城市扩张以及其他领域。熵值可以定量的反应信息的分散程度,将其应用于遥感图像的解译中可以定量的描述影像包含的信息量,从而为基于影像的研究提供科学的依据。利用信息熵方法对遥感影像的光谱特征进行离散化,根据信息熵的准则函数,寻找断点,对属性进行区间分割,以提高数据处理效率。 遥感影像熵值计算大致流程为:遥感影像数据经过图像预处理之后,进行一系列图像配准、校正,图像增强,去除噪声、条带后,进行图像的分类,然后根据研究区域进行数据的提取,结合一些辅助数据对图像进行监督分类后生成新的图像,将新的图像与研究区边界图和方格图生成的熵单元图进行进一步的融合便可得到熵分值图。 1.获得研究区遥感影像 以研究区南京市的2009 年6 月的中巴资源二号卫星分辨率20 米得影像为例,影像是有三幅拼接完成。通过ArGIS9.2 中的选择工具从全国的行政区域图中提取边界矢量图,再通过掩膜工具获得研究区的影像。分辨率的为90 米得DEM 图有两副影像拼接而得,操作的步骤与获取影像一致,为开展目视解译工作提供参考。然后依照相关学者的相关研究以及城市建设中的一些法律法规,参照分类标准,开展影像解译工作,对于中巴资源二号影像开展监督分类,以及开展目视解译工作。 2.二值图像的建立 将两种解译所得的图像按照一定的标准转化为城镇用地和非城镇用地两种,进一步计算二值图像的熵值。 3.熵值单元图 根据一些学者对城市边缘带的研究,其划分的熵值单元为 1 km ×1 km,针对样 区的具体情况,采用500 m ×500 m 的熵值单元。在ERDAS 软件和

信息熵.doc

一些信息熵的含义 (1) 信息熵的定义:假设X是一个离散随即变量,即它的取值范围R={x1,x2...}是有限可数的。设p i=P{X=x i},X的熵定义为: (a) 若(a)式中,对数的底为2,则熵表示为H2(x),此时以2为基底的熵单位是bits,即位。若某一项p i=0,则定义该项的p i logp i-1为0。 (2) 设R={0,1},并定义P{X=0}=p,P{X=1}=1-p。则此时的H(X)=-plogp-(1-p)log(1-p)。该H(x)非常重要,称为熵函数。熵函数的的曲线如下图表示: 再者,定义对于任意的x∈R,I(x)=-logP{X =x}。则H(X)就是I(x)的平均值。此时的I(x)可视为x所提供的信息量。I(x)的曲线如下: (3) H(X)的最大值。若X在定义域R={x1,x2,...x r},则0<=H(X)<=logr。 (4) 条件熵:定义

推导:H(X|Y=y)= ∑p(x|y)log{1/p(x,y)} H(X|Y)=∑p(y)H(X|Y=y)= ∑p(y)*∑p(x|y)log{1/p(x/y)} H(X|Y)表示得到Y后,X的平均信息量,即平均不确定度。 (5) Fano不等式:设X和Y都是离散随机变量,都取值于集合{x1,x2,...x r}。则 H(X|Y)<=H(Pe)+Pe*log(r-1) 其中Pe=P{X≠Y}。Fano表示在已经知道Y后,仍然需要通过检测X才能获得的信息量。检测X的一个方法是先确定X=Y。若X=Y,就知道X;若X≠Y,那么还有r-1个可能。 (6) 互信息量:I(X;Y)=H(X)-H(X|Y)。I(X;Y)可以理解成知道了Y后对于减少X的不确定性的贡献。 I(X;Y)的公式: I(X;Y)=∑(x,y)p(x,y)log{p(y|x)/p(y)} (7)联合熵定义为两个元素同时发生的不确定度。 联合熵H(X,Y)= ∑(x,y)p(x,y)logp(x,y)=H(X)+H(Y|X) (8)信道中互信息的含义 互信息的定义得: I(X,Y)=H(X)-H(X|Y)= I(Y,X)=H(Y)-H(Y|X) 若信道输入为H(X),输出为H(Y),则条件熵H(X|Y)可以看成由于信道上存在干扰和噪声而损失掉的平均信息量。条件熵H(X|Y)又可以看成由于信道上的干扰和噪声的缘故,接收端获得Y后还剩余的对符号X的平均不确定度,故称为疑义度。 条件熵H(Y|X)可以看作唯一地确定信道噪声所需要的平均信息量,故称为噪声熵或者散布度。 (9)I(X,Y)的重要结论

信息熵理论的应用研究

信息熵理论的应用研究 [摘要] 广告活动是信息的活动,信息熵是信息活动的度量标准。本文利用信息熵理论对广告活动中的信息处理、广告传播、广告效果测定和广告受众进行了论证,指出了广告信息活动的规律。 [关键词] 信息熵;负熵;广告活动;广告受众 广告是一种非人际的信息传播,是信息交流的工具。广告系统实质上是信息系统,它具备了信息传播的五要素:谁——通过什么媒介——对谁——说了什么——取得了什么效果。广告的信息传播包括:广告发布者(包括广告主、广告制作者和传播者,即信息源)、广告信息内容、广告媒介、广告受众、广告效果等要素。信息熵理论是描述信息系统发展的基本理论,利用信息熵从信息的角度分析广告行为、预判广告活动的发展趋势,是研究广告活动的一种新方法。 一、熵、信息熵与广告活动的理论分析 熵是一个重要的物理概念,热力学中的熵通常被用于表征一个物理系统的无序程度。随着科学综合化的发展,熵又远远超出物理学范围。1948年,香农(shannon)第一次将熵这一概念引入到信息论中,从此,熵这一概念被广泛用于信息的度量,在自然科学和社会科学众多领域中得到广泛应用,并成为一些新学科的理论基础,由狭义熵发展为广义熵。正如爱因斯坦的评价那样:“熵理论对于整个科学来说是第一法则”。熵表示的是系统固有的、规律性的本质。在没有外界作用下,一个系统的熵越增,不可用能就越大,动力越小;换言之,一个系统的熵不相同时,对于相等的进程,它们的利用价值可以大不相同。一个孤立系统的熵永不减少,这叫做熵增原理。根据这一原理,以熵变为判据,不仅可以判断过程进行的方向,而且还能给出孤立系统达到平衡的条件。熵增原理揭示了一切自发过程都是不可逆的这一共同本质。为了打破平衡,必须与外部系统交换熵,从外部系统得到的熵称为负熵,目的是使本系统的熵值减少,更具有活力。

信息熵在图像处理中的应用

信息熵在图像处理中的应用 摘要:为了寻找快速有效的图像处理方法,信息理论越来越多地渗透到图像处理技术中。文章介绍了信息熵在图像处理中的应用,总 结了一些基于熵的图像处理特别是图像分割技术的方法,及其在这一领域内的应用现状和前景 同时介绍了熵在织物疵点检测中的应用。 Application of Information Entropy on Image Analysis Abstract :In order to find fast and efficient methods of image analysis ,information theory is used more and more in image analysis .The paper introduces the application of information entropy on the image analysis ,and summarizes some methods of image analysis based on information entropy ,especially the image segmentation method .At the same time ,the methods and application of fabric defect inspection based on information entropy ale introduced . 信息论是人们在长期通信实践活动中,由通信技术与概率论、随机过程、数理统计等学科相结合而逐步发展起来的一门新兴交叉学科。而熵是信息论中事件出现概率的不确定性的量度,能有效反映事件包含的信息。随着科学技术,特别是信息技术的迅猛发展,信息理论在通信领域中发挥了越来越重要的作用,由于信息理论解决问题的思路和方法独特、新颖和有效,信息论已渗透到其他科学领域。随着计算机技术和数学理论的不断发展,人工智能、神经网络、遗传算法、模糊理论的不断完善,信息理论的应用越来越广泛。在图像处理研究中,信息熵也越来越受到关注。 1 信息熵 1948年,美国科学家香农(C .E .Shannon)发表了一篇著名的论文《通信的数学理论》 。他从研究通信系统传输的实质出发,对信息做了科学的定义,并进行了定性和定量的描述。 他指出,信息是事物运动状态或存在方式的不确定性的描述。其通信系统的模型如下所示: 图1 信息的传播 信息的基本作用就是消除人们对事物的不确定性。信息熵是信息论中用于度量信息量的一个概念。假定X 是随机变量χ的集合,p (x )表示其概率密度,计算此随机变量的信息熵H (x )的公式是 P (x ,y )表示一对随机变量的联合密度函数,他们的联合熵H (x ,y )可以表示为 信息熵描述的是信源的不确定性,是信源中所有目标的平均信息量。信息量是信息论的中心概念,将熵作为一个随机事件的不确定性或信息量的量度,它奠定了现代信息论的科学理论基础,大大地促进了信息论的发展。设信源X 发符号a i ,的概率为Pi ,其中i=1,2,…,r ,P i >O ,要∑=r i Pi 1=1,则信息熵的代数定义形式为:

基于信息增量特征选择的微表情识别方法

2019年5月May 2019第45卷第5期 Vol. 45 No. 5 -多媒体技术及应用?计算机工程Computer Engineering 文章编号:1000-3428 (2019) 05-0261-06 文献标志码:A 中图分类号:TP391.4 基于信息增量特征选择的微表情识别方法 张延良,卢冰 (河南理工大学物理与电子信息学院,河南焦作454150) 摘要:基于LBP-TOP 、HOG-TOP 、HIGO-TOP 特征描述子的微表情识别方法通常提取到的特征向量维度较高,计 算复杂度较大,运行时间较长,识别准确率较低$为此,提出一种基于信息增量(IG)特征选择的识别方法$运用 IG 特征选择方法对高维度特征向量进行降维,提高识别效率$运用支持向量机分类器的线性核、卡方核、直方图交 叉核进行留一交叉验证,以完成分类任务$在SMIC 和CASME2数据集上进行实验,结果表明,经IG 选择后,特征 向量在2个数据集上的识别准确率分别达到76.22%和73.68%,分类所需时间分别缩短为原方法的3.67%和 3.64%,验证了该方法的有效性$ 关键词:微表情识别;信息增量;特征描述子;SVM 分类器;核函数中文引用格式:张延良,卢冰.基于信息增量特征选择的微表情识别方法[J ].计算机工程,2019,45 (5) :261-266. 英文弓丨用格式:ZHANG Yanliang ,LU Bing. Micro-axpression recognition method based on information gain feature selection [ J ]. Computer Engineering ,2019,45 (5) :261 -266. Micro-Expression Recognition Mettod Based on Information Gait Featurr Selection ZHANG Yanliang ,LU Bing (School of Physics and Electronic Information Engineering & Henan Polytechnic University & Jiaozuo & Henan 454150,China)+ Abstract] Micro-axpression recognition method based on feature descriptor of LBP-TOP ,HOG-TOP and HIGO-TOP usually extract feature vectors with high dimensions ,and have high computation complexity ,long running time and low recognition accuracy . Therefore ,a recognition method based on Information Gain ( IG ) feature selection is proposed. The IG feature selection method it applied to reducc the dimensions of feature vectors and improve the recognition efficiency. The Leave-One-Cubject-Out Cross Validation it performed for the micro-axpression classification with linear kernel ,chi- square kernel and histogram intersection kernel of Support Vector Machine ( SVM ) classifier. On the SMIC and CASME2 datasets ,the recognition accuracy of feature vectors selected by IG achieves 76. 22% and 73.68% respectively. And the time required for classification is only 3.67% and 3.64% of the original method. These resultt prove the effectiveness of the proposed method. + Key words ] micro-axpression recognition ; Information Gain ( IG ) ; feature descriptors ; SVM classifier ; kernel functions DOn :10. 19678/j. issn. 1000-3428.0052002 0概述 表情是一种非言语行为,能够展现人的情感$ 心理学家认为,“情感表达”由55%的表情、38%的 声音和7%的语言组成[1],这足以证明表情信息的巨 大作用$在过去的几十年里,人脸表情识别得到广 泛的研究[$l ],其中大多以普通表情为研究对象$除 了人脸普通表情外,在心理抑制状态下,面部肌肉不 受控制而产生的微表情[4],同样具有巨大的研究 价值$微表情的持续时间较短,一般为1 /25 s ~1 /3 -, 且动作幅度非常小[5-]$因此,正确观测并识别微表 情的难度较大[7],用裸眼准确捕捉和识别微表情的 成功率很低$文献[8 ]开发了微表情识别训练工具 METT ,以提高对微表情的识别准确率$然而,经过 专业训练后,其识别准确率仅达到47 % [ 9]$近年来, 基金项目:国家自然科学基金(61571339);网络与交换技术国家重点实验室开放课题(SKLNST-2016-1 -02 );河南理工大学博士基金 (B2012-100) o 作者简介:张延良(1979―),男,副教授、博士,主研方向为微表情识别、人工智能、信号处理、机器学习;卢 冰,硕士研究生$收稿日期:2018-07-03 修回日期:2018-08-08 E-mail :ylzhang@ hpu. edu. cn

信息熵及其性质和应用

农业大学 本科生课程论文 论文题目信息熵及其性质和应用学生专业班级信息与计算科学09级2班学生学号 20093992 指导教师吴慧 完成时间2012年06月25日 2012 年 06 月 25 日

课程论文任务书 学生指导教师吴慧 论文题目信息熵及其性质和应用 论文容(需明确列出研究的问题):研究信息熵的目的就是为了更深入的了解信息熵,更好的了解信息熵的作用,更好地使用它解决现实生活中的问题。文中介绍了信息熵的定义和性质及其应用。使我们对信息熵有跟深入的了解。 资料、数据、技术水平等方面的要求:论文要符合一般学术论文的写作规,具备学术性、科学性和一定的创造性。文字要流畅、语言要准确、论点要清楚、论据要准确、论证要完整、严密,有独立的观点和见解。容要理论联系实际,计算数据要求准确,涉及到他人的观点、统计数据或计算公式等要标明出处,结论要写的概括简短。参考文献的书写按论文中引用的先后顺序连续编码。 发出任务书日期 06月15日完成论文日期 06月25日 教研室意见(签字) 院长意见(签字)

信息熵及其性质和应用 信息与计算科学专业 指导教师吴慧 摘要:信息熵是随机变量不确定性的度量,文中从信息熵的定义出发,结合信息熵的性质,介绍了目前信息熵在具体问题中的应用。信息是一个十分通俗而又广泛的名词,它是人类认识世界、改造世界的知识源泉。人类社会发展的速度,在一定程度上取决于人类对信息利用的水平,所以对信息的度量就很有必要。香农提出信息的一种度量,熵的定义形式,它是随机变量不确定性的度量,文中主要介绍熵的性质及其应用。 关键词;信息熵性质应用 Information entropy and its properties and Application Student majoring in Information and Computing Science Specialty dongqiang Tutor WuHui Abstract:information entropy is a measure of uncertainty of random variable, this paper from the definition of information entropy, combined with the nature of information entropy, information entropy, introduced the specific issues in the application https://www.sodocs.net/doc/e05024027.html,rmation is a very popular and wi dely noun, it is human understanding of the world, transforming the world knowledge source . The human society development speed, depend on on certain level the human make use of information level, so the measurement information is necessary.Shannon put forward the informa-tion a kind of measurement, the definition of entropy form, it is the uncertainty of random variable metric, this paper mainly introduces the property of entropy and its application. Key words:information entropy properties application

中文公众事件信息熵计算方法

中文信息处理报告 课题名称搜索引擎中的关键技术及解决学院(系)电子信息与工程学院 专业计算机科学与技术 学号072337 学生姓名张志佳 完成时间2009年1月 3 日

目前,国内的每个行业,领域都在飞速发展,这中间产生了大量的中文信息资源,为了能够及时准确的获取最新的信息,中文搜索引擎应运而生。中文搜索引擎与西文搜索引擎在实现的机制和原理上大致相同,但由于汉语本身的特点,必须引入对于中文语言的处理技术,而汉语自动分词技术就是其中很关键的部分,也是进行后续语义或者是语法分析的基础。汉语自动分词到底对搜索引擎有多大影响?对于搜索引擎来说,最重要的并不是找到所有结果,最重要的是把最相关的结果排在最前面,这也称为相关度排序。中文分词的准确与否,常常直接影响到对搜索结果的相关度排序。分词准确性对搜索引擎来说十分重要,但如果分词速度太慢,即使准确性再高,对于搜索引擎来说也是不可用的,在Internet上有上百亿可用的公共Web页面,如果分词耗用的时间过长,会严重影响搜索引擎内容更新的速度。因此对于搜索引擎来说,分词的准确性和速度,都需要达到很高的要求。 更具体的说,现在的搜索引擎要达到下面的三要求,才能适应当今这样一个信息爆炸的时代,分别是:数据量达到亿,单次查询毫秒级,每日查询总数能支持千万级。撇开搜索引擎要用到的数量庞大的服务器硬件和速度巨快的网络环境不提,就单单说说搜索引擎中软件部分的三大核心技术。我个人以为:一个优秀的搜索引擎,它必需在下面三个方面的技术必须是优秀的:中文分词,网络机器人(Spider)和后台索引结构。而这三方面又是紧密相关的,想要解决中文分词问题,就要解决搜索时间和搜索准确率两方面的难题。而搜索时间上便是通过网络机器人(Spider)和后台索引结构的改进实现的,搜索准确率则是通过分词本身算法的求精来实现的。下面的文章将从这两个大的方面来解决这两方面的问题。 为了能够更清楚的来说明现在的搜索引擎是如何解决这几个难题的,首先对搜索引擎的组成及工作原理在这里简要的说明一下。 搜索引擎的工作,可以看做三步:从互联网上抓取网页,建立索引数据库,在索引数据库中搜索排序。从互联网上抓取网页利用能够从互联网上自动收集网页的Spider系统程序,自动访问互联网,并沿着任何网页中的所有URL爬到其它网页,重复这过程,并把爬过的所有网页收集回来。下面是搜索引擎的工作原理图:Array 搜索引擎工作原理图1

最新信息熵的matlab程序实例资料

求一维序列的信息熵(香浓熵)的matlab程序实例 对于一个二维信号,比如灰度图像,灰度值的范围是0-255,因此只要根据像素灰度值(0-255)出现的概率,就可以计算出信息熵。 但是,对于一个一维信号,比如说心电信号,数据值的范围并不是确定的,不会是(0-255)这么确定,如果进行域值变换,使其转换到一个整数范围的话,就会丢失数据,请高手指点,怎么计算。 比如数字信号是x(n),n=1~N (1)先用Hist函数对x(n)的赋值范围进行分块,比如赋值范围在0~10的对应第 一块,10~20的第二块,以此类推。这之前需要对x(n)做一些归一化处理 (2)统计每一块的数据个数,并求出相应的概率 (3)用信息熵公式求解 以上求解方法获得的虽然是近似的信息熵,但是一般认为,这么做是没有问题的 求一维序列的信息熵的matlab程序代码如下:(已写成调用的函数形式) 测试程序: fs=12000; N=12000; T=1/fs; t=(0:N-1)*T; ff=104; sig=0.5*(1+sin(2*pi*ff*t)).*sin(2*pi*3000*t)+rand(1,length(t)); Hx=yyshang(sig,10) %———————求一维离散序列信息熵matlab代码 function Hx=yyshang(y,duan) %不以原信号为参考的时间域的信号熵 %输入:maxf:原信号的能量谱中能量最大的点 %y:待求信息熵的序列 %duan:待求信息熵的序列要被分块的块数 %Hx:y的信息熵 %duan=10;%将序列按duan数等分,如果duan=10,就将序列分为10等份 x_min=min(y); x_max=max(y); maxf(1)=abs(x_max-x_min); maxf(2)=x_min; duan_t=1.0/duan; jiange=maxf(1)*duan_t; % for i=1:10 % pnum(i)=length(find((y_p>=(i-1)*jiange)&(y_p