曙光集群用户使用手册

1.登录和文件传输

登录方式为ssh,与telnet功能类似,推荐的登录工具为putty或者Secure Shell (,绿色版无需安装)

在地址栏输入本集群的登录地址(node1对应的局域网IP),点击“打开”,就会出现登录窗口,输入用户名、密码即可。

文件传输为sftp,与传统ftp类似,但其协议更安全可靠,推荐工具为filezilla。

(,绿色版无需安装)

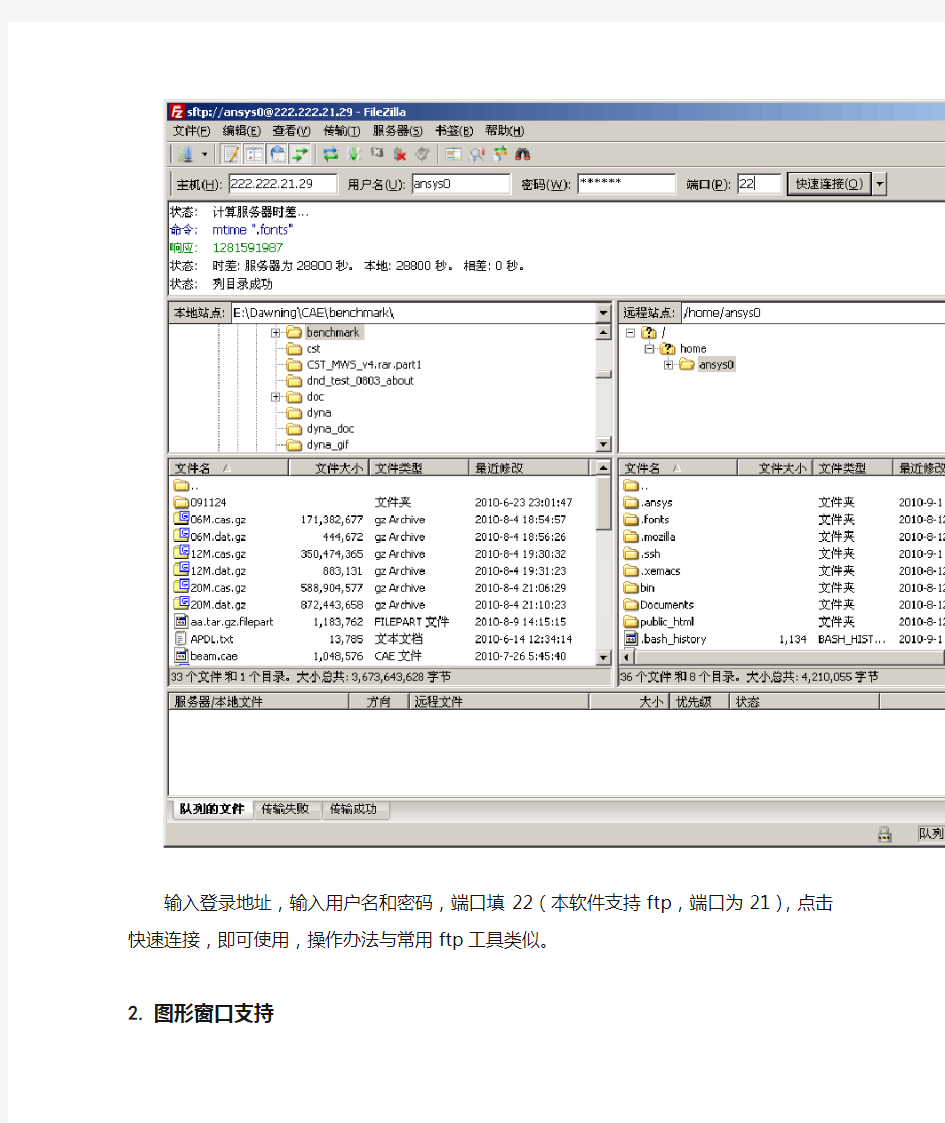

输入登录地址,输入用户名和密码,端口填22(本软件支持ftp,端口为21),点击快速连接,即可使用,操作办法与常用ftp工具类似。

2.图形窗口支持

Linux推荐使用vnc。vnc可以将用户的操作状态保持在服务器端,即使断开连接也不会影响到正在进行的操作、计算等。

登录到linux服务器中,在命令行运行vncserver。第一次运行时需要输入VNC登陆用的密码:

根据提示输入新的vnc密码。此密码与用户登录密码无关,将在登录vnc时需要。

此处提示的node1:2即为vnc成功打开的端口。

运行vncclient,输入登录服务器地址和端口号,点确定,输入前面设置的密码,即进入了图形窗口。

注意:

1、在第一次启动了vncserver之后,vnc的连接一直可用,全部图形窗口保持在Linux 服务器上。因此,只在每次服务器重新启动后运行一次vncserver即可,由于用户较多,请勿启动多个。

2、如果需要使用node2的图形界面,可执行ssh -X node2。

3.作业提交

3.1.Fluent

3.1.1.图形方式运行

首先通过VNC登陆到图形界面,如果没有Terminal的话在桌面点击左键选择Xterm,输入以下命令即可运行:

此处myhosts为用户指定的host文件,内容如下所示:

node1

node1

node1

node1

node2

node2

node2

node2

-t8即指定8个核心参与计算,分别为node1上的4个核心和node2上的4个核心。

在图形界面下导入cas和data文件,修改和设置边界条件等并计算 (和在windows下操作单机版Fluent相同,略):

注:通过VNC使用图形界面方式运行fluent时,无需保持PC机与服务器的连接,只要vncserver没有重新启动,即可随时连接到原有的窗口。

3.1.2.命令行方式运行

建立script1文件:

script1内容如下:

(注:其中为cas文件名,根据实际进行修改;solve/iterate 25 表示迭代25步,也可根据需要修改步数。)

用命令行进行fluent计算:

此处myhosts为用户指定的host文件,内容如下所示:

node1

node1

node1

node1

node2

node2

node2

node2

-t8即指定8个核心参与计算,分别为node1上的4个核心和node2上的4个核心。

3.1.3.作业调度方式运行

注:PBS只持Fluent命令行运行方式的作业提交

1.编译脚本script1,内容如下(与上面脚本运行方式相同):

file/rcd 25

/file/wcd

parallel/timer/usage

exit

yes

2.编辑pbs脚本,内容如下:

#!/bin/bash

#PBS -N job1-8cpu

#PBS -l nodes=1:ppn=8

#PBS -j oe

INPUTFILE=script1

OUTPUTFILE=

cd $PBS_O_WORKDIR

#

# indicate using ib protocal and the udapl way. t8 indicates using

# 8 processors

#

NP=`cat $PBS_NODEFILE | wc -l`

date

fluent 3d -t$NP -cnf=$PBS_NODEFILE -g -i $INPUT >& $OUTPUT

date

exit 0

提交作业:qsub

用qstat -a和pbsnodes -a以及top命令查看作业是否正常排队运行。

注:红色字体部分需要根据实际情况改动,黑色字体为固定格式的内容。

3.1.

4.获取计算结果

1.如果用图形界面的方式运行fluent,可以在菜单中选择选择保存dat文件到当前工作目录或其他某个目录下,然后用ftp软件将dat文件下载到终端pc机上,即可进行后处理。

2.如果用命令行的方式运行fluent, dat文件自动保存到当前目录,文件名由script1文件的内容决定(例如“file/wcd ”则表示dat文件为),用软件将dat文件下载到终端pc机上,即可进行后处理。

3.2.Ansys作业

3.2.1.图形方式运行

通过vnc登录以后,运行launcher121,即可进入ansys界面,选择相关的模块点击run 即可。

3.2.2.命令行方式运行

在命令行方式下,不能进行交互的图形操作,所有的命令需要通过命令流来实现。

假设写好的命令流文件为,运行方式如下:

单节点:

ansys121 -np 16 -i >& &

多节点运行:

ansys121 -dis -machines node1:16:node2:16 -i >& &

3.2.3.作业调度方式运行

编写一个pbs脚本如下所示:

#!/bin/bash

#PBS -j oe

###################what you just need and could edit are between the two lines######################

#PBS -N my_ansys_test

#PBS -l nodes=1:ppn=16

INPUTFILE=

OUTPUTFILE=

###############################################the

end##############################################

cd $PBS_O_WORKDIR

np=1

for NODE in `cat $PBS_NODEFILE`; do

host=$NODE

if [ ! -z $lasthost ]; then

if [ $host = $lasthost ]; then

np=`expr $np + 1`

else

if [ -z $mList ]; then

mList=$lasthost:$np

else

mList=$mList:$lasthost:$np

fi

np=1

fi

fi

lasthost=$host

done

if [ -z $mList ]; then

mList=$lasthost:$np

else

mList=$mList:$lasthost:$np

fi

ansys121 -dis -machines $mList -i $INPUTFILE -o $OUTPUTFILE

写完以后提交方式与fluent相同,qsub 即可。

3.3.CFX作业

3.3.1.图形方式运行

在图形窗口中运行cfx5即可。

3.3.2.命令行方式运行

CFX支持PVM和MPI两种方式的并行,通常MPI的性能更好一些,建议采用。同时还有Local和Distributed两种运行模式,单机上建议采用Local模式,而跨节点时只能采用Distributed模式。

cfx5solve命令可直接进入求解模式。

cfx5solve -def -par-dist 'node1*8'

在本机上用8个核心并行

cfx5solve -def -par-dist 'node1*8,node2*8'

采用2个节点各8个核心进行分布式并行计算

3.3.3.作业调度方式运行

[test@node34 cfxbm]$ cat

#!/bin/bash

#PBS -N CFX_8cpu

#PBS -l nodes=1:ppn=8

INPUTFILE=

OUTPUTFILE=

##############################################################

########## You don't need to modify the lines below ##########

##############################################################

PeHostfile2MachineFile()

{

cat $1 | while read line; do

# echo $line

host=`echo $line`

# add here code to map regular hostnames into ATM hostnames

if [ -z $mList ]; then

mList=$host"*1"

else

mList=$mList,$host"*1"

fi

echo $mList

done

}

CFX_PBS_NODEFILE="/tmp/cfx_`whoami`_$PBS_JOBID"

PeHostfile2MachineFile $PBS_NODEFILE | sed "s#bnode#node#g" >$CFX_PBS_NODEFILE

NPROCS=`wc -l $PBS_NODEFILE`

cd $PBS_O_WORKDIR

cfx5solve -def $INPUTFILE -par-dist `tail -n1 $CFX_PBS_NODEFILE`

写完脚本就可以按如下方式提交作业:

[test@node34 cfxbm]$ qsub

3.4.ABAQUS作业

3.4.1.图形方式运行

在图形窗口中运行abaqus cae即可。

3.4.2.命令行方式运行

单节点运行:

abaqus -j cpus=8

跨节点运行:

首先需要添加指定运行节点。在工作目录进行以下操作:

echo "mp_host_list=[[\‘node1\’,8],[\‘node2\’,8]]" >表示分别从node1、node2调用8个core来进行计算。

设置好了环境变量以后,通过abaqus -j cpus=16 int来运行。

3.4.3.作业调度方式运行

[test@node34 cfxbm]$ cat

#!/bin/bash

#PBS -N abaqus_job

#PBS -l nodes=2:ppn=8

#PBS -j oe

####change your input file and jobname here ####

INPUTFILE=

JOB=`echo $INPUTFILE |cut -d "." -f 1`

cd ${PBS_O_WORKDIR}

source /public/software/

cpus=$(wc -l $PBS_NODEFILE | awk '{print $1}')

mp_host_list="["

for n in $(sort -u $PBS_NODEFILE)

do

mp_host_list="${mp_host_list}['$n',$(grep -c $n $PBS_NODEFILE)],"

done

mp_host_list=$(echo ${mp_host_list} | sed -e "s/,$/]/")

echo "mp_host_list=${mp_host_list}" >

STARTTIME=`date`

####the main execute command

abaqus job=${JOB} cpus=${cpus} mp_mode=mpi standard_parallel=all interactive ENDTIME=`date`

echo "the job start at :${STARTTIME}"

echo "the job end at :${ENDTIME}"

3.5.Web提交

使用IE打开并使用对应的用户名和密码登陆,点击作业调度-作业提交

集群名称为唯一的选项Cluster_node。。。,队列选择必须是用户对应的许可的队列,工作路径为输入文件所在的目录,通常为用户home目录下的含有模型文件的某一子目录,如test用户目录下的fluent目录中存放了fluent的输入文件、、,则工作路径为/cae01/home/test/fluent。选择命令行提交方式,将前面写好的pbs脚本放入输入框中,点击提交,即可将作业提交到对应的队列。

4.常用pbs命令

4.1.qsub 命令—提交作业

命令格式:

qsub [-a date_time] [-c interval] [-C directive_prefix]

[-e path] [-I] [-j join] [-k keep] [-l resource_list] [-m mail_options] [-M user_list][-N name] [-o path] [-p priority] [-q destination] [-r c]

[-S path_list] [-u user_list][-v variable_list] [-V]

[-W additional_attributes] [-z]

[script]

参数说明:因为所采用的选项一般放在pbs脚本中提交,所以具体见PBS脚本选项。

例:# qsub

提交某作业,系统将产生一个作业号

4.2.qstat 命令—查询作业

命令格式:qatat [-f][-a][-i] [-n][-s] [-R] [-Q][-q][-B][-u]

参数说明:

-f jobid 列出指定作业的信息

-a 列出系统所有作业

-i 列出不在运行的作业

-n 列出分配给此作业的结点

-s 列出队列管理员与scheduler所提供的建议

-R 列出磁盘预留信息

-Q 操作符是destination id,指明请求的是队列状态

-q 列出队列状态,并以alternative形式显示

-au userid 列出指定用户的所有作业

-B 列出PBS Server信息

-r 列出所有正在运行的作业

-Qf queue 列出指定队列的信息

-u 若操作符为作业号,则列出其状态。

若操作符为destination id,则列出运行在其上的属于user_list中用户的作业状态。

例:# qstat -f 211

查询作业号为211的作业的具体信息。

4.3.qdel 命令—删除作业

命令格式:qdel [-W 间隔时间] 作业号

命令行参数:

例:# qdel -W 15 211

15秒后删除作业号为211的作业

set server default_queue=batch"

4.4.PBS脚本文件

PBS脚本文件由脚本选项和运行脚本两部分组成。

(1) PBS作业脚本选项(若无-C选项,则每项前面加‘#PBS’)

-a date_time : date_time格式为:[[[[CC]YY]MM]DD]hhmm[.SS]

表示经过date_time时间后作业才可以运行。

-c interval :定义作业的检查点间隔,如果机器不支持检查点,则忽略此选项。

-C directive_prefix :在脚本文件中以directive_prefix开头的行解释为qsub的命

令选项。(若无此选项,则默认为’#PBS’ )

-e path :将标准错误信息重定向到path

-I :以交互方式运行

-j join :将标准输出信息与标准错误信息合并到一个文件join中去。

-k keep :定义在执行结点上保留标准输出和标准错误信息中的哪个文件。

keep为o 表示保留前者,e表示后者,oe或eo表示二者都保留,

n表示皆不保留。若忽略此选项,二者都不保留。

-l resource_list :定义资源列表。以下为几个常用的资源种类。

cput=N :请求N秒的CPU时间; N也可以是hh:mm:ss的形式。

mem=N[K|M|G][B|W]:请求N {kilo|mega|giga}{bytes|words} 大小的内存。

odes=N:ppn=M :请求N个结点,每个结点M个处理器。

-m mail_options :mail_option为a:作业abort时给用户发信;为b:作业开始运行发信;为e:作业结束运行时发信。若无此选项,默认为a。

-M user_list :定义有关此作业的mail发给哪些用户。

-N name :作业名,限15个字符,首字符为字母,无空格。

-o path :重定向标准输出到path。

-p priority :任务优先级,整数,[-1024,1023],若无定义则为0.

-q destination : destination有三种形式: queue , @server,queue@server。

-r y|n :指明作业是否可运行,y为可运行,n为不可运行。

-S shell :指明执行运行脚本所用的shell,须包含全路径。

-u user_list :定义作业将在运行结点上以哪个用户名来运行。

-v variable_list :定义export到本作业的环境变量的扩展列表。

-V :表明qsub命令的所有环境变量都export到此作业。

-W additional_attributes :作业的其它属性。

-z :指明qsub命令提交作业后,不在终端显示作业号。

曙光作业管理-调度系统安装配置手册

Torque + Maui配置手册之抛砖引玉篇 本文将以应用于实际案例(南航理学院、复旦大学物理系、宁波气象局)中的作业调度系统为例,简单介绍一下免费开源又好用的Torque+Maui如何在曙光服务器上进行安装和配置,以及针对用户特定需求的常用调度策略的设定情况,以便可以起到抛砖引玉的作用,使更多的人关注MAUI这个功能强大的集群调度器(后期将推出SGE+MAUI版本)。本文中的涉及的软件版本Torque 版本:2.1.7 maui版本:3.2.6p17。 1. 集群资源管理器Torque 1.1.从源代码安装Torque 其中pbs_server安装在node33上,TORQUE有两个主要的可执行文件,一个是主节点上的pbs_server,一个是计算节点上的pbs_mom,机群中每一个计算节点(node1~node16)都有一个pbs_mom负责与pbs_server通信,告诉pbs_server该节点上的可用资源数以及作业的状态。机群的NFS共享存储位置为/home,所有用户目录都在该目录下。 1.1.1.解压源文件包 在共享目录下解压缩torque # tar -zxf torque-2.1.17.tar.gz 假设解压的文件夹名字为: /home/dawning/torque-2.1.7 1.1. 2.编译设置 #./configure --enable-docs --with-scp --enable-syslog 其中, 默认情况下,TORQUE将可执行文件安装在/usr/local/bin和/usr/local/sbin下。其余的配置文件将安装在/var/spool/torque下 默认情况下,TORQUE不安装管理员手册,这里指定要安装。 默认情况下,TORQUE使用rcp来copy数据文件,官方强烈推荐使用scp,所以这里设定--with-scp. 默认情况下,TORQUE不允许使用syslog,我们这里使用syslog。 1.1.3.编译安装 # make # make install Server端安装设置: 在torque的安装源文件根目录中,执行 #./torque.setup root 以root作为torque的管理员账号创建作业队列。 计算节点(Client端)的安装: 由于计算节点节点系统相同,因而可以用如下SHELL script (脚本名字为torque.install.sh)在

中科曙光天阔I640r-G10服务器技术白皮书V1.0

曙光公司最新推出的I640r-G10存储服务器是一款支持英特尔最新双路 四核处理器的部门级服务器,创新的直连架构摆脱了以往机型由前端总线带来 的内存带宽的瓶颈,可彻底释放Intel Xeon多核处理器的强劲性能。该机型最 多可以支持96GB内存容量,集成高性能SAS控制器支持最多达24块热插拔3.5 寸SAS/SATA硬盘,如此强大的扩展性足以支撑关键任务的运行,满足资源密集 型应用的需要。先进的管理和存储技术,具有更好的可扩充性和高可用性。作为 中科曙光天阔系列双路服务器中的高端产品,I640r-G10服务器是高端部门级用 户的最佳选择,非常适用于金融、证券、交通、邮政、电信、能源等对服务器 性能、可扩展性及可靠性要求苛刻的行业数据中心和关键的企业应用。天阔服务器 I640r-G10

概述 多核处理器技术 使用Intel最新的5500、5600系列处理器,为用户的各项应用提供更高的性能。Intel Xeon 5500、5600系列处理器同前代产品相比,进行了各项重大的改进,包括处理器内部集成内存控制器,使系统从架构上摆脱了之前由前端总线(FSB)带来的内存瓶颈;引入QPI(Quick Path Interconnection)技术,使2颗处理器之间以及处理器的各个核心之间的互联更有效率,大大减少了对总线资源的挤占。强大的处理性能 处理器集成内存控制器,提供3条内存通道,可使用最新的DDR3 1333/1066 MHz 高性能内存,显著提高内存读写速率。 采用了Intel最新推出的5520系列芯片组,PCI-E 2.0的扩展支持,将总线带宽提高为原先PCI-E的2倍,为用户的高带宽应用需求提供了持续可靠的支持。集成高性能双千兆网卡,支持IOAT2以及VMDq等技术,提供高网络I/O性能。丰富的可扩展性 每颗CPU搭配6条内存插槽,内存总容量可扩展至96GB,提供更为灵活强大的内存配置选择。 最大支持24仓位硬盘,为用户构造海量存储提供可能。 5条I/O扩展槽,提供PCI-E 2.0、PCI-E的完备选择,既保护用户原有设备的兼容性、又预留未来扩充空间,保护投资。 高密度 采用4U机架式设计,独特的高密度机架式服务器散热结构设计,集高性能,高密度与高可靠性于一身。

高可用性集群系统的实现

高可用性集群系统的实现 《Linux企业应用案例精解》第8章主要介绍一下虚拟化技术应用。本节为大家介绍高可用性集群系统的实现。 8.3.5 高可用性集群系统的实现(1) VMware Infrastructure 的体系结构和典型配置 资源动态分配和高可用性的实现为构建高可用性集群系统提供了有力的保障,采用VMwae构建铁路企业高可用性集群,不需要为系统中的每台服务器分别添置备用服务器,就可以有效地降低系统成本,在基于VMware的我企业高可用性集群中,备用服务器安装了VMware ESX Server,与数据库服务器、Web服务器、OA服务器和文件服务器等构成高可用性集群,同时采用数据库备份服务器实现差额计划备份。 使用VMware提供的虚拟基础架构解决方案,服务器不再需要随着业务增加而添加,整个IT基础架构能得到有效控制并可充分发挥效能。只有当整体资源出现不足的时候,才需要增加服务器。而且对系统资源的

添加也非常简单,不再需要做繁琐的硬件维护以及业务迁移,只需要简单地将新服务器安装VMWARE? INFRASTRUCTURE 3软件,并添加到已有的VMWARE? INFRASTRUCTURE 3架构中即可,新增资源将自动分配到各个最需要的业务环境中。 在HA和DRS功能的共同支撑下,虚拟机的稳定、不间断运行得到了保证,而且,在没有搭建Cluster环境的情况下,迁移、升级依旧能不中断服务。哪怕是硬件升级、添加,正常停机维护等情况,也能够保证所有的业务正常运行,客户端访问服务器不产生业务中断现象。新的服务器虚拟化架构中另一个重点是VMware HA 的部署,它是整个服务器系统安全、可靠运行的一道防线。传统的热备机方式最大的问题就是容易造成资源的大量闲置;在正常运行状态下,所有备机服务器都处于闲置状态,不仅造成计算资源的空耗,而且还浪费大量的电力和散热资源,投资回报率非常低。 如何应对Linux系统软件包的依赖性问题 不管是初步跨入Linux殿堂的新手还是,具有多年经验的专家,在安装或编译软件包的过程中或多或少的都会遇到包的依赖问题从而导致安装过程无法继续,比如管理员在安装php软件包需要libgd.so文件,而这个文件属于gb软件包。但是在安装gb软件包时,可能这个软件包跟其他软件包又具有依赖关系,又需要安装其他软件包才行。这时有的管理员便失去耐心。在遇到这种Linux软件包依赖关系问题,该如何解决呢?在谈这个具体的措施之前,先跟大家聊聊Linux系统里的软件爱你依赖性问题。 我们把处理rpm依赖性故障的策略可以分成两类解决依赖性故障的自动方法和手工方法。但当安装不属于发行一部分的软件包时自动方法是不可用的。在描述如何手工解决依赖性故障后,将简要描述如何使用自动方法之一(YUM),但首先需要了解它们是什么及rpm如何强制实施它们。 一、什么是依赖性 程序依赖于程序代码的共享库,以便它们可以发出系统调用将输出发送到设备或打开文件等(共享库存在于许多方面,而不只局限于系统调用)。没有共享库,每次程序员开发一个新的程序,每个程序员都需要从头开始重写这些基本的系统操作。当编译程序时,程序员将他的代码链接到这些库。如果链接是静态的,编译后的共享库对象代码就添加到程序执行文件中;如果是动态的,编译后的共享库对象代码只在运行时需要它时由程序员加载。动态可执行文件依赖于正确的共享库或共享对象来进行操作。RPM依赖性尝试在安装时强制实施动态可执行文件的共享对象需求,以便在以后--当程序运行时--不会有与动态链接过程有关的任何问题。

浪潮WIN2K 集群服务解决方案

浪潮WIN2K 集群服务解决方案 集群服务的需求分析 随着Internet服务和电子商务的迅速发展,计算机系统的重要性也日益上升,对服务器可伸缩性和高可用性的要求也变得越来越高。集群技术的出现和发展则很好地解决了这两个问题。群集是由一组独立的计算机组成,这些计算机一起工作以运行一系列共同的应用程序,同时,为用户和应用程序提供单一的系统映射。群集内的计算机物理上通过电缆连接,程序上则通过群集软件连接。这些连接允许计算机使用故障应急与负载平衡功能,而故障应急与负载平衡功能在单机上是不可能实现的。 有网络负载平衡功能的Windows 2000为在分布和负载平衡的方式下建立关键且合乎要求的网站的工作提供了完整的基础结构。与组件服务的分布式应用程序特性和Internet 信息服务的增强可伸缩性相结合,网络负载平衡有助于确保服务能够灵活处理最重的通信负荷,同时,保持对服务器状态的监控,确保系统不停机。 Win2000群集技术具有以下特点: ·可伸缩性:加入更多的处理器或计算机可提高群集的计算能力,一般的桌面机每秒能够处理几千个请求,而传统的IA服务器每秒能够处理几万个请求。那么对于需要每秒处理几十万个请求的企业来说,如果不采用集群技术,唯一的选择就是购买更加高档的中、小型计算机。如果这样做,虽然系统性能提高了十倍,但其购买价格和维护费用就会上升几十倍甚至更多。 ·高度的可用性:群集具有避免单点故障发生的能力。应用程序能够跨计算机进行分配,以实现并行运算与故障恢复,并提供更高的可用性。即便某一台服务器停止运行,一个由进程调用的故障应急程序会自动将该服务器的工作负荷转移至另一台服务器,以保证提供持续不断的服务。 ·易管理性:群集以单一系统映射的形式来面向最终用户、应用程序及网络,同时,也为管理员提供单一的控制点,而这种单一控制点则可能是远程的。 随着计算机应用地位的逐渐提升,系统安全和重要性的日益增加,基于Win2000的负载均衡必将会有着极为广阔的应用前景。 Win2K集群技术 一、集群

曙光集群用户使用手册

1. 登录和文件传输 登录方式为ssh,与telnet功能类似,推荐的登录工具为putty或者Secure Shell (https://www.sodocs.net/doc/716663499.html,/html/download/ser/20070917/35112.html,绿色版无需安装) 在地址栏输入本集群的登录地址(node1对应的局域网IP),点击“打开”,就会出现登录窗口,输入用户名、密码即可。 文件传输为sftp,与传统ftp类似,但其协议更安全可靠,推荐工具为filezilla。 (https://https://www.sodocs.net/doc/716663499.html,/p/filezilla/download?filename=FileZilla_3.3.2_win32.zip,绿色版无需安装)

输入登录地址222.222.21.29,输入用户名和密码,端口填22(本软件支持ftp,端口为21),点击快速连接,即可使用,操作办法与常用ftp工具类似。

2. 图形窗口支持 Linux推荐使用vnc。vnc可以将用户的操作状态保持在服务器端,即使断开连接也不会影响到正在进行的操作、计算等。 登录到linux服务器中,在命令行运行vncserver。第一次运行时需要输入VNC登陆用的密码: 根据提示输入新的vnc密码。此密码与用户登录密码无关,将在登录vnc时需要。 此处提示的node1:2即为vnc成功打开的端口。 运行vncclient,输入登录服务器地址和端口号,点确定,输入前面设置的密码,即进入了图形窗口。

注意: 1、在第一次启动了vncserver之后,vnc的连接一直可用,全部图形窗口保持在Linux 服务器上。因此,只在每次服务器重新启动后运行一次vncserver即可,由于用户较多,请勿启动多个。 2、如果需要使用node2的图形界面,可执行ssh -X node2。 3. 作业提交 3.1. Fluent 3.1.1. 图形方式运行 首先通过VNC登陆到图形界面,如果没有Terminal的话在桌面点击左键选择Xterm,输入以下命令即可运行:

高可用性集群解决方案设计HA

1.业务连续 1.1.共享存储集群 业务系统运营时,服务器、网络、应用等故障将导致业务系统无常对外提供业务,造成业务中断,将会给企业带来无法估量的损失。针对业务系统面临的运营风险,Rose提供了基于共享存储的高可用解决方案,当服务器、网络、应用发生故障时,Rose可以自动快速将业务系统切换到集群备机运行,保证整个业务系统的对外正常服务,为业务系统提供7x24连续运营的强大保障。 1.1.1.适用场景 基于共享磁盘阵列的高可用集群,以保障业务系统连续运营 硬件结构:2台主机、1台磁盘阵列

主机 备机心跳 磁盘阵列 局域网 1.1. 2.案例分析 某证券公司案例 客户需求分析 某证券公司在全国100多个城市和地区共设有40多个分公司、100多个营业部。经营围涵盖:证券经纪,证券投资咨询,与证券交易、证券投资活动有关的财务顾问,证券承销与保荐,证券自营,证券资产管理,融资融券,证券投资基金代销,金融产品代销,为期货公司提供中间介绍业务,证券投资基金托管,股票期权做市。 该证券公司的系统承担着企业的部沟通、关键信息的传达等重要角色,随着企业的业务发展,系统的压力越来越重。由于服务器为单机运行,如果发生意外宕机,将会给企业的日常工作带来不便,甚至

给企业带来重大损失。因此,急需对服务器实现高可用保护,保障服务器的7×24小时连续运营。 解决方案 经过实际的需求调研,结合客户实际应用环境,推荐采用共享存储的热备集群方案。部署热备集群前的单机环境:业务系统,后台数据库为MySQL,操作系统为RedHat6,数据存储于磁盘阵列。 在单机单柜的基础上,增加1台备用主机,即可构建基于共享存储的热备集群。增加1台物理服务器作为服务器的备机,并在备机部署系统,通过Rose共享存储热备集群产品,实现对应用的高可用保护。如主机上运行的系统出现异常故障导致宕机,比如应用服务异常、硬件设备故障,Rose将实时监测该故障,并自动将系统切换至备用主机,以保障系统的连续运营。

曙光IPMI系统管理平台用户使用指南

曙光I P M I系统管理平台 用户使用指南 目录

概述 IPMI是智能型平台管理接口(Intelligent Platform Management Interface)的缩写,它是管理企业级服务器系统中所使用的采用的一种工业标准。它为服务器的监控提供了一种智能的管理方式,用户可以利用IPMI监视服务器的物理健康特征,如温度、电压、风扇工作状态、电源状态等。它能够不依赖操作系统独立运行,即使系统本身的运作不正常,或是由于任何原因而无法提供服务,IPMI仍可正常运作。它适用于Windows、Linux、Solaris或其它混合型操作系统。 ?智能平台管理接口(IPMI) 智能平台管理接口(IPMI)定义了一系列的统一的基于接口的信息,这些信息包括监视器系统硬件健康(风扇速度、温度、电压、电力供应等等)、控制系统组件、和用于以后测试用的关于重要系统事件存储的数据。IPMI提供了远程平台管理功能。 ?基板管理控制器(BMC) 在IPMI 中关键的组成部件是基板管理控制器(BMC),BMC 芯片集成于服务器的主板上。BMC 在IPMI 架构中负责监视和控制系统的可管理设备。BMC 通过智能平台管理总线(IPMB)连接着许多传感器。一个子集有12C 总线。系统软件与BMC 之间的通信用一个keyboard controller style(KCS) 接口。 BMC 具有以下功能: 1.通过系统的串行端口进行访问 2. 故障日志记录和 SNMP 警报发送 3.访问系统事件日志 (System Event Log ,SEL) 和传感器状况 4.控制包括开机和关机 5.独立于系统电源或工作状态的支持

浪潮报表使用规范概述

浪潮报表使用规范 一、 报表使用操作流程 二、操作讲明 系统治理接收报表格式 报表格式、公 进行报表数据 定制、维护报 报表数据计算 报表数据审核 帐表数据核对 一般操作集团报表 报表格式定制 发送报表格式

A 集团报表 集团报表统一由集团系统治理员定制(定制报表方法与GS3.5软件系统相同),定制完成后转出报表格式,发送下级单位接收即可。 B 系统治理员 B-1 转入报表格式: 将集团下发的报表格式公式执行“转入”操作。内容包括格式、计算公式、校验公式、报表类不、标准编码信息。 功能位置 进入报表模块,选择【报表操作】菜单下的【报表转入】功能。 操作步骤 进入该功能后,显示窗口如图所示。

选择【选择文件】按钮,系统弹出如下图所示对话框。 选择差不多存在的转出文件即可。现在,系统显示如图所示。

选择要转入的报表名称,也能够选择【全选】,转入内容,点击【转入】完成对报表的更新操作。 B-2 报表格式、公式爱护: 【报表启封封存功能】提供了对报表格式和公式的爱护。通常情况,多个操作员对相同的报表会有各种操作权限,可能刚刚定义好的报表会被其他不了解情况的操作员改变。报表封存功能确实是针对那个问题提出来的,它能在灵活使用报表定义功能的同时,有效保证报表格式和公式的安全性和正确性。 功能位置 进入报表模块,选择【报表操作】菜单下的【报表启封封存】功能。 操作步骤 进入该功能后,系统显示界面如图所示。

项目讲明: 【格式封存】:有不爱护、低级爱护、中级爱护、高级爱护四个选项。 其含义如下: ①不爱护:没有限制; ②低级爱护:禁止用户修改格式区、数据区、行数、列数、标题行数、表头行数、表体行数,插入行列、删除行列; ③中级爱护:除差不多爱护信息不同意修改外,另:标题的内容、副标题的内容、表头内容、格式的内容、合并单元格、小数位数、数据类不、是否爱护,单元格对应的指标代码、设置行对应标准类不、列对应标准类不不同意修改; ④高级爱护:除中级爱护的内容不同意修改之外,另:行高、列

曙光负载均衡系统用户手册

负载均衡产品用户手册

声明 本手册的用途在于帮助您正确地使用曙光公司产品(以下称“本产品”),在安装和第一次使用本产品前,请您务必先仔细阅读随机配送的所有资料,特别是本手册中所提及的注意事项。这会有助于您更好和安全地使用本产品。请妥善保管本手册,以便日后参阅 本手册的描述幵不代表对本产品觃栺和软、硬件配置的仸何说明。有关本产品的实际觃栺和配置,请查阅相关协议、装箱单、产品觃栺配置描述文件,或向产品的销售商咨询。 如您不正确地或未按本手册的指示和要求安装、使用或保管本产品,或让非曙光公司授权的技术人员修理、变更本产品,曙光公司将不对由此导致的损害承担仸何责仸。 本手册中所提供照片、图形、图表和揑图,仅用于解释和说明目的,可能与实际产品有些差别,另外,产品实际觃栺和配置可能会根据需要不时变更,因此与本手册内容有所不同。请以实际产品为准。 本手册中所提及的非曙光公司网站信息,是为了方便起见而提供,此类网站中的信息不是曙光公司产品资料的一部分,也不是曙光公司服务的一部分,曙光公司对这些网站及信息的准确性和可用性不做仸何保证。使用此类网站带来的风险将由您自行承担。 本手册不用于表明曙光公司对其产品和服务做了仸何保证,无论是明示的还是默示的,包括(但不限于)本手册中推荐使用产品的适用性、安全性、适销性和适合某特定用途的保证。对本产品及相关服务的保证和保修承诺,应按可适用的协议或产品标准保修服务条款和条件执行。在法律法觃的最大允许范围内,曙光公司对于您的使用或不能使用本产品而収生的仸何损害(包括,但不限于直接或间接的个人损害、商业利润的损失、业务中断、商业信息的遗失或仸何其他损失),不负仸何赔偿责仸。 对于您在本产品乊外使用本产品随机提供的软件,或在本产品上使用非随机软件或经曙光认证推荐使用的专用软件乊外的其他软件,曙光公司对其可靠性不做仸何保证。 曙光公司已经对本手册迚行了仔细的校勘和核对,但不能保证本手册完全没有仸何错误和疏漏。为更好地提供服务,曙光公司可能会对本手册中描述的产品乊软件和硬件及本手册的内容随时迚行改迚和/或修改,恕不另行通知。如果您在使用过程中収现本产品的实际情冴与本手册有不一致乊处,或您想得到最新的信息或有仸何问题和想法,欢迎致电我们或登陆曙光公司服务网站垂询。

曙光天阔服务器

曙光天阔服务器

曙光天阔服务器 I620r-G 特点: ●领先行业的超高应用性能●真正企业级的可靠和可用性●支持诸多先进技术 ●便于管理和部署曙光天阔I620r-G服务器是曙光公司最新推出的一款支持英特尔最新双路四核处理器的部门级服务器,创新的直连架构摆脱了以往机型由前端总线带来的内存带宽的瓶颈,可彻底释放2颗64位 Intel Xeon DP多核处理器的强劲性能,最高达 96GB 的DDR3内存以及集成高性能SAS控制器支持的多达12块热插拔3.5寸SAS硬盘提供了强大的功能以运行关键任务,满足资源密集型应用的需要。先进的管理和存储技术,具有更好的可扩充性和高可用性。作为曙光天阔系列双路服务器中的高端产品,I620r-G服务器是高端部门级用户的最佳选择,非常适用于金融、证券、交通、邮政、电信、能源等对服务器性能、可扩展性及可靠性要求苛刻的行业数据中心和远程的企业环境。 概述 多核处理器技术 使用Intel最新的5500系列处理器,为用户的各项应用提供更高的性能。Intel Xeon 5500系列处理器同前代产品相比,进行了各项重大的改进,包括处理器内部集成内存控制器,使系统从架构上摆脱了之前由前端总线(FSB)带来的内存瓶颈;引入QPI(Quick Path Interconnection)技术,使2颗处理器之间以及处理器的各个核心之间的互联更有效率,减少了对总线资源的挤占。 强大的处理性能 处理器集成内存控制器,提供3内存通道,可使用最新的DDR3 1333/1066 MHz 高性能内存,显著提供内存读写速率。 使用Intel最新推出的5520系列芯片组,提供PCI-E 2.0的扩展支持,将总线带宽提高为原先PCI-E的2倍,为用户的高带宽应用需求提供了支持。 集成Intel 82576高性能双千兆网卡,支持IOAT2以及VMDq等技术,提供高网络I/O性能。 丰富的可扩展性 每颗CPU搭配6根内存插槽,内存容量可扩展至48GB,提供灵活且强大的内存配置选择。 标配8个硬盘仓位,最大可扩展至12个硬盘仓位,为用户构造海量存储提供可能。 6根I/O扩展槽,提供从PCI-E 2.0、PCI-E到普通32bit/33MHz PCI的完整选择,既保护用户原有设备的兼容性、又预留未来发展空间,保护投资。 高密度 采用2U机架式设计,独特的高密度机架式服务器散热结构设计,集高性能,高密度与高可靠性于一身。 页码:2 版本1.0

曙光Gridview2.0安装维护手册2.0

Gridview2.0 安装维护手册

Gridview2.0安装维护手册 目录 1、系统安装 0 1-1、安装条件 0 1-2、 GRIDVIEW2.0安装前设置 0 1-3、 GRIDVIEW2.0安装 (5) 1-3- -1、管理节点安装 (5) 1-3- -2、计算节点安装 (7) 1-4、安装后的验证 (8) 1-4- -1、管理节点验证 (8) 1-4- -2、计算节点验证 (9) 2、系统卸载 (10) 2-1、管理节点卸载 (10) 2-1- -1、卸载步骤—计算中心版 (10) 2-1- -2、卸载步骤—数据中心版............................ 错误!未定义书签。 2-2、计算节点卸载 (10) 2-2- -1、批量卸载—计算中心版............................ 错误!未定义书签。 2-2- -2、手动卸载—计算中心版............................ 错误!未定义书签。 2-2- -3、批量卸载—数据中心版............................ 错误!未定义书签。 2-2- -4、手动卸载—数据中心版............................ 错误!未定义书签。 3、系统维护 (11) 3-1、配置文件 (11) 3-1- -1、安装配置文件 (11) 3-1- -2、 PORTAL相关配置文件 (12) 3-1- -3、告警预处理相关配置文件 (12) 3-1- -4、 LOG配置文件 (13) 3-1- -5、采集相关配置文件 (13) 3-1- -6、 HIBERNATE配置文件 (16) 3-1- -7、作业调度管理进程配置文件 (18) 3-2、设备信息导入及参数设置 (19) 3-2- -1、设备信息导入 (20) 3-2- -2、采集参数设置 (22) 3-2- -3、告警参数设置 (22) 3-2- -4、设备使用配置 (23) 3-3、运行状态检查 (24) 3-3- -1、采集器运行状态检查 (24) 3-3- -2、告警预处理服务运行状态检查 (25) 3-3- -3、 TOMCAT服务运行状态检查 (25) 3-3- -4、作业调度管理进程状态检查 (25) 3-4、故障处理 (25) 3-4- -1、网络故障 (25) 3-4- -2、应用程序故障 (25) 3-5、系统日志 (26) 3-5- -1、采集系统日志 (27) 3-5- -2、告警预处理系统日志 (28)

计算机集群技术的解释

【赛迪网独家特稿】集群技术是使用特定的连接方式,将相对于超级计算机便宜许多的计算机设备结合起来,提供与超级计算机性能相当的并行处理技术。早在七十年代就有人提出可以使用这种集群技术完成并行处理,但是由于受到当时网络交换技术的限制,集群系统在性能上与其他并行处理系统相距甚远,直到网络技术逐渐成熟的今天,它才具备了与超级计算机相匹敌的能力。 什么是集群 集群(Cluster)技术是指一组相互独立的计算机,利用高速通信网络组成一个计算机系统,每个群集节点(即集群中的每台计算机)都是运行其自己进程的一个独立服务器。这些进程可以彼此通信,对网络客户机来说就像是形成了一个单一系统,协同起来向用户提供应用程序、系统资源和数据,并以单一系统的模式加以管理。一个客户端(Client)与集群相互作用时,集群像是一个独立的服务器。 计算机集群技术的出发点是为了提供更高的可用性、可管理性、可伸缩性的计算机系统。一个集群包含多台拥有共享数据存储空间的服务器,各服务器通过内部局域网相互通信。当一个节点发生故障时,它所运行的应用程序将由其他节点自动接管。在大多数模式下,集群中所有的节点拥有一个共同的名称,集群内的任一节点上运行的服务都可被所有的网络客户所使用。 集群的特点 1.提供强大处理能力的高性能计算机系统:计算机集群可以通过负载均衡、并行处理、时间片处理等多种形式,将多台计算机形成高性能计算机集群。对用户端(Client)而言,计算机集群则是一个单一的系统,可以为用户提供高性能的计算机系统,而用户不用关心有多少计算机承担了系统实现的任务,而只需要关注系统的整体处理能力。因此,计算机集群可以用多台普通性能的计算机组成具有高性能的计算机系统,承担只有超级计算机才能胜任的工作。 2.提供高可用性的计算机系统:通过计算机集群技术组成的系统,可以确保数据和应用程序对最终用户的高可用性,而不管故障属于什么类型。即当计算机集群中的节点计算机出现软硬件故障的时候,高可用性集群提供了对软件和硬件失败后的接替。它将服务器镜像到备用系统或节点中,当主节点上的系统崩溃时,冗余节点就从替补角色转换到正式角色,并自动投入应用,从而保证了系统运行的不间断。

曙光IPMI系统管理平台用户使用指南

曙光IPMI系统管理平台 用户使用指南 目录 概述 IPMI是智能型平台管理接口(IntelligentPlatformManagementInterface)的缩写,它是管理企业级服务器系统中所使用的采用的一种工业标准。它为服务器的监控提供了一种智能的管理方式,用户可以利用IPMI监视服务器的物理健康特征,如温度、电压、风扇工作状态、电源状态等。它能够不依赖操作系统独立运行,即使系统本身的运作不正常,或是由于任何原因而无法提供服务,IPMI 仍可正常运作。它适用于Windows、Linux、Solaris或其它混合型操作系统。智能平台管理接口(IPMI) 智能平台管理接口(IPMI)定义了一系列的统一的基于接口的信息,这些信息包括监视器系统硬件健康(风扇速度、温度、电压、电力供应等等)、控制系统组件、和用于以后测试用的关于重要系统事件存储的数据。IPMI提供了远程平台管理功能。 基板管理控制器(BMC) 在IPMI中关键的组成部件是基板管理控制器(BMC),BMC芯片集成于服务器的主板上。BMC在IPMI架构中负责监视和控制系统的可管理设备。BMC通过智能平台管理总线(IPMB)连接着许多传感器。一个子集有12C总线。系统软件与BMC之间的通信用一个keyboardcontrollerstyle(KCS)接口。 BMC具有以下功能: 1.通过系统的串行端口进行访问 2.故障日志记录和SNMP警报发送 3.访问系统事件日志(SystemEventLog,SEL)和传感器状况

4.控制包括开机和关机 5.独立于系统电源或工作状态的支持 6.用于系统设置、基于文本和操作系统控制台的文本控制台重定向 IPMI的相关配置 获取/配置IP地址等信息 IPMI必须配置IP址、子网掩码、网关等信息后才能进行远程管理,配置的方式有以下几种: 在BIOS下进行配置 在启动时按del键(有些为F2键)进入BIOS界面。 选择“Advanced”-“IPMIConfiguration”-“SetLANConfiguration”对IP、掩码、网关和MAC进行设置。IP的分配方式可以选择静态“static”或动态分配“dhcp”。注:各种BIOS界面可能会稍有区别,大同小异。以下为另一种界面: 设置完毕后按F10保存退出。 用DOS工具进行获取/配置 用IPMICFG软件获取。可用IPMICFG在DOS命令行下获取、配置IP等信息。 在windows操作系统下配置 在windows系统下,可以使用工具直接对ipmi地址进行配置 1)通过以下命令查看IPMI设备通道信息 Ipmitool–imsLanprint0查看0通道信息。 Ipmitool–imsLanprint1查看1通道信息。 该命令会列出IPMI的配置信息,包括IP,子网掩码,MAC地址等 一般情况下,IPMI在0或1通道。上示图例中,IPMI设备在1通道。 注:–imsLanprint将列出所有通道的信息。出现上图所示信息,则表明设备支持IPMI。 2)配置IP获取方式为静态方式 –Imslanset1ipsrcstatic 注:该命令行中“1”为通道号,请根据实际情况修改。下同。 3)配置IP地址 –I 4)配置子网掩码 –I 5)配置网关 –I 6)查看配置是否生效

曙光A620服务器

曙光天阔A620r-H服务器 曙光天阔A620r-H服务器是曙光精心打造的一款性能卓越,稳定可靠,配置灵活的新一代双路64位服务器产品。具有处理速度快、可用性强、易管理、高扩展、低功耗和低噪音等特点。A620r-H采用独具特色 的机箱设计,极大地降低了机器的噪音。同时, A620r-H支持两路64位处理器,支持先进的ECC DDR内存,大幅提高了内存带宽,独特的服务器 设计能稳定运行Windows、Red Hat Linux、SUSE Linux等32位和64位主流操作系统,是能适应 多种重要任务环境的新一代服务器。 曙光天阔A620r-H服务器技术参数表 扩展性能 扩展插槽2个PCI-E x16扩展插槽(x8速率) 3个PCI-X 133/100扩展插槽 1个PCI 32bit 33MHz扩展插槽。备注:不支持全高、全长卡 外设接口1个后部串口 1个后部VGA接口 2个后部USB2.0接口,1个前置USB2.0接口2个后置RJ45网口 1个后置标准PS/2鼠标/键盘接口 散热性能 散热风扇数量每处理器独立风扇机箱中部3个风扇每电源模块独立风扇 机箱电源 机箱2U机架式机箱 电源600W单电源,可选600W 1+1冗余电源 随机资料 软件《曙光天阔服务器智能导航软件》(1CD)软件《曙光产品导航光盘》(1CD) 软件《曙光SAS RAID卡配置工具与指南》(1CD)软件《曙光驱动制作工具软件》(1CD)

软件《曙光Gridview服务器管理系统单机版光盘》(1CD) 软件《曙光服务器备份还原软件》(1CD) 机箱尺寸 机箱尺寸718×433×88.1mm(不含箱耳)718×488×88.1mm(含箱耳)满配重量30KG(不含包装、泡沫、导轨等) 操作系统兼容 操作系统Windows Server 2008 32bit/64bit Windows Server 2003 R2 32bit/64bit Red hat Enterprise Linux 5.0 Update 3 64bit SUSE Linux Enterprise Server 10 Update2 64bit 操作系统兼容性和系统配置有很大关系,详细部件兼容性信息请查询曙光产品兼容性列表或咨询曙光公司产品部 环境适应性 振动频率10Hz~150Hz 加速度≤20m/s2 ,振幅≤0.15mm 冲击峰值加速度≤500m/s2 持续时间≤11ms 碰撞峰值加速度≤250m/s2 次数 1000次内持续时间≤6ms

Linux高可用集群系统的结构和原理分析

收稿日期:2007-09-15 第一作者简介:左 婷(1979-),女,吉林省四平市人,现为吉林师范大学信息网络中心研究实习员. 2007年11月 吉林师范大学学报(自然科学版) .4第4期Journal of Jilin Normal University(Natural Science Edition)Nov.2007 Linux 高可用集群系统的结构和原理分析 左 婷1,吴会军2 (1.吉林师范大学信息网络中心,吉林四平136000;2.吉林省水文水资源局,吉林长春130000) 摘 要:通过对目前常用Linux 平台上高可用集群系统的软、 硬件基本结构和工作原理的分析与研究,构建容易扩展、高可用、易维护和管理、高性价比的计算机系统. 关键词:L inux;高可用集群系统;结构;原理 中图分类号:T P393 文献标识码:A 文章编号:1000-1840-(2007)04-0115-02 目前,很多国际知名软件公司和计算机厂商都推出了 自己的集群产品,其中值得一提的是T he H igh A vailability L inux Project 的开放源代码Heartbeat,已经同商业集群软件 一样成熟,而且较后者应用更为灵活.本文将着重介绍SuSE L inux Enterpr i se Server 10平台上Heartbeat2.0.8组成结构 和工作原理.1 Linux 高可用集群系统的基本概念伴随着集群技术的发展,出现了一些关于集群系统的概念和术语.(1)集群资源和集群资源代理.在集群系统中,所有由集 群控制和管理,并将其以单一和统一的形式提供给客户端用 户使用的计算机资源称为集群资源,例如:一种服务、一个 IP 地址、一个磁盘驱动,甚至可以说:除了节点,其它任何软 硬件资源都可以成为集群资源.而集群资源代理是为了控制 和管理某一集群资源而编写的代理程序脚本,集群软件通过 特定集群资源代理来操控某一集群资源,Heartbeat 套件本 身已经包含了一些常用资源代理,开发人员也可以自己按照 一定的规范编写;(2)指定协调者(也称主节点).主节点除了 具有其它一般节点具有的集群节点基本功能外,还负责对整 个集群系统的状态进行监控、分析和转换,对集群系统下达 集群指令,协调各节点的操作等,实际上是整个集群系统的 大脑!,显然一般情况下,整个集群系统只有一个主节点,但 当某些特殊情况发生时,例如主节点不再是集群中的节点, 主节点将发生迁移,即位置发生了变化,另一个节点将代替 它成为主节点;(3)ST ON IT H.英文 Shoot T he Other Node In T he Head !的缩写,代表一种将错误操作的节点进行隔离 的技术,为了防止错误操作的节点对集群资源进行破坏性控 制和操作,使其不断重新启动或关机,从而使其无法取得对 集群资源的控制权;(4)裂脑和仲裁.在某种情况下,由于软 硬件失败导致各节点无法相互确定彼此的状态时,整个集群将被分裂为几个部分,每个部分都想取得对集群资源的控制权,以保证集群的高可用,这种对集群资源的竞争将严重破坏集群资源的完整性和一致性,甚至导致整个集群瘫痪、硬件被损坏的严重后果,这种情况称为裂脑.为了防止裂脑的发生,由仲裁协议决定哪个部分来取得对集群资源的控制 权,为了继续保证系统的高可用,一般将控制权交给节点数 超过原集群节点数一半的部分,同时将其它节点进行隔离; (5)单点故障(失败).单点故障是指由于系统中某一组件的 故障或运行失败从而导致整个集群系统瘫痪和应用服务完 全停止,因此,在高可用集群的构建中应尽量避免单点故障.2 Heartbeat 的主要进程Heartbeat 的所有集群功能都是由它的进程和它们之间相互通信来具体实现的.(1)集群资源管理器(CRM ,Cluster Resource M anager).CRM 是集群系统中最主要的管理进程,它负责对整个集群资源的管理和约束,包括资源的配置及相互间依赖关系,并决定资源运行的状态、位置和时间等.另外它还负责监控本地资源管理器完成这些工作,CRM 通过与系统的每一个组件通信来相互作用和协调操作,CRM 通过heartbeat 通讯模块进行节点间通讯,从CCM 接受当前集群的成员信息,指令ST O NI TH Daremon 如何工作,负责记录系统日志等;(2)策略引擎(PE,CR M Policy Eng ine).PE 是CRM 的一个组件,只能在主节点上运行.PE 的功能是根据当前集群的状态及集群资源的约束配置计算出集群的下一个状态,即为T E 生成将要执行的计划和策略;(3)执行引擎(T E,CRM T ransi tion Engine).T E 也是CRM 的一个组件,只能在主节点上运行.T E 的功能是按照P E 生成的集群状态变化计划和策略,指令集群节点上的LRM 对具体的集群资源进行操作;(4)?115?

4、浪潮gs管理软件日常操作手册

浪潮管理信息系统培训 学 习 资 料 中铁二十局集团有限公司2011年4月四川·乐山

目录 1 系统管理、基础设置 (6) 1.1 客户端配置要求: (6) 1.1.1 采用何种操作系统 (6) 1.1.2 IE浏览器 (6) 1.1.3 ACTIVEX控件的下载 (11) 1.2 软件登录前注意事项 (12) 2 初始化步骤、要点说明 (15) 2.1 用户与职责定义 (15) 2.1.1 系统登录 (15) 2.1.2 职责的定义 (16) 2.1.3 用户的定义 (16) 2.2 基础设置 (16) 2.2.1 部门定义 (16) 2.2.2 员工定义 (17) 2.2.3 往来单位定义 (17) 2.2.4 核算项目定义 (17) 2.2.5 科目定义 (17) 2.2.6 科目核算关系定义 (18) 2.2.7 余额初始 (18) 2.2.8 实时余额同步 (19)

2.2.10输出格式定义(凭证打印格式) 19 2.2.11系统设置 19 2.2.12会计期间维护 20 2.3 报表管理 (20) 2.3.1 新建报表 (20) 2.3.2 新建数据单元 (20) 2.3.3 报表与数据单元关联 (21) 2.3.4 报表格式升级 (22) 2.3.5 报表另存为excel格式 (22) 2.4 固定资产 (23) 2.4.1 卡片初始 (23) 2.4.2 资产增加 (23) 2.4.3 资产减少 (24) 2.4.4 资产变更 (24) 2.4.5 大修理记录 (25) 2.4.6 固定资产计提折旧 (25) 2.4.7 固定资产模块月结 (25) 2.5 工资 (26)

曙光DS800-G25磁盘阵列用户手册V1.1

DS800-G25 用户手册 DAWNING INFORMATION INDUSTRY CO.,LTD.

声明 本手册的用途在于帮助您正确地使用曙光公司服务器产品(以下称“本产品”),在安装和第一次使用本产品前,请您务必先仔细阅读随机配送的所有资料,特别是本手册中所提及的注意事项。这会有助于您更好和安全地使用本产品。请妥善保管本手册,以便日后参阅。 本手册的描述并不代表对本产品规格和软硬件配置的任何说明。有关本产品的实际规格和配置,请查阅相关协议、装箱单、产品规格配置描述文件,或向产品的销售商咨询。 如您不正确地或未按本手册的指示和要求安装、使用或保管本产品,或让非曙光公司授权的技术人员修理、变更本产品,曙光公司将不对由此导致的损害承担任何责任。 本手册中所提供照片、图形、图表和插图,仅用于解释和说明目的,可能与实际产品有些差别,另外,产品实际规格和配置可能会根据需要不时变更,因此与本手册内容有所不同。请以实际产品为准。 本手册中所提及的非曙光公司网站信息,是为了方便起见而提供,此类网站中的信息不是曙光公司产品资料的一部分,也不是曙光公司服务的一部分,曙光公司对这些网站及信息的准确性和可用性不做任何保证。使用此类网站带来的风险将由您自行承担。 本手册不用于表明曙光公司对其产品和服务做了任何保证,无论是明示的还是默示的,包括(但不限于)本手册中推荐使用产品的适用性、安全性、适销性和适合某特定用途的保证。对本产品及相关服务的保证和保修承诺,应按可适用的协议或产品标准保修服务条款和条件执行。在法律法规的最大允许范围内,曙光公司对于您的使用或不能使用本产品而发生的任何损害(包括,但不限于直接或间接的个人损害、商业利润的损失、业务中断、商业信息的遗失或任何其他损失),不负任何赔偿责任。 对于您在本产品之外使用本产品随机提供的软件,或在本产品上使用非随机软件或经曙光公司认证推荐使用的专用软件之外的其他软件,曙光公司对其可靠性不做任何保证。 曙光公司已经对本手册进行了仔细的校勘和核对,但不能保证本手册完全没有任何错误和疏漏。为更好地提供服务,曙光公司可能会对本手册中描述的产品软件和硬件及本手册的内容随时进行改进或更改,恕不另行通知。如果您在使用过程中发现本产品的实际情况与本手册有不一致之处,或您想得到最新的信息或有任何问题和想法,欢迎致电400-810-0466或登录曙光公司服务网站https://www.sodocs.net/doc/716663499.html,垂询。 商标和版权 “SUGON”及图标是曙光信息产业股份有限公司的商标或注册商标。 “曙光”及图标是曙光信息产业股份有限公司的商标或注册商标,文中“曙光信息产业股份有限公司”简称“曙光公司”。 “Intel”、“Xeon”图标是Intel公司的注册商标。 “Microsoft”、“Windows”、“Windows Server”及“Windows Server System”是微软公司的商标或注册商标。 上面未列明的本手册提及的其他产品、标志和商标名称也可能是其他公司的商标或注册商标,并由其各自公司、其他性质的机构或个人拥有。 在本用户手册中描述的随机软件,是基于最终用户许可协议的条款和条件提供的,只能按照该最终用户许可协议的

相关文档

- 曙光集群简明使用手册

- 新曙光集群系统(Pluto)简明用户手册

- 高性能集群作业调度系统

- 高性能计算机与曙光集群系统方案

- 曙光Gridview大型机监控管理系统V1.1技术白皮书V1.0(1)

- 曙光PHPC100个人高性能计算机技术白皮书V1.

- 高性能计算机和曙光集群系统

- 【通用】曙光集群用户使用手册.doc

- 高性能集群作业调度系统

- 曙光集群负载均衡系统DCLB-1100技术白皮书V1.0

- 曙光高性能集群系统使用及管理-201408

- 曙光公司数据库系统服务器解决方案

- 高性能集群作业调度系统PPT课件

- 曙光Gridview2.0安装维护手册2.0

- 曙光集群用户使用手册

- 高性能计算机和曙光GHPC1000集群系统.

- 曙光天阔I610r-GV服务器用户手册

- 华师大高性能计算集群作业调度系统简明手册

- 曙光服务器配置

- 曙光集群用户使用手册